基于深度極限學習機的高光譜遙感影像分類研究

呂 飛, 韓 敏

( 大連理工大學 電子信息與電氣工程學部, 遼寧 大連 116024 )

0 引 言

高光譜遙感圖像主要包含空間、輻射和光譜3個至關重要的信息,其圖像在空間成像的過程中,使用光譜技術和光學成像技術,并將兩種技術融合在一起,將每個目標像素空間分散后,得到幾十至幾百個窄帶,從而進行連續的光譜覆蓋,這些信息和技術使得地物的準確分類成為了可能[1-2].將加大數據維數,選取更多數據樣本作為前提,同時擴展頻帶信息,使得模型的冗余度加大,雖然這樣提高了高光譜遙感圖像的光譜分辨率,但是卻大大影響了模型數據的處理速度,同時也降低了模型的精度,影響目標識別.此外,Hughes現象是一種高維遙感數據中常見現象,表征了高維數據與低樣本量間的問題,是現在國內外相關課題組研究的重點[3].

針對Hughes現象,一般情況下采用減少維度的方法.減少維度在某種程度上,可以有效處理高維數據和低樣本量間的問題,削弱了該現象所帶來的不好的分類結果,降低了模型的信息冗余度,有效地增強了模型的計算效率.針對高光譜遙感數據,適用的降維方法有特征提取和波段選擇.特征提取方法使用模型空間轉換,數據樣本直接從高維空間映射到低維空間,在高光譜遙感數據分類中起到了非常重要的作用.但使用特征提取方法也存在著一些不足.針對高光譜遙感數據,使用波段選擇方法可以保持原有的性質,有效地反映相關波段的分類.但該方法也存在著一些局限性:數據量大,操作煩瑣,處理時間長,對模型的適用性具有很大的束縛,不能很好地提高模型的魯棒性,有時還會導致模型整體的精度下降[3].

深度學習可以視為神經網絡的延續與升華,通過模擬大腦的學習過程,從低級到高級地輸入數據逐步進行特征提取,最終形成模式分類的理想特征,從而提高分類精度.Hinton等采用深度學習模型實現數據的維數縮減和分類,并指出神經網絡的深層結構可以更深入地學習對象的基本特征,分類性能強[4-8].目前,深度學習已經在語音識別、圖像識別和信息檢索等方面取得了較好的成果[9-11].然而深度學習應用于高光譜遙感圖像分類相對較少[12-18],為此本文提出基于深度極限學習機(deep extreme learning machine,D-ELM)的高光譜遙感圖像分類方法,并應用于高光譜遙感圖像分類以驗證其有效性.

1 深度神經網絡原理

1.1 自動編碼器

自動編碼器(auto-encoder,AE)主要分為3個部分:輸入層、隱含層和輸出層.其3層結構的作用是將輸出與輸入盡量保持一致.其使用過程主要包括編碼和解碼兩部分.編碼是先對訓練數據進行線性映射,再進行非線性變換,求得隱含層表示.設樣本集為X={xi} (i=1,2,…,N),輸入樣本xi對應的隱含層表示為

hi=f(xi)=gh(W1xi+b1)

(1)

其中W1和b1分別代表編碼時輸入層與隱含層之間的權重和偏置,gh(·)表示隱含層的激勵函數.解碼是將編碼后的輸出轉換成原空間,求得的解碼信號

x^

i可表示為

i=g(xi)=go(W2hi+b2)

(2)

其中W2和b2分別代表解碼時輸入層與隱含層之間的權重和偏置,go(·)表示輸出層的激勵函數.自動編碼器的目的就是使輸出和輸入趨于一致,模型參數將誤差降到最低,從而構建效果最優的模型.其目標函數如下:

J(W1,W2,b1,b2)=argminW1,W2,b1,b2∑Ni=1xi-x^i22

(3)

訓練完網絡第1層后,再把隱含層的激活值作為下一層網絡的輸入,依此類推,形成棧式自動編碼器(stacked auto-encoder,SAE).

1.2 棧式自動編碼器

棧式自動編碼器主要應用于模型學習和特征提取.棧式自動編碼器第1步是確定參數,在該環節適用貪婪算法,對網絡的每一層進行計算;參數確定后,再從網絡最上層調整網絡參數.若最上層不添加標簽信息,則該學習過程為無監督的特征訓練過程; 若最上層加入樣本數據的標簽信息,不斷調整網絡參數,則這個學習過程為有監督的特征訓練過程.棧式自動編碼器網絡架構如圖1所示.

在圖1中,網絡一共有M層,最高層的隱含層就是網絡的輸出.一般情況下,將該網絡和softmax分類器一起使用,整合后的模型可以達到分類識別的目的.網絡整體參數微調的目標函數為

(4)

其中yi表示樣本xi對應的標簽,Wk和bk分別表示整個網絡各層的權重和偏置[9].

圖1 棧式自動編碼器網絡架構Fig.1 The network architecture of SAE

2 特征提取

高光譜遙感圖像數據維度偏高,數據量較少,維度相互間具有較強的內聚性.深度神經網絡模型對輸入數據的數量有較高的要求,數據量需要達到一定程度,深度神經網絡模型才能發揮比較好的作用.為此必須先對數據進行處理,在數據作為輸入樣本進入模型前,對數據進行添加和降維.

高光譜遙感圖像訓練數據少,不能很好地滿足深度神經網絡模型的要求,本文采用鄰近像元相加求平均值的方法進行數據量的擴充,利用空間相關性,在不改變樣本屬性的前提下,增加一些新的樣本數據,提高了模型的訓練數據量.

高光譜遙感圖像數據具有同類別相同區域密度較高的特點,即具有較好的空間相關性.所以利用這個特點,對輸入數據進行整體調整,可以有效提高模型總體分類精度.如果簡單地采用將訓練像元和周圍鄰居像元相加作為輸入的話,就會帶來很高的維度和很大的冗余.

為了獲取較低的維度,并且保證一定的空間相關性,需要使用特征提取方法對訓練樣本數據進行降維.棧式自動編碼器和主成分分析(principal component analysis,PCA)都可以對數據進行降維.區別在于棧式自動編碼器為非線性降維,而主成分分析為線性降維.相比之下,棧式自動編碼器能夠更好地保留數據特征.因此,本文采用棧式自動編碼器進行數據降維.

3 基于深度極限學習機的高光譜圖像分類

3.1 基于極限學習機的自動編碼器

除了基于極限學習機[19](extreme learning machine,ELM)的單隱層前饋神經網絡,ELM也被用于構建多層感知機的自動編碼器.概念上,自動編碼器在多層學習框架里作為某種特征提取器.數學上,自動編碼器將輸入數據x映射到高維表示,然后用隱式表示y通過一個確定性的映射y=hθ(x)=gh(A·x+b),由θ={A,b}參數化,其中A為d′×d權值矩陣,b為偏置向量.然后,隱式表示y映射回重構向量z在輸入空間z=hθ′(y)=go(A′·y+b′),其中θ′={A′,b′}.

使用隨機映射輸出作為隱式表示y,可容易地構建基于ELM的自動編碼器.x的重構可以看作是一個ELM學習問題,其中A′可通過求解正則化最小均方優化問題得到.由于原始ELM中使用L2懲罰,ELM自動編碼提取的特征趨向于稠密,并可能具有冗余值.在這種情況下,更稀疏的解是首選.

與傳統深度學習算法中使用的自動編碼器不同,ELM自動編碼器的輸入權值是通過搜索隨機空間的返回路徑建立的.ELM學習理論已證明,訓練具有隨機映射輸入權值的ELM已足夠逼近任意的輸入數據.也就是說,如果按照ELM的概念訓練自動編碼器,自動編碼器一旦初始化,就不再需要調優.

此外,為獲得輸入更完備的特征,L1優化被用于構建ELM自動編碼器.因此,ELM自動編碼器的優化模型可以表示為

(5)

其中X表示輸入數據,H表示隨機映射輸出,β表述想要獲得的隱含層權值.在現存的深度學習方法中,X通常是基于β的編碼輸出,而β在優化的迭代中是需要進行調整的.在ELM自動編碼器中,由于隱含層特征提取利用了隨機映射,X為原始數據,H為無須進行調整的隨機初始化輸出.

下面將給出L1優化問題的求解描述.為表達清晰,將目標函數(5)重定義為

Fβ=p(β)+q(β)

(6)

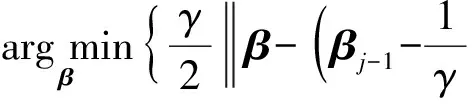

本文采用快速迭代收縮閾值算法(fast iterative shrinkage-thresholding algorithm, FISTA) 求解優化問題(6).快速迭代收縮閾值算法最小化光滑凸函數的計算復雜度為O(1/j2),其中j表示迭代次數.快速迭代收縮閾值算法的實施細節如下:

(2)令y1=β0∈Rn,t1=1為初始點,開始迭代.對j(j≥1)有:

①βj=sγ(yj),其中sγ由下式計算得出:

(7)

通過計算上面的迭代步,可從被干擾的數據中恢復數據.通過將結果基于β作為ELM自動編碼器的權值,輸入和學習特征的內積可形成原始數據的完備表示.

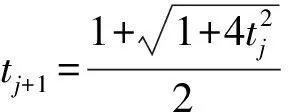

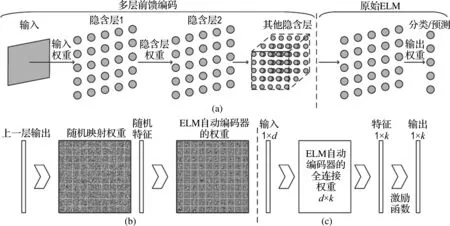

3.2 深度極限學習機

深度極限學習機基于如圖2所示的多層框架.與傳統深度學習算法的貪婪訓練框架不同,深度極限學習機訓練框架在結構上分為兩個不同的階段:無監督特征表示,監督特征分類.在第1階段,基于ELM的自動編碼器從輸入數據中提取多層稀疏特征.在第2階段,原始ELM回歸被用于進行最終的決策.

在無監督特征學習之前,原始輸入數據需轉化為ELM隨機特征空間,可以幫助探索訓練樣本間的隱含信息.然后,進行N層無監督學習以獲得最終的高層稀疏特征.數學上,每個隱含層的輸出可以表示為

Hi=gh(Hi-1·β)

(8)

其中Hi為第i層(i∈[1,k])輸出,Hi-1為第i-1層輸出,β為輸出權值.需注意,深度極限學習機的每個隱含層是獨立的模塊,并且功能上作為獨立的特征提取器.隨著層數的增加,結果特征變得更加完備.當上一層的特征被提取后,當前層的權值或參數將會固定,并不再進行微調.

圖2 多層極限學習機流程圖Fig.2 The flow diagram of multilayer ELM

由圖2(a)可以看出,在深度極限學習機的無監督層級訓練后,第k層的結果輸出被視為從輸入數據提取的高層稀疏特征.當被用于分類時,這些特征被隨機擾動,然后被用作監督ELM回歸的輸入以得到最終結果.對Hk進行擾動是因為需要對輸入進行隨機映射以保持ELM的通用逼近能力.

4 仿真實例

4.1 實驗數據

4.1.1 AVIRIS數據 第1組實驗數據是高光譜遙感數據92AV3C,于1992年6月由機載可見光/紅外成像光譜儀(AVIRIS)拍攝于美國印第安納州西北部印度松林測試地[3],該數據屬于公共實驗數據,被大多數高光譜研究人員使用,方便研究者相互對比、改進算法.

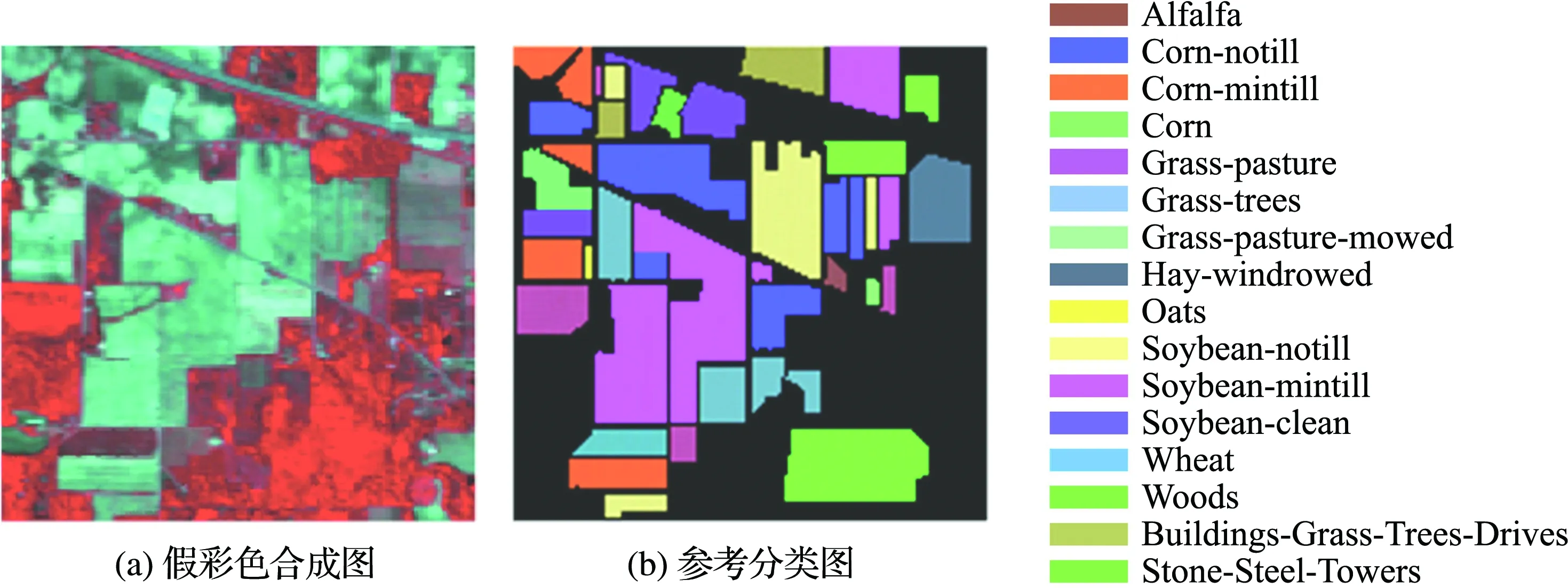

圖3中圖像大小為145 pixel×145 pixel,波長為0.40~2.50 μm;原始波段為220個,除去20個水吸收波段(104~108,150~163,220)后的波段一共有200個;圖像的空間分辨率約為20 m;光譜分辨率小于10 nm.圖3(a)是AVIRIS圖像的假彩色合成圖,圖3(b)是地物信息參考分類圖.AVIRIS圖像數據的地物類別情況如表1所示.針對16類地物類別,隨機選取10%樣本數據作為訓練樣本,剩余90%樣本數據作為測試樣本.

4.1.2 ROSIS數據 第2組實驗數據是使用反射光學系統成像光譜儀(ROSIS)在Pavia大學(University of Pavia,PU)拍攝的.該數據空間分辨率為1.3 m,光譜波長為0.43~0.86 μm,共有103個波段.主要拍攝的是校園建筑和環境.將該光譜圖像的地物分為9類,具體信息如表2所示,示意圖如圖4所示.針對9類地物類別,選取10%樣本數據作為訓練樣本,剩余90%樣本數據作為測試樣本.

圖3 AVIRIS圖像示意圖Fig.3 The schematic diagram of AVIRIS image

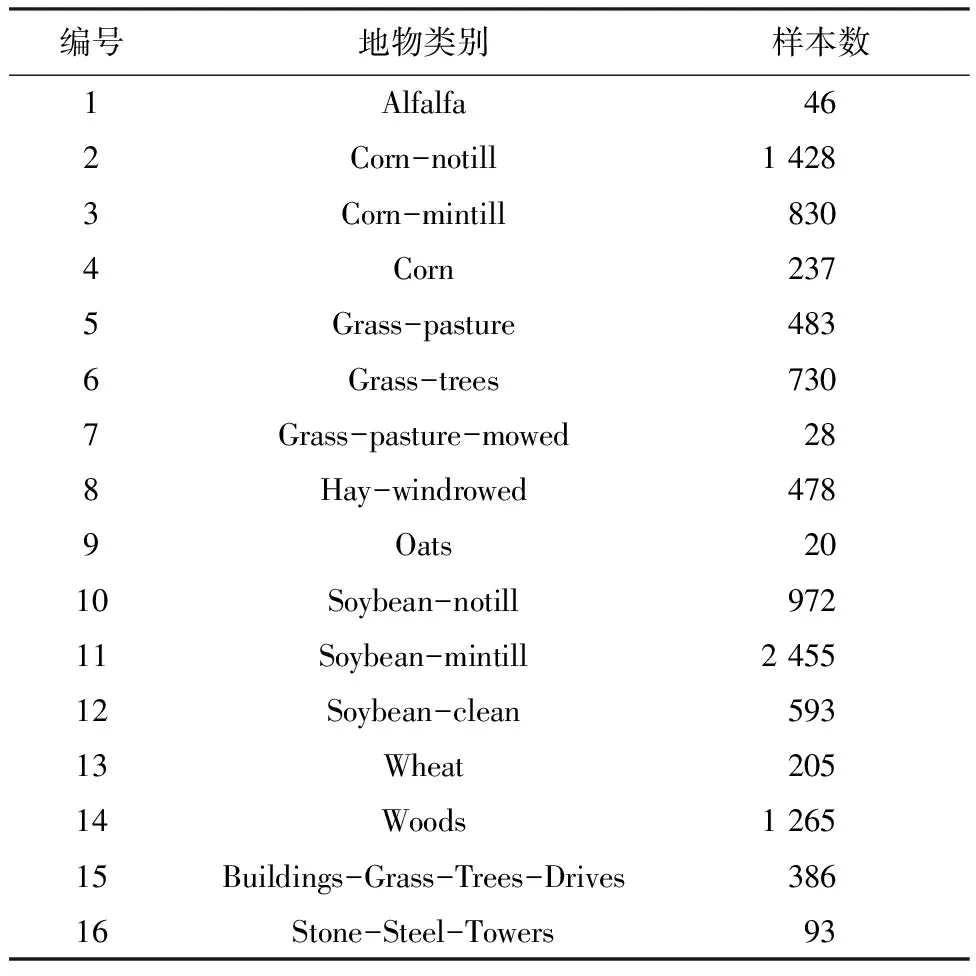

表1 AVIRIS高光譜遙感數據的地物類別及樣本數

Tab.1 The ground category and sample number of AVIRIS hyperspectral remote sensing data

編號地物類別樣本數1Alfalfa462Corn-notill14283Corn-mintill8304Corn2375Grass-pasture4836Grass-trees7307Grass-pasture-mowed288Hay-windrowed4789Oats2010Soybean-notill97211Soybean-mintill245512Soybean-clean59313Wheat20514Woods126515Buildings-Grass-Trees-Drives38616Stone-Steel-Towers93

表2 ROSIS高光譜遙感數據的地物類別及樣本數

Tab.2 The ground category and sample number of ROSIS hyperspectral remote sensing data

編號地物類別樣本數1Asphalt66312Meadows186493Gravel20994Trees30645PaintedmetalSheets14356BareSoil50297Bitumen13308Self-BlockingBricks36829Shadows947

圖4 ROSIS圖像示意圖Fig.4 The schematic diagram of ROSIS image

4.2 實驗方法

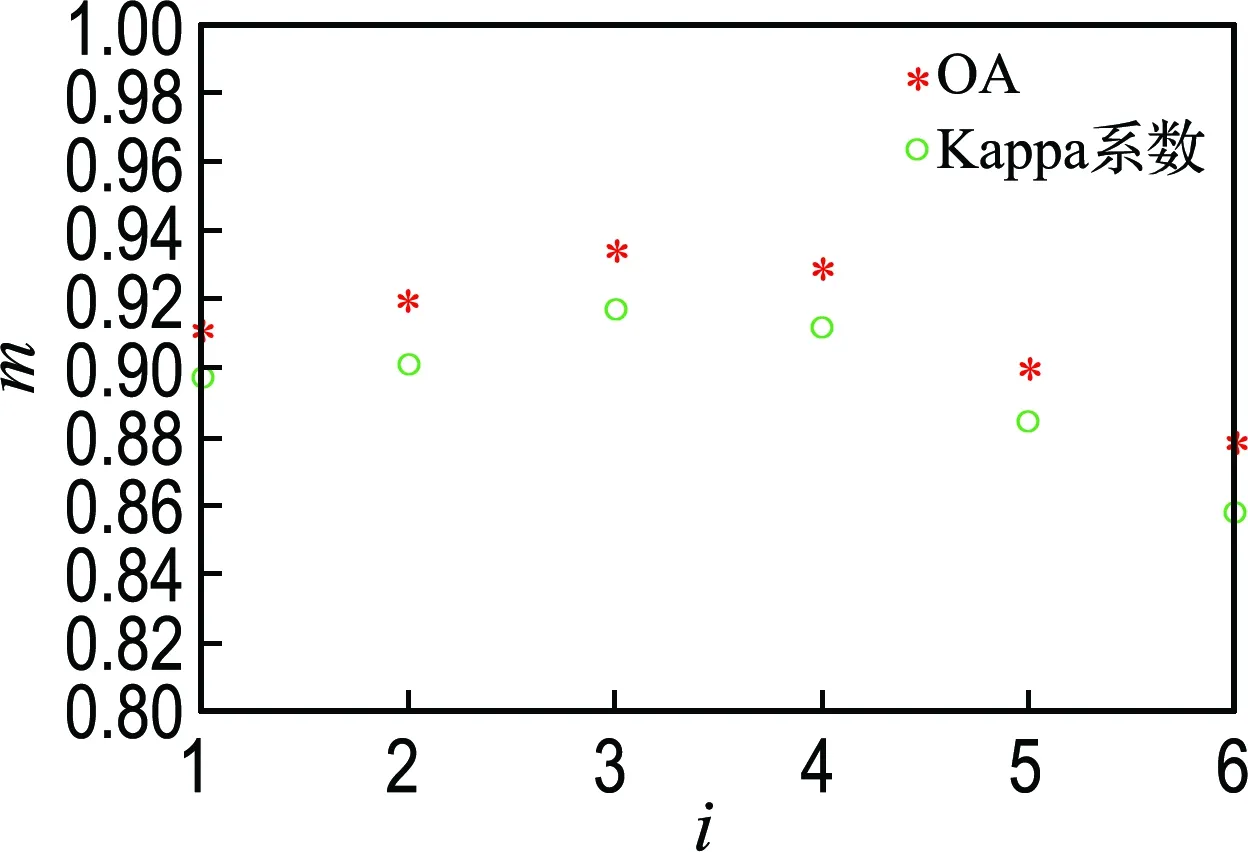

針對4.1節中選取的兩組數據,使用AVIRIS進行實驗步驟說明.首先,使用鄰近像元相加求平均值的方法對訓練樣本數據進行擴充,在實驗過程中,設置擴充后的數據量是原訓練樣本的10倍.然后,通過實驗確定D-ELM隱含層的層數.分別使用不同層數對樣本進行實驗.隱含層選取1~6,分別求得總體分類精度(OA)和Kappa系數,如圖5所示.

圖5 不同隱含層層數對應的總體分類精度和 Kappa系數Fig.5 The OA and Kappa coefficient of different hidden layer number

從圖5可以看出,隨著隱含層層數的不斷增加,總體分類精度和Kappa系數呈現先上升再下降的現象,對比可以看出當層數為3時,所得的總體分類精度和Kappa系數最大.因此,確定在實驗過程中,隱含層層數為3.

在隱含層層數確定的基礎上進行實驗.通過D-ELM算法得到混淆矩陣,效果最好的一組信息值為對角矩陣diag{46,1 428,830,237,483,730,28,478,20,972,2 455,593,205,1 265,386,93}.

4.3 實驗結果

4.3.1 AVIRIS數據實驗結果 由4.2節中所得的混淆矩陣,采用本文D-ELM方法計算得到總體分類精度為0.934 0,Kappa系數為0.917 2.與ELM[19]、SVM和ELMK[20]方法的總體分類精度和Kappa系數比較如表3所示.

從表3可以看出,本文D-ELM方法獲得了較好的分類結果.針對該組實驗數據,國內外許多團隊進行了仿真,Galal等[21]用多個光譜特征,并在整個波段和波段的某個子集分別進行分類,得到的總體分類精度分別為0.902 0和0.916 0.Alajlan等[22]提出了基于監督-非監督的分類方法,得到了0.915 0的總體分類精度.Camps-Valls等[23]結合空間信息和光譜信息的分割方法得到了0.918 0的總體分類精度和0.910 0的Kappa系數.從總體分類精度和Kappa系數的對比來看,本文方法分類結果較好.

表3 AVIRIS高光譜遙感數據總體分類精度和Kappa系數比較

Tab.3 The OA and Kappa coefficient comparison of AVIRIS hyperspectral remote sensing data

方法總體分類精度Kappa系數ELM[19]0.87460.8489SVM0.87940.8628ELMK[20]0.91380.9013D-ELM0.93400.9172

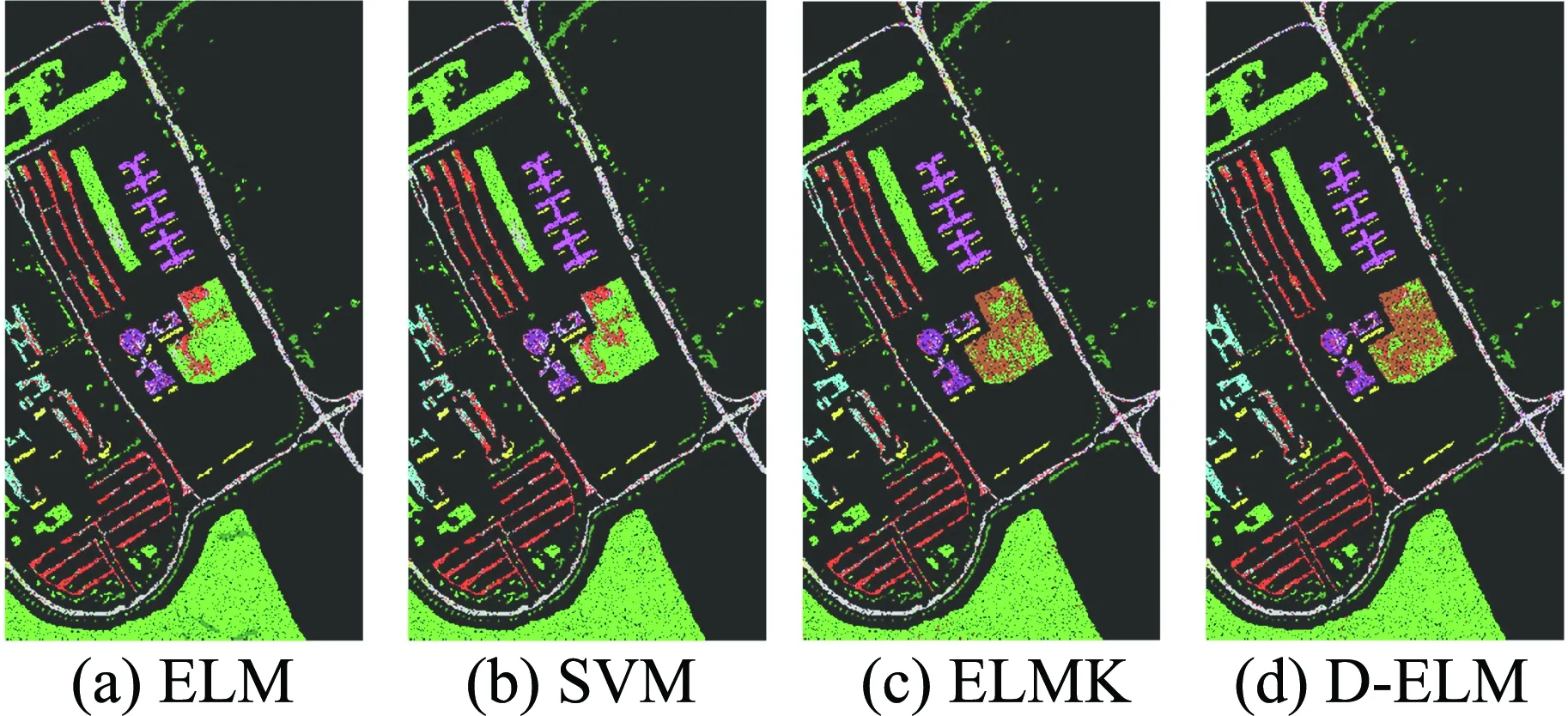

此外,將不同分類方法的分類結果以圖像形式顯示,如圖6所示.

圖6 AVIRIS圖像分類結果示意圖Fig.6 The classification result schematic diagram of AVIRIS image

從圖6可以看出,D-ELM方法相比其他3種方法對類別10和11的分類結果有明顯的優勢.對比類別10可以看出,D-ELM分類結果錯誤樣本點最少,SVM分類結果錯誤樣本點最多.對比類別11可以看出,ELM、SVM和D-ELM分類結果錯誤樣本點分布較為稀疏,ELMK分類結果錯誤樣本點在小區域密度較大;從錯誤樣本點數量上看,D-ELM方法的錯誤率最低.但D-ELM對其他類別的處理效果優勢不是特別明顯,從結果分析來看,類別10和11的空間信息更適合D-ELM 方法.

4.3.2 ROSIS數據實驗結果 采用D-ELM方法計算得到總體分類精度為0.946 5,Kappa系數為0.923 8.針對ROSIS圖像數據,不同分類方法的總體分類精度和Kappa系數比較如表4所示.

表4 ROSIS高光譜遙感數據總體分類精度和Kappa系數比較

Tab.4 The OA and Kappa coefficient comparison of ROSIS hyperspectral remote sensing data

方法總體分類精度Kappa系數ELM[19]0.88490.8580SVM0.89430.8734ELMK[20]0.92210.9123D-ELM0.94650.9238

將不同分類方法的分類結果以圖像形式顯示,如圖7所示.

圖7 ROSIS圖像分類結果示意圖Fig.7 The classification result schematic diagram of ROSIS image

從圖7可以看出,對比類別2,ELM方法出現了局部錯誤數據點密度較大的情況,可以看出ELM方法對類別2的分類結果不如其他3種方法.對比類別6可以看出,ELM和SVM方法出現了大范圍數據點錯分成類別2的現象,過擬合嚴重,并未獲得很好的預期效果,而ELMK和D-ELM 方法也有局部錯分的現象,錯誤率較低,并且對比可以看出,D-ELM對類別6的分類結果更好.從樣本分類的整體來看,D-ELM方法與其他3種方法比較,在對每個類別數據處理的過程中,均顯示出了較高的魯棒性,以及對不同類別數據較強的適應性,分類結果精度較高.

5 結 語

本文提出一種基于深度極限學習機的高光譜遙感影像分類方法,用于解決高光譜遙感分類中數據類型復雜、訓練樣本多帶來的分類結果差、分類效率低等問題.該方法首先對原訓練集進行特征分割,對分割出的子特征進行SAE變換,然后將深度極限學習機方法應用到SAE變換后的數據上,再通過實驗確定深度極限學習機的隱含層層數,從而確定最終的模型結構.將最終模型應用于AVIRIS和ROSIS兩組高光譜遙感數據,并與ELM、SVM和ELMK 3種方法進行比較,從總體分類精度和分類結果圖像上,均能看出本文方法大大提高了總體分類精度,具有較高的適應性.同時針對AVIRIS高光譜遙感數據,也與當前一些復雜方法進行了比較, 可以看出本文方法同樣具有較高的總體分類精度.

此外,在對兩組數據進行實驗過程中,發現本文方法與其他3種方法相比,方法效率受隱含層層數限制較大,在今后的研究過程中,重點放在提高方法的效率上.

[1] 梁 亮,楊敏華,李英芳. 基于ICA與SVM算法的高光譜遙感影像分類[J]. 光譜學與光譜分析, 2010,30(10):2724-2728.

LIANG Liang, YANG Minhua, LI Yingfang. Hyperspectral remote sensing image classification based on ICA and SVM algorithm [J].SpectroscopyandSpectralAnalysis, 2010,30(10):2724-2728. (in Chinese)

[2]譚 琨,杜培軍. 基于支持向量機的高光譜遙感圖像分類[J]. 紅外與毫米波學報, 2008,27(2):123-128.

TAN Kun, DU Peijun. Hyperspectral remote sensing image classification based on support vector machine [J].JournalofInfraredandMillimeterWaves, 2008,27(2):123-128. (in Chinese)

[3]樊利恒,呂俊偉,鄧江生. 基于分類器集成的高光譜遙感圖像分類方法[J]. 光學學報, 2014,34(9):91-101.

FAN Liheng, Lü Junwei, DENG Jiangsheng. Classification of hyperspectral remote sensing images based on bands grouping and classification ensembles [J].ActaOpticaSinica, 2014,34(9):91-101. (in Chinese)

[4]HINTON G E, OSINDERO S, TEH Y W. A fast learning algorithm for deep belief nets [J].NeuralComputation, 2006,18(7):1527-1554.

[5]CHI M M, PLAZA A, BENEDIKTSSON J A,etal. Big data for remote sensing: Challenges and opportunities [J].ProceedingsoftheIEEE, 2016,104(11):2207-2219.

[6]CHEN Yushi, LIN Zhouhan, ZHAO Xing,etal. Deep learning-based classification of hyperspectral data [J].IEEEJournalofSelectedTopicsinAppliedEarthObservationsandRemoteSensing, 2014,7(6):2094-2107.

[7]CHAN T H, JIA K, GAO S H,etal. PCANet:A simple deep learning baseline for image classification? [J].IEEETransactionsonImageProcessing, 2015,24(12):5017-5032.

[8]PENATTI O A B, NOGUEIRA K, DOS SANTOS J A. Do deep features generalize from everyday objects to remote sensing and aerial scenes domains? [C] //2015IEEEConferenceonComputerVisionandPatternRecognitionWorkshops,CVPRW2015. Boston: IEEE Computer Society, 2015:44-51.

[9]耿 杰,范劍超,初佳蘭,等. 基于深度協同稀疏編碼網絡的海洋浮筏SAR圖像目標識別[J]. 自動化學報, 2016,42(4):593-604.

GENG Jie, FAN Jianchao, CHU Jialan,etal. Research on marine floating raft aquaculture SAR image target recognition based on deep collaborative sparse coding network [J].ActaAutomaticaSinica, 2016,42(4):593-604. (in Chinese)

[10]劉大偉,韓 玲,韓曉勇. 基于深度學習的高分辨率遙感影像分類研究[J]. 光學學報, 2016,36(4):306-314.

LIU Dawei, HAN Ling, HAN Xiaoyong. High spatial resolution remote sensing image classification based on deep learning [J].ActaOpticaSinica, 2016,36(4):306-314. (in Chinese)

[11]李 紅,劉 芳,楊淑媛,等. 基于深度支撐值學習網絡的遙感圖像融合[J]. 計算機學報, 2016,39(8):1583-1596.

LI Hong, LIU Fang, YANG Shuyuan,etal. Remote sensing image fusion based on deep support value learning networks [J].ChineseJournalofComputers, 2016,39(8):1583-1596. (in Chinese)

[12]ZHAO Wenzhi, GUO Zhou, YUE Jun,etal. On combining multiscale deep learning features for the classification of hyperspectral remote sensing imagery [J].InternationalJournalofRemoteSensing, 2015,36(13):3368-3379.

[13]CHEN Yushi, ZHAO Xing, JIA Xiuping. Spectral-spatial classification of hyperspectral data based on deep belief network [J].IEEEJournalofSelectedTopicsinAppliedEarthObservationsandRemoteSensing, 2015,8(6):2381-2392.

[14]YUE Jun, ZHAO Wenzhi, MAO Shanjun,etal. Spectral-spatial classification of hyperspectral images using deep convolutional neural networks [J].RemoteSensingLetters, 2015,6(6):468-477.

[15]李 鐵,孫勁光,張新君,等. 高光譜遙感圖像空譜聯合分類方法研究[J]. 儀器儀表學報, 2016,37(6):1379-1389.

LI Tie, SUN Jinguang, ZHANG Xinjun,etal. A spectral-spatial joint classification method of hyperspectral remote sensing image [J].ChineseJournalofScientificInstrument, 2016,37(6):1379-1389. (in Chinese)

[16]戴曉愛,郭守恒,任 淯,等. 基于堆棧式稀疏自編碼器的高光譜影像分類[J]. 電子科技大學學報, 2016,45(3):382-386.

DAI Xiaoai, GUO Shouheng, REN Yu,etal. Hyperspectral remote sensing image classification using the stacked sparse autoencoder [J].JournalofUniversityofElectronicScienceandTechnologyofChina, 2016,45(3):382-386. (in Chinese)

[17]李新國,黃曉晴. 一種基于DBN的高光譜遙感圖像分類方法[J]. 電子測量技術, 2016,39(7):81-86.

LI Xinguo, HUANG Xiaoqing. Deep neural networks based on hyperspectral image classification [J].ElectronicMeasurementTechnology, 2016,39(7):81-86. (in Chinese)

[18]TANG Jiexiong, DENG Chenwei, HUANG Guangbin. Extreme learning machine for multilayer perceptron [J].IEEETransactionsonNeuralNetworksandLearningSystems, 2016,27(4):809-821.

[19]HUANG G B, ZHU Q Y, SIEW C K. Extreme learning machine:Theory and applications [J].Neurocomputing, 2006,70(1/2/3):489-501.

[20]HUANG Guangbin, ZHOU Hongming, DING Xiaojian,etal. Extreme learning machine for regression and multiclass classification [J].IEEETransactionsonSystems,Man,andCybernetics,PartB:Cybernetics, 2012,42(2):513-529.

[21]GALAL A, HASAN H, IMAM I F. Learnable hyperspectral measures [J].EgyptianInformaticsJournal, 2012,13(2):85-94.

[22]ALAJLAN N, BAZI Y, MELGANI F,etal. Fusion of supervised and unsupervised learning for improved classification of hyperspectral images [J].InformationSciences, 2012,217:39-55.

[23]CAMPS-VALLS G, TUIA D, BRUZZONE L,etal. Advances in hyperspectral image classification:Earth monitoring with statistical learning methods [J].IEEESignalProcessingMagazine, 2014,31(1):45-54.