汽車輔助駕駛系統動態目標檢測方法

, ,, ,

(1.河南科技大學 車輛與交通工程學院,河南 洛陽 471003; 2.海軍航空工程學院 電子信息工程系,山東 煙臺 264001)

0 概述

基于計算機視覺的動態障礙物檢測在汽車輔助駕駛系統中具有重要應用價值,其利用車載攝像機獲取車前一定范圍內的視頻圖像檢測障礙物,從而估計出潛在的危險以便采取安全策略避免交通事故。但在行車過程中,車速和天氣的變化以及開放的車行環境下視頻背景的復雜多樣性對障礙物檢測的魯棒性提出了較高的要求,同時由于攝像機隨車體運行,因此運動背景下動態障礙物的檢測以及檢測的實時性要求進一步增加了算法的設計難度。

與背景差分法對背景模型的依賴和光流法的計算高復雜度相比,相鄰幀間差分法用連續的2幀或者3幀圖像逐像素差分消除背景的影響,對光線等環境因素有較強的適應性,對動態變化的場景非常有效。該方法包括背景全局運動補償和目標檢測2個主要步驟。文獻[1]從理論上分析了全局背景補償的優勢,發現參數估計值直接決定幀間背景的配準精度,進而影響目標檢測效果。

文獻[2]方法采用圖像灰度編碼實現快速匹配,但對非線性變化的局部光照匹配容易發生錯誤。文獻[3]方法基于塊匹配減少計算量,但當攝像機有明顯的非線性運動時,準確性受到影響。文獻[4]采用固定閾值去除外點以提高參數估計的精度,但固定閾值在實際應用中受限。文獻[5]提取殘差均值代替固定閾值對文獻[4]方法進行改進,但該方法不能準確地估計全局運動參數。文獻[6]將Sobel邊緣檢測與小波變換結合,提出遞推多模板匹配方法,雖然加快了速度,但該方法對圖像的角度偏差不適應。文獻[7]利用主成分分析法對SIFT算法改進,但需要先驗知識,否則會增加計算量,且投影矩陣輸入圖像有限制。文獻[8]提出的GLOH算子增加了SIFT算子的魯棒性和獨特性,但同樣需要大量的先驗樣本。文獻[9]方法利用全局信息來減少誤匹配,對局部相似造成的錯誤配準效果明顯,但計算較復雜,且丟失了SIFT算子的尺度不變性。文獻[10]使用Gabor濾波器對SIFT描述符進行改進,但增加了算法的計算復雜度。

相比于塊配準參數估計,基于特征點的全局補償參數估計能夠突破圖像旋轉、縮放及仿射變換等攝像機非平移運動的限制,更適合汽車輔助駕駛系統車前動態障礙物檢測。為此,本文提出基于SIFT算子背景補償和假設檢驗的目標檢測方法,通過小波和動態幀間特征點位置估計改進SIFT算法,以增強參數估計的實時性,并利用改進假設檢驗方法提高動態目標的檢測準確性。

1 基于改進SIFT特征配準的全局運動補償

SIFT[11-12]特征點對圖像的旋轉、尺度縮放以及光照變化具有較好的穩定性,對目標的運動、遮擋、噪聲等因素也有很好的魯棒性[13],但其128維描述符和特征點一一比較的配準策略速度較慢。雖然研究者已提出了SURF[14]、PCASIFT、CSIFT[15]、ASIFT[16]、BIRSK[17]和FREAK[18]等很多改進算法,但針對本文的應用背景,改進算法的實時性和穩定性不滿足要求。

為此,本節首先采用小波多分辨率分析和圖像分塊方法,使得算法可以根據行車環境的復雜性選擇合適的分辨率,以減少特征點數并保持點數穩定;然后采用相鄰幀特征點位置估計配準策略對算法進行改進,在保持算子對不同行車背景適應性的同時,提高算法的配準精度,使其滿足實時性要求。

1.1 特征點數均衡

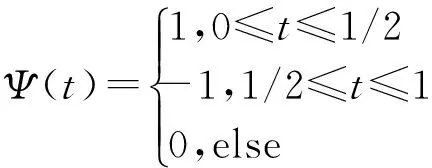

圖像中的高頻成分較多為噪聲和邊緣,利用小波變換多分辨率分析去除高頻成分后,可以減少邊緣點對計算SIFT算子的影響。Haar小波維度小、運算速度快且占用內存小,是典型的規范正交基。因此,本文使用Harr小波,如式(1)所示。

(1)

對圖像進行兩層小波分解,并對第2層分解圖像進行分塊,提取每個塊的SIFT特征點。如果一個塊中的特征維數達到預設閾值,則對當前塊不再提取特征點,但如果塊中特征點較少,則將第1層分解圖像也用于特征點提取和配準。此種處理方法的優勢在于:

1)當行車背景處于鬧市區等復雜背景時,兩層分解減少了每次參與匹配的像素點,而行車于高速路等簡單背景時,上層分解可保證足夠特征點,從而保持特征點數量的基本穩定。

2)利用圖像分塊進行特征點提取和配準,可避免特征點密集部分對全局背景補償影響偏大的問題。

3)可避免DoG算子的邊緣敏感性對匹配點的影響。

1.2 特征點描述符降維

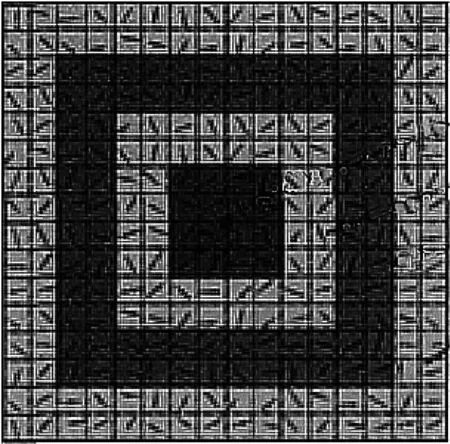

本文根據文獻[19]方法,采用如圖1所示的鄰域窗口來計算特征點描述符。以中央黑色點表示的特征點為中心,每兩個像素的寬度范圍為一層,建立4層鄰域,該鄰域范圍可以增強距離近的像素點對特征描述符的貢獻,一定程度上也避免了因分塊且對特征點數限制帶來的精度損失。

圖1 特征描述符計算鄰域

以45°為間隔均分空間,累加每層鄰域內8個方向范圍內的梯度值,則每個特征點描述向量為4×8=32維,并按區域位置對向量排序。在每個子區域內累加像素的梯度值并做歸一化處理,以減少光照的影響:

(2)

最終計算得到的32維描述符向量為:

Fn=(fn1,fn2,…,fn32)

(3)

其中,n為特征點數。Fn兼顧向量降維和反映鄰域像素的距離貢獻特性,因而對特征點的描述更準確。

1.3 快速特征點配準

由于在特征點配準時,SIFT算子采用所有特征點比較的策略,運算量較大。考慮到車載攝像機視頻圖像的相鄰幀間時間間隔較短,在幀率為25 frame/s時,兩幀間時間間隔為40 ms,在該時間段內,車輛的行進、顛簸、轉彎及外界環境的變化不會帶來相鄰幀間行車背景的大幅變化,即前一幀圖像實際上包含了當前幀大量特征點的位置信息。因此,可以利用前一幀的全局背景補償參數并通過前一幀圖像特征點位置信息對當前幀圖像中待配準特征點位置進行估計,并在估計位置的鄰域內搜索當前幀的待配準特征點,從而縮小當前幀特征點的搜索范圍,減少特征點配準時間。

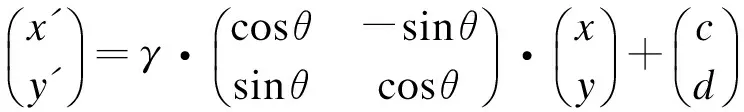

1.3.1 基于仿射變換的全局運動參數估計

攝像機隨車運動,相鄰幀間主要為圖像縮放,但考慮到行車顛簸和轉彎等過程影響,全局背景運動補償的參數估計需要針對攝像機平移、旋轉和縮放等進行。本文采用仿射參數模型計算補償參數,其計算相對簡單,對攝像機運動相對較小情況較適合。特征點(x′,y′)變換到下一幀特征點(x,y)的仿射變換關系如式(4)所示。

(4)

1.3.2 基于位置估計的特征點配準

車載攝像機視頻圖像的相鄰幀間時間間隔較短,其攝像機運動參數變化不大。因此,可以利用這一特點,將前一幀的運動參數作為當前幀與下一幀的運動參數對特征點進行位置估計,然后在估計位置的一定鄰域范圍內對特征點進行配準,從而實現特征點的快速配準。具體過程如下:

步驟1根據1.1節和1.2節方法計算相鄰兩幀圖像SIFT特征點及其描述符。由于行車環境復雜多變,因此相鄰兩幀圖像中某些區域特征豐富,使得SIFT特征點較密集而其他部分特征點較少。為減小特征點分布不均對全局參數估計的影響,將當前幀圖像分為矩形小塊,塊間不重疊,僅對每個塊內的一定數量特征點進行配準。

步驟2對當前幀中每個塊內的特征點(x′,y′),利用上一幀圖像的全局運動參數,并根據式(4)計算其在下一幀圖像中的對應像素位置(x″,y″),然后以(x″,y″)為中心,搜索半徑為R像素的圓形鄰域范圍內,滿足式(5)的特征點(x,y)為(x′,y′)配準點,同時對塊內特征點對數設定閾值,當點對數達到該閾值后,該塊內不再進行特征點配準。

(5)

其中:Emin為與(x′,y′)歐式距離最小的像素位置;Emax為與(x′,y′)歐式距離最大的像素位置。

步驟3當由于估計位置的鄰域交疊等原因,使得配準過程中出現多對一的情況時,首先判斷特征點與其鄰域特征點的位置關系是否與下一幀的對應配準點之間的位置關系一致,然后采用式(6)所示的互相關系數進行重新配準,取相關系數最大的特征點進行配準。

(6)

其中,x(n)、y(n)為待配準描述符。采用分塊和位置估計的配準過程,其優勢一方面是通過位置估計縮小了特征點配準的搜索范圍,提高了配準速度,另一方面是通過位置鄰域約束,避免了2個位置相差較大的特征點因特征描述符相似而誤配準,同時使得配準的特征點對在圖像中分布較均勻。實驗證明,當特征點在圖像中均勻分布時,利用全局參數的準確計算,可使運動補償效果最佳。

1.3.3 誤配準特征點對剔除

由于背景與前景目標同時運動,在剔除錯誤配準點后,還必須去除前景目標之間的配準點。首先在配準的N對點對中隨機選取5對,利用式(4)構建超定方程估計補償參數,然后將參數代入式(7)計算估計殘差。

(7)

迭代M次隨機選取,得到E=(E1,E2,…,EM),取E的前L項殘差對應的配準點對,用于最終補償參數的估計。M與無錯誤點對的可能性p之間滿足式(8)關系

p(ε,q,M)=1-(1-(1-ε)q)3)M

(8)

其中:ε(ε<0.5)表示誤配準的點對比例;q為隨機選取準確特征點的可能性。實驗結果證明,當ε=0.2,q=0.75時,M=25,即得到p=0.975。

最后采用Levenberg-Marquardt算法進一步優化估計全局運動參量,并采用雙線性插值方法計算補償幀。

2 目標檢測

本文利用三幀間差分法消除補償后的背景區域,然后采用改進的假設檢驗方法檢測目標。

2.1 三幀差分法

設ft-1,ft,ft+1為連續的3幀圖像,利用幀差分法計算差分圖像d1和d2后進行“與”運算,即:

d1=|ft(x,y)-ft-1(x,y)|

(9)

d2=|ft+1(x,y)-ft(x,y)|

(10)

d=d1?d2

(11)

三幀差分法能突出目標的位置和輪廓信息,但仍存在噪聲像素干擾。為此,本文對差分圖像進行自適應閾值分割和形態學處理,并采用改進的假設檢測方法對目標進行精確檢測。

2.2 基于改進假設檢驗方法的目標檢測

(12)

其中,n1和n2為樣本數。設定置信度為α,則若式(13)成立則拒絕假設H0,否則接受H0。

(13)

(14)

文獻[20]采用假設檢測方法取得了較好的目標檢測效果,但由于其針對監控圖像目標檢測,目標主要集中在圖像中間區域,因此通過取選定距上下邊界10像素寬的區域作為背景區域可以取得較好的檢測效果。但在行車視頻圖像中,動態目標可以出現在圖像中的任何區域,且目標在圖像邊界位置和在中心等其他位置出現的概率相同,采用邊界像素計算背景方差并不準確。為此,本文采用配準特征點對作為種子點計算背景方差,以提高準確率。具體步驟如下:

1)根據三幀差分法計算配準后的連續3幀圖像的幀差圖像,并取其絕對值。

3)以每個像素點為中心,計算判斷窗口內像素的方差σx,根據式(14)檢測目標像素點,并通過形態學運算和連通性檢測方法檢測最終的動態障礙物目標。

3 實驗與結果分析

為驗證本文算法的有效性,在Intel Core i5-6500M CPU,3.2 GHz,16 GB RAM環境下利用OPenCV 2.4庫和C++進行仿真實驗,應用于大量包含不同背景和多目標圖像數據,對比算法改進前后的效果。實驗分2個部分,一部分驗證算法目標檢測效果,另一部分檢測算法的效率。實驗中,特征點配準圖像分塊大小為45像素,假設檢驗方法取置信度為10-2,窗口寬度為5像素。實驗引用4種方法進行對比實驗:傳統SIFT方法+未改進假設檢驗方法,記為SIFT-HT;改進SIFT方法+未改進假設檢驗方法,記為ISIFT-HT;本文方法,記為ISIFT-IHT;基于質點過濾的SIFT算子目標檢測方法,記為PF-SIFT[21]。

3.1 檢測性能對比

圖2為采用SIFT-HT方法和本文方法對2種不同背景下目標檢測的結果,其中,圖2(a)為在原始圖像中2種方法對目標的檢測結果(實線框為本文算法檢測的目標區域,虛線框為SIFT-HT方法檢測的目標區域),圖2(b)和圖2(c)為幀間全局背景補償后的檢測結果。可以看出,本文方法在正確檢測動態目標的同時,盡可能地消除背景干擾的影響,這主要是因為其采用圖像分塊的方法,使得配準的特征點較均勻地分布在整幀圖像中,避免了特征點集中區域對參數結果造成一定的偏移。當背景中相似區域較多時,傳統SIFT算法容易在相似區域出現較多的誤配準特征點。從圖2(b)檢測結果可以看出,當圖像中目標分布在邊界部分時,傳統原始假設檢驗方法會出現漏檢,而本文方法通過改進背景方差計算方法,能較好地檢測出圖像中的動態目標。可以看出,在不同背景和不同目標分布情況下,本文方法都取得了較好的動態目標檢測結果。

圖2 不同背景和目標分布下的目標檢測結果對比

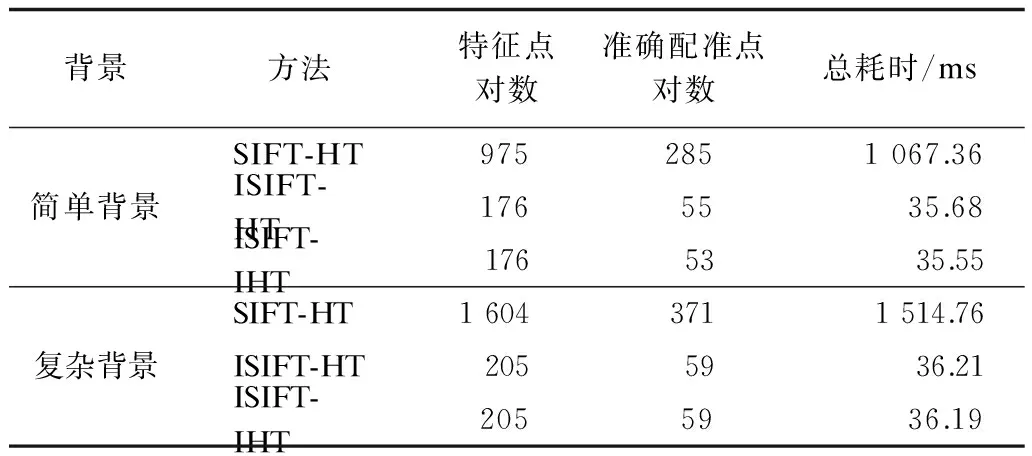

3.2 運行效率對比

為測試各方法的運行效率,取圖2所示的背景相對簡單(左圖)和復雜(右圖)的2組視頻圖像(1 024×776分辨率),實驗中每幀圖像進行50次運算并取平均值,計算每組實驗目標檢測的提取特征點對數、準確配準點對數、平均總耗時,表1為3種方法實驗結果對比。

表1 3種方法的目標檢測結果對比

從表1中提取的特征點對數可以看出,相比于傳統SIFT算法,本文方法通過小波多分辨率控制和圖像分塊配準特征點對數約束,在不同背景下取得了穩定的特征點對數,從而確保配準準確和穩定運行。從算法運行效率可以看出,本文方法通過特征點對數約束和相鄰幀特征點位置估計,大幅減少了運行時間,從實驗結果看,在汽車輔助駕駛系統圖像采集幀率為25 frame/s的情況下,本文方法滿足行車狀態時動態目標的實時檢測要求。

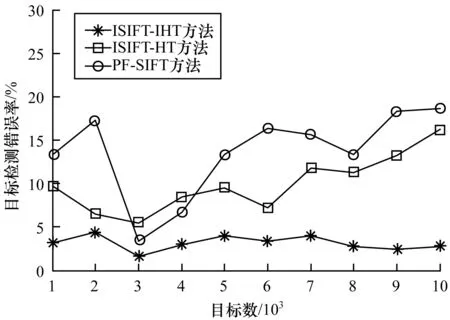

在實驗過程中,隨著視頻幀檢測數的增加,即運動目標總量的增加,累加每幀中漏檢和誤檢的目標數,并用檢測錯誤率表示。圖3所示為本文方法與PF-SIFT和ISIFT-HT方法的對比結果。

圖3 目標檢測錯誤率隨目標數的變化曲線

可以看出,環境的復雜變化以及視頻中目標數的增加對PF-SIFT方法的檢測結果影響較大。分析實驗結果發現,PF-SIFT方法在環境簡單且每幀目標數較少時錯誤檢測率較低,當環境復雜且目標較多時錯誤率較高。而本文檢測方法在背景復雜和背景簡單時都取得了較好的檢測結果,雖然當每幀圖像中目標較多時,對于較遠處的低分辨率目標會出現漏檢情況,而當背景復雜且車出現顛簸時,部分背景小目標會被錯誤檢測為動態目標,但從整體實驗結果看,本文方法錯誤率較小且比較穩定,其對行車環境具有較好的適應性。

4 結束語

針對汽車輔助駕駛系統動態目標檢測面臨的復雜背景和系統對檢測的實時性要求,本文提出一種基于改進SIFT算子和改進假設檢驗的動態目標檢測方法,在保持SIFT算子優點的同時,通過特征點對約束和相鄰幀位置估計加快全局背景補償參數的估計速度,并利用改進背景區域方差計算方法提高假設檢驗方法在行車環境下對背景方差的估計準確性。實驗結果表明,本文方法在保證與傳統方法相近性能的情況下,可實現快速解算,同時滿足系統對算法實時性的要求。

由于本文僅對車前動態目標進行檢測,因此下一步將針對短時靜態目標或者目標運動相對緩慢,以及在障礙物遮擋下目標短暫消失的情況進行研究,從而完善對車前目標的檢測,滿足汽車輔助駕駛系統更多的實際應用需求。

[1] 游安清,程義民.基于背景運動補償的紅外運動分析[J].強激光與粒子束,2003,15(5):431-434.

[2] 李 強,張 鈸.一種基于圖像灰度的快速匹配算法[J].軟件學報,2006,17(2):216-222.

[3] 施家棟,王建中.動態場景中運動目標檢測與跟蹤[J].北京理工大學學報,2009,29(10):858-891.

[4] RAATH G B,MAKUR A.Iterative Least Squares and Compression Based Estimations for a Four-parameter Linear Global Motion Model and Global Motion Com-pensation[J].IEEE Transactions on Circuits and Systems for Video Technology,2005,9(7):1075-1099.

[5] ALBU F,FLOREA C,ZAMFIR A,et al.Low Complexity Global Motion Estimation Techniques for Image Stabilization[C]//Proceedings of International Conference on Consumer Electronics.Washington D.C.,USA:IEEE Press,2008:1-2.

[6] 吳 強,侯樹艷,李旭雯.融合圖像灰度信息與邊緣特征的快速匹配算法[J].信號處理,2013,29(2):268-273.

[7] YE K,SUKTANKAR R.PCA-SIFT:A More Distinctive Representation for Local Image Descriptors[C]//Proceedings of Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2004:506-513.

[8] MIKOLAJCZYK K,SCHMID C.A Performance Evaluation of Local Descriptors[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2005,27(10):1615-1630.

[9] MORTENSEN E N,DENG H,SHAPIRO L.A SIFT Descriptor with Global Context[C]//Proceedings of CVPR’05.Washington D.C.,USA:IEEE Press,2005:184-190.

[10] MORENO P,BERNARDINO A,VICTOR S J.Improving the SIFT Descriptor with Smooth Derivative Filters[J].Pattern Recognition Letters,2009,30(1):18-26.

[11] LOWE D G.Object Recognition from Local Scale-invariant Features[C]//Proceedings of International Conference on Computer Vision.Washington D.C.,USA:IEEE Press,1999:1150-1157.

[12] LOWE D G.Distinctive Image Features from Scale-invariant Key Points[J].International Journal of Computer Vision,2004,60(2):91-110.

[13] 何孝瑩,岳建偉,張栩然.基于SIFT算法的無人機影像快速匹配[J].計算機工程,2011,37(7):216-218,230.

[14] BAY H,TUYTELAARS T,VAN G L.SURF:Speeded up Robust Features[C]//Proceedings of the 9th European Conference on Computer Vision.New York,USA:ACM Press,2006:404-417.

[15] ALAA E,FARAG A A.CSIFT:A SIFT Descriptor with Color Invariant Characteristics[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2006:1978-1983.

[16] MOREL J M,YU Guoshen.ASIFT:A New Framework for Full Affine Invariant Image Comparison[J].SIAM Journal on Imaging Sciences,2009,2(2):438-469.

[17] LEUTENEGGER S,CHLI M,SIEGWART R Y.BRISK:Binary Robust Invariant Scalable Key Points[C]//Proceedings of IEEE International Conference on Computer Vision.Washington D.C.,USA:IEEE Press,2011:2548-2555.

[18] ALAHI A,ORTIZ R.FREAK:Fast Retina Keypoint[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition.Washington D.C.,USA:IEEE Press,2012:510-517.

[19] 李 星,郭曉松,郭君斌.基于多特征融合的前向車輛檢測方法[J].計算機工程,2014,40(2):203-207.

[20] 賴作鎂,王敬儒,張啟衡.背景運動補償和假設檢驗的目標檢測算法[J].光學 精密工程,2007,15(1):112-116.

[21] 吳 駿,李文杰,耿 磊,等.基于單目視覺的前方車輛檢測與測距[J].計算機工程,2017,43(2):26-32.