基于中潛伏期聽覺誘發(fā)電位的聽覺注意特征提取與識(shí)別*

蔣本聰,王 力,鄒采榮,胡 曉*,汪家冬,梁瑞宇

(1.廣州大學(xué)機(jī)械與電氣工程學(xué)院,廣州 510006;2.東南大學(xué)信息科學(xué)與工程學(xué)院,南京 210096)

基于中潛伏期聽覺誘發(fā)電位的聽覺注意特征提取與識(shí)別*

蔣本聰1,王 力1,鄒采榮1,胡 曉1*,汪家冬1,梁瑞宇2

(1.廣州大學(xué)機(jī)械與電氣工程學(xué)院,廣州 510006;2.東南大學(xué)信息科學(xué)與工程學(xué)院,南京 210096)

針對(duì)目前研究聽覺注意的實(shí)驗(yàn)范式采用電極數(shù)量較多,且使用P3電位誘發(fā)時(shí)間比較長(zhǎng)等問(wèn)題,設(shè)計(jì)了一種基于聽覺誘發(fā)中潛伏期反應(yīng)(MLR)的實(shí)驗(yàn)范式。首先在注意與非注意兩種狀態(tài)下誘發(fā)出相應(yīng)的MLR,再分別計(jì)算MLR的能量、方差、面積、AR模型系數(shù)和波形峰值作為特征值。最后,通過(guò)模式識(shí)別算法進(jìn)行分類。實(shí)驗(yàn)結(jié)果表明:8位受試者以人工神經(jīng)網(wǎng)絡(luò)(ANN)為分類器的平均正確率可達(dá)到77.2%,本范式對(duì)于大部分受試者的效果較理想。

聽覺誘發(fā);聽覺注意;中潛伏期反應(yīng);AR模型系數(shù);模式識(shí)別;人工神經(jīng)網(wǎng)絡(luò)

視力障礙極大地影響了患者的日常生活,往往視力受限的患者,其聽覺系統(tǒng)是完好的。通過(guò)評(píng)估聽覺認(rèn)知能力可為臨床疾病診斷和認(rèn)知科學(xué)研究提供重要依據(jù),而這其中涉及到聽覺注意的相關(guān)內(nèi)容[1]。聽覺注意神經(jīng)信息處理機(jī)制在雞尾酒會(huì)效應(yīng)CPE(Cocktail Patty Effect)中可幫助人類處理外界環(huán)境中的聲音信息。人類能利用該信息處理機(jī)制從復(fù)雜多變的環(huán)境背景噪聲中快速和準(zhǔn)確地抓取感興趣或關(guān)鍵性的聲音內(nèi)容[2]。聽覺注意被認(rèn)為存在“自下而上”(bottom-up)和“自上而下”(top-down)這兩種機(jī)制[3-6]。

人在聽到聲音并做出相關(guān)反應(yīng)的過(guò)程中往往會(huì)將這兩種機(jī)制結(jié)合使用,因此為了能更清晰地辨別聽覺注意,本文采用了聽覺事件相關(guān)電位ERP(Event-Related Potentials)[7-8]。當(dāng)外界刺激為聲音時(shí),所誘發(fā)的電位稱為聽覺事件相關(guān)電位。聽覺事件相關(guān)電位可按延遲時(shí)間分類,其中,N0、P0、Na、Pa和Nb屬于中潛伏期反應(yīng)MLR(Middle Latency Response)[9-11]。

研究聽覺注意機(jī)制不僅能幫助人們了解耳蝸、腦干及其大腦等器官的工作原理,還可用于腦機(jī)接口等工程領(lǐng)域,Guo J等人通過(guò)設(shè)計(jì)一種新的聽覺腦機(jī)接口[12-13],以幫助視覺障礙患者選擇所需要的目標(biāo)。本文設(shè)計(jì)了基于MLR的聽覺注意實(shí)驗(yàn)范式,僅采用了一個(gè)電極數(shù)據(jù)的方法,并利用特征提取和分類算法對(duì)采集到的數(shù)據(jù)進(jìn)行處理,已經(jīng)獲得了滿意的實(shí)驗(yàn)結(jié)果。

1 方法

1.1 數(shù)據(jù)獲取

有8名(8耳,都是左耳)受試者進(jìn)行了MLR實(shí)驗(yàn),僅采用一個(gè)電極的數(shù)據(jù),其中男生5名,女生3名,平均年齡24歲,均為廣州大學(xué)在校研究生。受試者都為右利手,無(wú)聽覺系統(tǒng)、神經(jīng)系統(tǒng)疾病及精神障礙病史,而且都沒有參加過(guò)相關(guān)的實(shí)驗(yàn)。首先向受試者介紹實(shí)驗(yàn)?zāi)康暮拖嚓P(guān)注意事項(xiàng),然后他們簽署了《知情同意書》。整個(gè)實(shí)驗(yàn)在靜音的電磁屏蔽間內(nèi)進(jìn)行,且進(jìn)行實(shí)驗(yàn)時(shí)將屏蔽室的燈光關(guān)閉,受試者安靜地平躺于床上,頭部墊枕,受試者閉上雙眼,保持放松。

實(shí)驗(yàn)儀器為丹麥爾聽美公司的ICS Chartr EP200誘發(fā)電位儀。采集數(shù)據(jù)設(shè)置為刺激聲:短純音,密集型。聲音頻率1 kHz,聲音強(qiáng)度70 dBnHL,通道為同側(cè),由頭戴式Telephonics TDH-49P型耳機(jī)給聲,左耳給刺激聲。聲音的重復(fù)率為1.1次/s,帶通濾波為10 Hz~100 Hz,掃描時(shí)間為500 ms,疊加次數(shù)為80次。本設(shè)備用4個(gè)電極來(lái)獲取數(shù)據(jù),其中數(shù)據(jù)采集電極位于額頭頂部的發(fā)際中心位置,左右參考電極分別位于左右耳乳突,接地電極位于眉心,電極分布如圖1所示。所有電極的阻抗匹配低于5 kΩ。

圖1 電極分布圖

1.2 實(shí)驗(yàn)設(shè)計(jì)

本實(shí)驗(yàn)設(shè)計(jì)了兩種思維狀態(tài),一種空閑狀態(tài)(保持放松狀態(tài),不計(jì)數(shù)),另一種則是通過(guò)意念對(duì)刺激聲進(jìn)行計(jì)數(shù)的狀態(tài),其中受試者在計(jì)數(shù)時(shí)不能發(fā)出聲音、觸動(dòng)嘴唇或者伸縮舌頭。兩種狀態(tài)隨機(jī)出現(xiàn),并由實(shí)驗(yàn)操作者口頭告知受試者。實(shí)驗(yàn)設(shè)計(jì)方案如表1所示。一次實(shí)驗(yàn)共采集40組數(shù)據(jù),空閑狀態(tài)和計(jì)數(shù)狀態(tài)各采集20組。采集一組數(shù)據(jù)所需88 s,每組之間的間隔為5 s~10 s之間的一個(gè)隨機(jī)值。每采集完10組數(shù)據(jù)后,受試者休息5 min。8位受試者均參與了5次實(shí)驗(yàn)。

表1 實(shí)驗(yàn)設(shè)計(jì)方案

2 特征提取和分類

2.1 數(shù)據(jù)預(yù)處理

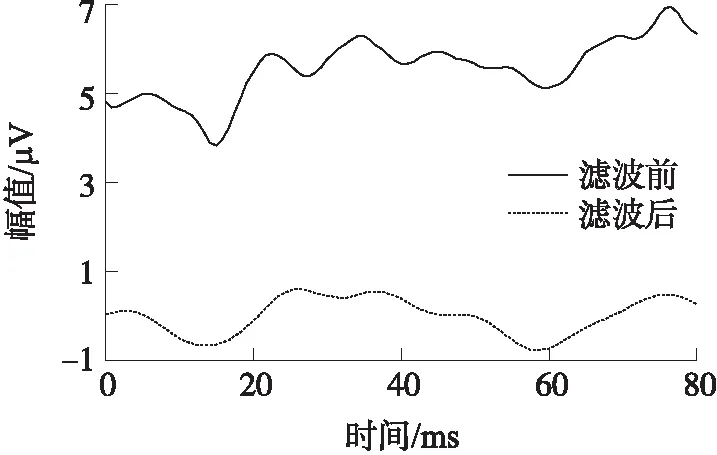

文獻(xiàn)[14]中,Suzuki等認(rèn)為中潛伏期反應(yīng)頻譜主要集中在30 Hz~50 Hz,Lane發(fā)現(xiàn)中潛伏期反應(yīng)的主要頻段是20 Hz~200 Hz。本實(shí)驗(yàn)結(jié)合實(shí)測(cè)數(shù)據(jù)各波潛伏期特點(diǎn),得出N0、P0、Na、Pa和Nb涵蓋在10 Hz~150 Hz頻帶內(nèi),由于數(shù)據(jù)的采樣率為1 200 Hz,對(duì)數(shù)據(jù)進(jìn)行6層小波分解[15-16],利用第3層到第6層細(xì)節(jié)分量系數(shù)重構(gòu)原始信號(hào),可實(shí)現(xiàn)9.375 Hz~150 Hz帶通濾波的效果,并能去除基線、自發(fā)腦電和高頻噪聲。隨機(jī)挑選兩次測(cè)試數(shù)據(jù)進(jìn)行小波濾波,效果如圖2所示。

圖2 濾波前后對(duì)比圖

圖2為受試者A非注意狀態(tài)濾波前后單試次波形對(duì)比,可以發(fā)現(xiàn)濾波后MLR基線偏移得到矯正,高頻噪聲得以去除,波形更加平滑。

濾波后的數(shù)據(jù)仍可能存在肌電和眼電干擾的跡象,因此本文采用閾值法,對(duì)波形走勢(shì)明顯異常,波峰和波谷總量小于3個(gè),幅值過(guò)高的波形予以自動(dòng)剔除(測(cè)試對(duì)象不同,此閾值也會(huì)隨之變化)。濾波和去偽跡后,分別對(duì)8位受試者的所有同狀態(tài)數(shù)據(jù)做平均,得到圖3所示波形。

圖3中子圖3(a)~圖3(h)分別為8位受試者注意和非注意狀態(tài)平均MLR波形,實(shí)線為非注意狀態(tài),虛線為注意狀態(tài)。可以發(fā)現(xiàn),注意和非注意狀態(tài)下,平均MLR波峰存在明顯差異,且各波潛伏期基本沒有改變。

圖3 8位受試者所有不同狀態(tài)平均波形對(duì)比

2.2 特征提取

本文針對(duì)MLR波形,采用能量、方差、面積、AR模型系數(shù)及波形峰值作為特征值,其中AR模型系數(shù)采用Burg算法計(jì)算得到,階數(shù)則由高階譜分析工具箱HOSA的定階函數(shù)ARORDER計(jì)算獲取。MLR峰值由下列公式獲取:

記Na,Nb相對(duì)于基線的峰值分別為PNa和PNb,則:

PNa=max{x(n)},n∈[n1,n2]

(1)

PNb=max{x(n)},n∈[n3,n4]

(2)

記Pa相對(duì)于基線的峰值為L(zhǎng)Pa,則:

LPa=min{x(n)}n∈[n5,n6]

(3)

記Nb-Pa的峰峰值為FNb-Pa,則:

FNb-Pa=PNb-LPa

(4)

式中:n1、n3和n5分別代表Na、Nb和Pa潛伏期區(qū)間起始點(diǎn),n2、n4和n6分別代表Na、Nb和Pa潛伏期區(qū)間結(jié)束點(diǎn)。參照文獻(xiàn)[17],Na、Pa和Nb的潛伏期分別為16 ms~30 ms,30 ms~45 ms和40 ms~60 ms。實(shí)驗(yàn)依照各受試者的波形對(duì)潛伏期區(qū)間范圍進(jìn)行微調(diào)。Na、Pa、Nb位置如圖4所示。

圖4 MLR峰值位置圖

由ARORDER函數(shù)計(jì)算得到的AR模型階數(shù)為7,組合能量、面積、方差和峰值特征,本文得到的特征共13維,記為

v1=[a1,a2,a3,a4,a5,a6,a7,e,s,σ,PNa,LPa,PNb]

(5)

式中:a1~a7為AR模型系數(shù),e為能量,s為面積,σ為方差,PNa、LPa和PNb分別為Na、Pa和Nb的峰值。此外本文還加入了Nb和Pa的峰峰值FNb-Pa,最終得到特征向量v2和v3:

v2=[a1,a2,a3,a4,a5,a6,a7,e,s,σ,PNa,LPa,FNb-Pa]

(6)

v3=[a1,a2,a3,a4,a5,a6,a7,e,s,σ,PNa,PNb,FNb-Pa]

(7)

2.3 分類算法

由于實(shí)驗(yàn)數(shù)據(jù)有限,為更好地呈現(xiàn)分類的有效性,本文采用了基于K交叉驗(yàn)證的支持向量機(jī)和神經(jīng)網(wǎng)絡(luò)[18]的分類算法,實(shí)驗(yàn)中K取3。

支持向量機(jī)選擇高斯核函數(shù),設(shè)定懲罰參數(shù)c和高斯核參數(shù)g的尋優(yōu)范圍為[2-10,210],以K交叉驗(yàn)證運(yùn)行100次中,使正確率達(dá)到最大值的c和g值為最終采用的值。

由于僅含一個(gè)隱層的神經(jīng)網(wǎng)絡(luò)就可以任意逼近一個(gè)非線性函數(shù),本實(shí)驗(yàn)采用2層神經(jīng)網(wǎng)絡(luò),第1層有10個(gè)神經(jīng)元,第2層有2個(gè)神經(jīng)元。第1層的傳遞函數(shù)是邏輯函數(shù)(Logic),輸出層的傳遞函數(shù)是線性函數(shù)(Linear),同樣以K交叉驗(yàn)證運(yùn)行100次中,使正確率達(dá)到最大值的網(wǎng)絡(luò)為最后采用的網(wǎng)絡(luò)。最后將基于K交叉驗(yàn)證的兩種分類器算法迭代100次的平均識(shí)別率作為最終分類正確率。

3 結(jié)果與分析

3.1 特征提取箱線結(jié)果

將8位受試者的Na峰值PNa,Pa峰值LPa,Nb峰值PNb和峰峰值FNb-Pa的提取結(jié)果繪制成箱線圖,結(jié)果如圖5所示。

圖5 8位受試者峰值特征提取結(jié)果箱線圖

圖5(a)~圖5(h)分別為8位受試者Na,Pa,Nb,Nb-Pa提取結(jié)果箱線圖,每個(gè)子圖從左到右依次為非注意狀態(tài)Na,注意狀態(tài)Na,非注意狀態(tài)Pa,注意狀態(tài)Pa,非注意狀態(tài)Nb,注意狀態(tài)Nb,非注意狀態(tài)Nb-Pa,注意狀態(tài)Nb-Pa的提取結(jié)果箱線圖。從圖5可以看出注意與非注意狀態(tài)下,各峰值的上下邊緣線、上下四分位數(shù)和中位數(shù)。雖然兩種狀態(tài)下的提取結(jié)果有重疊的區(qū)間,但其分散情況并不形同。

3.2 SVM和ANN分類結(jié)果比較和分析

每位受試者都進(jìn)行了5次實(shí)驗(yàn),有200次數(shù)據(jù),其中注意狀態(tài)100次,非注意狀態(tài)100次。去偽跡后剩余160條左右數(shù)據(jù),K交叉驗(yàn)證取K=3,因此訓(xùn)練數(shù)據(jù)106條左右,測(cè)試數(shù)據(jù)54條左右,SVM和ANN分類結(jié)果分別如表2和表3所示。

由表2可知,所有受試者的3類特征平均識(shí)別正確率相差不大,以v3為特征的識(shí)別率為66.1±6.1%,略高于以v2和v1為特征的識(shí)別率,由此可見SVM對(duì)3種特征并不敏感。各受試者之間的識(shí)別率相差較大,最高為74.7±4.9%,最小僅57.3±5.9%。

由表3可知,以v3為特征的平均識(shí)別率最高,可達(dá)77.2±2.8%,以v1和v2為特征的識(shí)別率也分別達(dá)到了75.5±2.7%和74.9±3.2%,由此可見所取特征有效且可分。對(duì)比表2和表3可以發(fā)現(xiàn)在本實(shí)驗(yàn)范式下,采用ANN分類器的識(shí)別率都高于SVM分類器的識(shí)別率。

表2 所有受試者SVM分類結(jié)果比較

注:1、3、6號(hào)為女性。

表3 所有受試者ANN分類結(jié)果比較

注:1、3、6號(hào)為女性。

3.3 ANN最優(yōu)的分類結(jié)果

由于不同受試者M(jìn)LR波形具有各自不同的特點(diǎn),本文對(duì)他們的最優(yōu)特征和分類器進(jìn)行了對(duì)比研究,詳情如表4所示。

表4 不同受試者在不同思維狀態(tài)下的分類結(jié)果

注:1、3、6號(hào)為女性。

由表4可知,半數(shù)的受試者以v3為分類特征識(shí)別率最高,3位受試者以v2為特征識(shí)別率最高,僅1位受試者選v2為分類特征時(shí)識(shí)別率最高,且男性和女性之間并未見明顯差異。若考慮特征的普適性,則選擇v3為分類特征,v3可用來(lái)區(qū)分受試者注意與非注意狀態(tài)。若針對(duì)某特定受試者,選取其最優(yōu)特征可使識(shí)別率更高。實(shí)驗(yàn)表明,用一個(gè)電極所采集的數(shù)據(jù),獲得了滿意的結(jié)果。

總之,本文設(shè)計(jì)的實(shí)驗(yàn)范式簡(jiǎn)潔,技術(shù)可行,有望為視覺有障礙的患者提高生活質(zhì)量,還可為健康人提供人機(jī)交互應(yīng)用體驗(yàn)。雖然實(shí)驗(yàn)對(duì)象有限,但可以有效推廣。

4 結(jié)語(yǔ)

本文在基于MLR的實(shí)驗(yàn)范式下,以MLR波形的能量、方差、面積、AR模型系數(shù)及波形峰值作為分類特征值,通過(guò)使用支持向量機(jī)(SVM)和人工神經(jīng)網(wǎng)絡(luò)(ANN)分類算法對(duì)提取的特征值進(jìn)行分類和對(duì)比。實(shí)驗(yàn)結(jié)果表明:8位受試者分類正確率較理想,說(shuō)明本范式對(duì)于大部分受試者可以達(dá)到較理想的效果。

[1] 顧吉有,呂勇. 選擇性注意和分配性注意對(duì)多感覺整合的不同影響[J]. 心理與行為研究,2016,14(2):202-206.

[2] 劉揚(yáng),張苗輝,鄭逢斌. 聽覺選擇性注意的認(rèn)知神經(jīng)機(jī)制與顯著性計(jì)算模型[J]. 計(jì)算機(jī)科學(xué),2013,40(6):283-287.

[3] Fritz J B,Elhilali M,David S V,et al. Auditory Attention-Focusing the Searchlight on Sound[J]. Current Opinion in Neurobiology,2007,17(4):437-455.

[4] Alain C,Arnott S R,Picton T W. Bottom-Up and Top-Down Influences on Auditory Scene Analysis:Evidence from Event-Related Brain Potentials[J]. Journal of Experimental Psychology Human Perception and Performance,2001,27(5):1072-1089.

[5] Alain C. Breakingthe Wave:Effects of Attention and Learning on Concurrent Sound Perception[J]. Hearing Research,2007,229(1-2):225-236.

[6] Roeber U,Berti S,Muller D,et al. Disentangling Effects of Auditory Distraction and of Stimulus-Response Sequence[J]. Psychophysio-logy,2009,46(2):425-438.

[7] Raggi A,Iannaccone S,Cappa S F. Event-Related Brain Potentials in Amyotrophiclateral Sclerosis:A Review of the International Literature[J]. Amyotrophic Lateral Sclerosis,2010,11(1-2):16-26.

[8] Hettich D T,Bolinger E,Matuz T,et al. EEG Responses to Auditory Stimuli for Automatic Affect Recognition[J]. Front Neurosis,2016,10(244):244.

[9] 彭賢,符秋養(yǎng),王濤. 聽覺誘發(fā)中潛伏期反應(yīng)研究進(jìn)展[J]. 聽力學(xué)及言語(yǔ)疾病雜志,2016,24(1):100-104.

[10] Kuhnle G E,Hornuss C,Lenk M,et al. Impact of Propofol on Mid-Latency Auditory-Evoked Potentials in Children[J]. British Journal of Anaesthesia,2013,110(6):1001-1009.

[11] Prakash H,Abraham A,Rajashekar B,et al. The Effect of Intensity on the Speech Evoked Auditory Late Latency Response in Normal Hearing Individuals[J]. International Advanced Otology,2016,12(1):67-71.

[12] Guo J,Gao S,Hong B. An Auditory Brain-Computer Interface Using Active Mental Response[J]. IEEE Transactions on Neural Systems and Rehabilitation Engineering,2010,18(3):230-235.

[13] 郭婧.基于聽覺注意的認(rèn)知腦-機(jī)接口研究[D]. 北京:清華大學(xué)醫(yī)學(xué)院,2010.

[14] Suzuki T,Hirabayashi M,Kobayashi K. Effects of Analog and Digital Filtering on Auditory Middle Latency Responses in Adults And Young Children[J]. Annalsof Otology Rhinology and Laryngology,1984,93(93):267-70.

[15] Zhang R,Mcallister G,Scotney B,et al. Combining Wavelet Analysis and Bayesian Networks for the Classification of Auditory Brainstem Response[J]. IEEE Transactions on Information Technology in Biomedicine,2006,10(3):458-467.

[16] 于亞萍,孫立寧,張峰峰. 基于小波變換的多特征融合sEMG模式識(shí)別[J]. 傳感技術(shù)學(xué)報(bào),2016,29(4):512-518.

[17] 李興啟,王秋菊. 聽覺誘發(fā)反應(yīng)及應(yīng)用[M]. 北京:人民軍醫(yī)出版社,2007:163-167.

[18] 朱大銘. 神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)學(xué)習(xí)算法及問(wèn)題求解研究[D]. 北京:中國(guó)科學(xué)院計(jì)算技術(shù)研究所,1999.

ExtractionandRecognitionofAuditoryAttentionbyEvokedPotentialsintheMiddleLatencyPeriod*

JIANGBencong1,WANGLi1,ZOUCairong1,HUXiao1*,WANGJiadong1,LIANGRuiyu2

(1.School of Mechanical and Electric Engineering,Guangzhou University,Guangzhou 510006,China;2.Schoolof Information Science and Engineering,Southeast University,Nanjing 210096,China)

In view of some problems that exist in the present research on auditory attention paradigm,for example,

using a large number of electrodes,longer time needs to evoke P3 potentials and so on. An experimental paradigm based on the middle latency response(MLR)is designed from auditory evoked. At first,the MLRs are respectively induced in two states of attention and non-attention;and then the energy,variance,area,AR model coefficient and waveform peak value of MLRs are respectively calculated. Finally,the features are classified by the pattern recognition algorithm. The experimental results show that the average accuracy of artificial neural network(ANN)is 77.2% from 8 subjects,which means that the paradigm can achieve satisfactory results.

auditory evoked;auditory attention;middle latency response;AR model coefficient;pattern recognition;artificial neural network

10.3969/j.issn.1005-9490.2017.06.040

項(xiàng)目來(lái)源:廣州市信息處理與傳輸重點(diǎn)實(shí)驗(yàn)室項(xiàng)目(201605030014);廣州市市屬高校科研項(xiàng)目(1201630210);廣州大學(xué)科技創(chuàng)新培育基金項(xiàng)目

2016-10-21修改日期2016-12-13

R339.16

A

1005-9490(2017)06-1539-06

蔣本聰(1992-),男,漢族,湖南郴州人,廣州大學(xué)機(jī)械與電氣工程學(xué)院碩士研究生,主要研究方向?yàn)槟X電信號(hào)處理,695397975@qq.com;

王力(1986-),男,漢族,湖南耒陽(yáng)人,廣州大學(xué)機(jī)械與電氣工程學(xué)院講師,主要研究方向?yàn)槟X電信號(hào)處理,wangli@gzhu.edu.cn;

鄒采榮(1963-),男,漢族,江蘇昆山人,廣州大學(xué)機(jī)械與電氣工程學(xué)院教授,博士生導(dǎo)師,主要研究方向?yàn)槁曅盘?hào)與語(yǔ)音信號(hào)處理,cr_zou@gzhu.edu.cn;

胡曉(1969-),男,漢族,湖南郴州人,廣州大學(xué)機(jī)械與電氣工程學(xué)院教授,碩士研究生導(dǎo)師,主要研究方向?yàn)橹悄苄盘?hào)處理,人臉檢測(cè)和識(shí)別,醫(yī)學(xué)信號(hào)處理,huxiao@gzhu.edu.cn;

汪家冬(1990-),男,漢族,安徽淮南人,廣州大學(xué)機(jī)械與電氣工程學(xué)院碩士研究生,主要研究方向?yàn)閿?shù)字語(yǔ)音信號(hào)處理,1304943689@qq.com;

梁瑞宇(1978-),男,漢族,江蘇徐州人,東南大學(xué)信息科學(xué)與工程學(xué)院博士,碩士研究生導(dǎo)師,主要研究方向?yàn)檎Z(yǔ)音信號(hào)處理,lly1711@163.com。