一種基于CMT框架的目標跟蹤算法研究?

袁 峻 徐峰磊 任明武

(南京理工大學計算機科學與工程學院 南京 210094)

一種基于CMT框架的目標跟蹤算法研究?

袁 峻 徐峰磊 任明武

(南京理工大學計算機科學與工程學院 南京 210094)

論文提出了一種基于CMT(Consensus-based Tracking and Matching of Keypoints for Object Tracking)框架的目標跟蹤算法。針對傳統的CMT算法采用固定模型的缺點,該文引入時空上下文(Spatio-Temporal Context)跟蹤算法,提出一種由跟蹤器,檢測器與融合器組成的目標跟蹤算法。該算法將時空上下文跟蹤算法作為跟蹤器,使用Kalman濾波預測目標所在位置,減小在圖像中特征點檢測范圍,將CMT中的特征點匹配算法作為檢測器,使用融合器分析和評估跟蹤器與檢測器結果,決策出最終的結果,并執行有效的模型更新策略。

目標跟蹤;CMT跟蹤算法;STC跟蹤算法;級聯檢測器;模型更新

1 引言

目標跟蹤是近些年來計算機視覺研究的關鍵問題之一,國內外學者一直致力于跟蹤算法的研究,也不斷的取得了很多研究成果。但是由于目標跟蹤的過程中存在諸多復雜問題,如:目標形變,目標遮擋,目標尺度的變化,以及環境的復雜多變,目標跟蹤仍然是計算機視覺領域中面臨的一大難題。

目標跟蹤的基本思路是不斷檢測到目標的特征,從而不斷更新目標的位置。常見的跟蹤算法分為以下三類[1]:基于整體模型的目標跟蹤算法;基于特征的跟蹤算法;基于判別模型的跟蹤算法。

STC[2]跟蹤算法就是基于整體模型的跟蹤算法,他對目標與附近區域進行統計關系建模,通過在置信圖中不斷尋找似然概率最大的位置進行目標跟蹤,該算法跟蹤效果好,算法效率高,但是在模型更新策略上具有一個不可忽視的缺陷,即當目標發生遮擋時,算法會錯誤的更新模型,導致之后的跟蹤產生漂移甚至跟丟。

CMT[3]算法是核心是基于特征點匹配的算法,首先計算特征點,與初始的特征點之間進行模版匹配,這樣的設計可以大大提高在圖像中搜索目標的效率,具有很好實時性并且跟蹤效果令人滿意,只是在該算法中,特征點模型固定不變,這給跟蹤可形變目標帶來了極大的困難。

綜合以上對STC算法和CMT算法的分析,本文提出一種基于CMT框架的目標跟蹤算法。

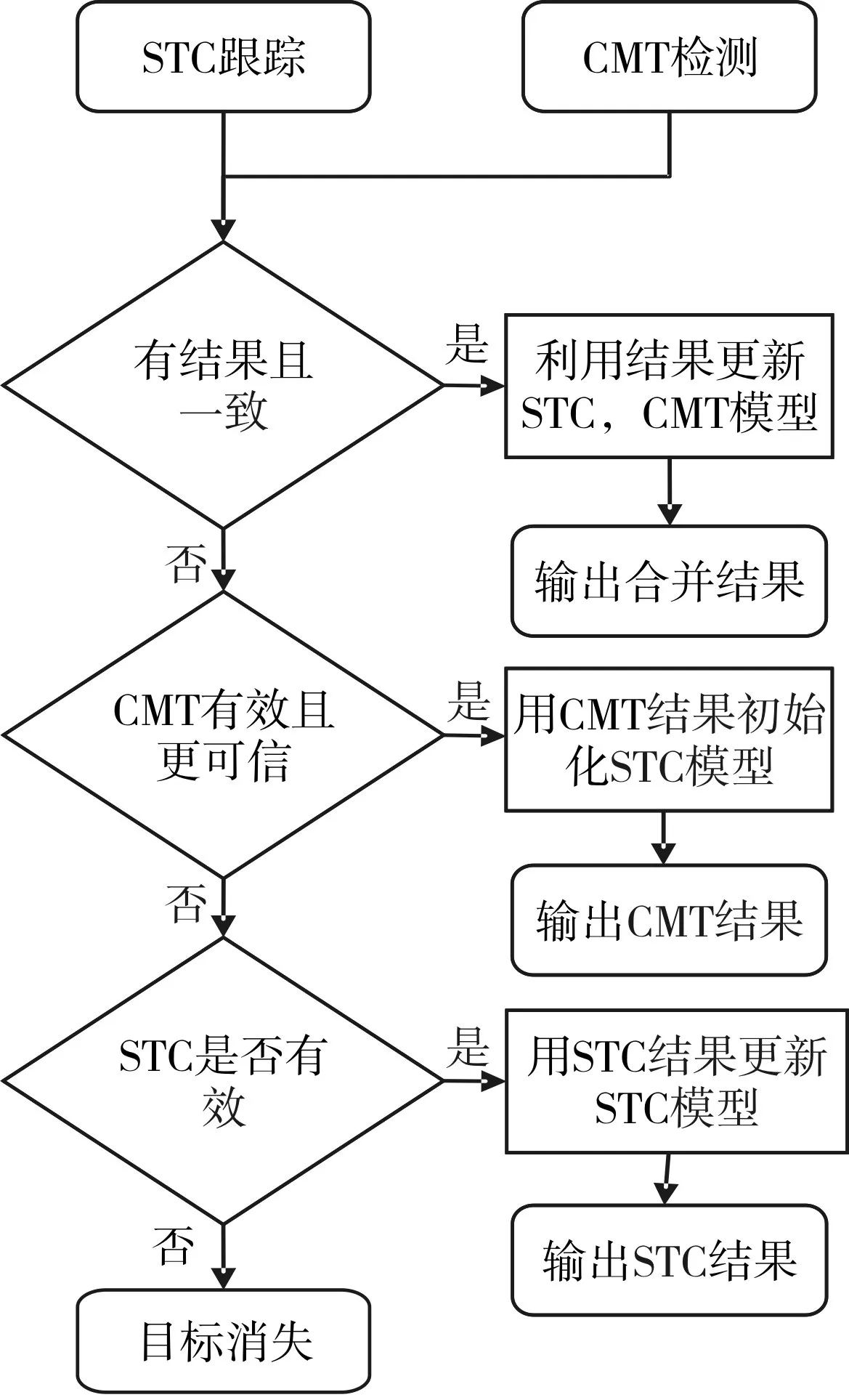

2 本文算法

本文基于CMT算法的框架,加入時空上下文算法,并對原算法的匹配檢測模塊進行改進。在CMT算法中,作者用LK金字塔光流法[4],對特征點進行跟蹤。本文采用時空上下文算法給予替換,增強了跟蹤模塊的跟蹤性能,也解決了光流法的計算耗時的缺點。在檢測模塊上,采用Kalman濾波[5]與特征點匹配級聯的檢測算法,Kalman濾波對當前目標位置進行預測,縮小特征點檢測范圍,提升算法運行速度。采用更新模版機制,增強檢測的魯棒性。新增算法融合模塊,根據跟蹤和檢測的模塊的預測結果給出最終的結果,同時融合模塊還對跟蹤模塊和檢測模塊進行模型更新,以實現長時間有效跟蹤。本文算法框架如圖1所示。

2.1 STC跟蹤器

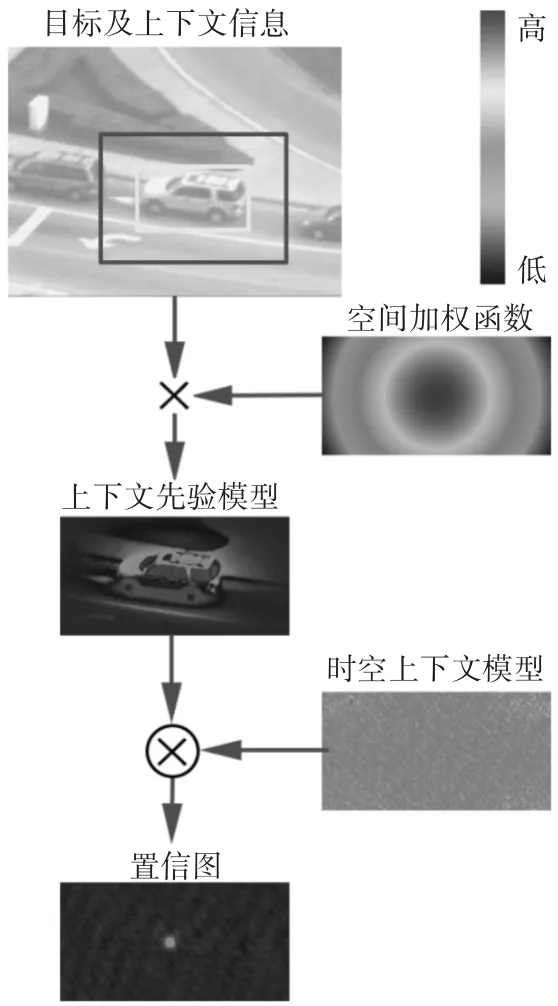

STC跟蹤算法根據跟蹤目標與周圍區域形成的的時空關系進行統計關系建模。通過計算置信圖,找到似然概率最大的位置,即為跟蹤結果。

圖1 本文算法流程圖

圖2 STC跟蹤器流程

圖2 的流程中,時間上下文信息可以幫助算法鎖定目標位置,而空間上下文信息則能提供更精確的信息幫助算法區分目標和背景。

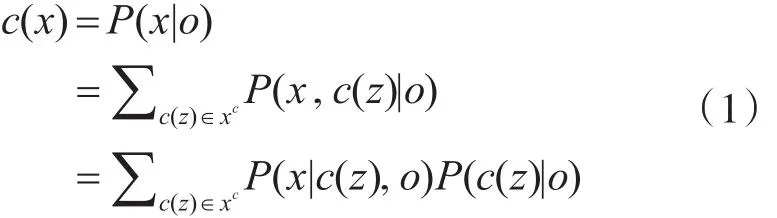

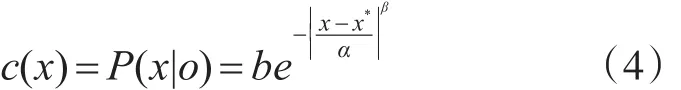

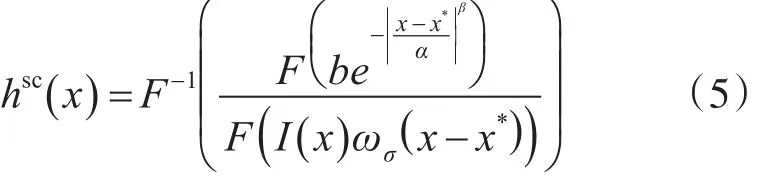

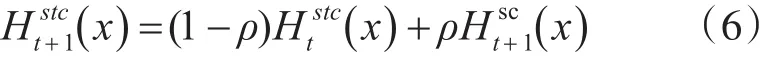

置信圖可表示成為

式(1)中,x表示目標位置,o表示目標出現。置信圖似然函數分解為兩個部分,即空間上下文模型P(x,c(z)|o),上下文先驗模型P(c(z)|o)。

空間上下文模型可表示為

該模型表示目標位置x與局部區域內點z之間的相對距離以及方向關系。

上下文先驗概率模型可表示為

式(3)中 I(z)表示 z處的灰度值,ωσ(z)表示權重函數。該權重函數是由生物視覺系統的focus of attention[6]啟發得到。距離目標x*越近的點對于跟蹤目標越重要,因此賦予它更大的權重。

置信圖定義為

式(4)中b為歸一化常量,α為尺度參數,β為形狀參數。

由此,通過置信圖和上下文先驗概率模型可以學習出空間上下文模型,具體公式為

式(5)中F表示快速傅立葉變換,F-1表示快速傅立葉逆變換[7]。將時域中的卷積運算變換成頻域中的乘積運算大大降低了計算量。

式(6)中ρ為模型學習速率。算法通過不斷學習到的空間上下文模型結合前一幀的時空上下文模型,就得到了當前幀的時空上下文模型。

STC算法跟蹤魯棒,但當目標被遮擋后,遮擋物的信息被錯誤的更新進模型中,導致會產生跟蹤漂移,甚至跟蹤失敗的結果[8]。

2.2 基于Kalman濾波與特征點匹配的檢測器

2.2.1 Kalman濾波器設計

Kalman濾波算法依據系統運動方程對跟蹤目標位置進行預測,再預測出可能的目標位置上,給出一個目標可能出現的矩形區域,此區域的寬和高分別取上一幀目標矩形框的3倍。在此區域進行特征點檢測,這樣避免了算法全圖檢測特征點,大大減輕了算法的計算量。圖3展示了本文使用Kalman濾波器的效果。

圖3 Kalman濾波運動估計

Kalman濾波系統可以用一個線性隨機微分方程來描述:

式(7)中A為狀態轉移矩陣,X(t)為系統在t時刻的狀態,W(t)為系統過程噪聲,這里假設為高斯白噪聲。

跟蹤目標點的狀態包含在t時刻點的位置和速度,因此系統狀態定義為

式(8)中,Px(t)和Py(t)分別是目標中心點在t時刻的x,y坐標位置,Vx(t)和Vy(t)分別是目標中心點t時刻在x,y方向上的速度。

利用Kalman濾波系統對下一幀目標狀態進行有效的預測,為下一步的特征點檢測縮小了執行范圍。

2.2.2 基于特征點匹配的檢測模塊

在CMT算法中,作者把圖像檢測問題,看成特征點匹配問題。在第一幀給定的目標圖像中,初始化出一個特征點集合P={,…,},將 P與第 t00幀中特征點集合Pt做匹配。

當完成特征點匹配后,需要根據匹配點與初始化特征點之間的信息,對目標的尺度和旋轉角度進行評估,尺度s評估定義為

式(9)中,med指中值,即取當前幀兩兩特征點之間的距離與對應初始幀中兩兩特征點之間距離的商的中值作為目標尺度的變化。

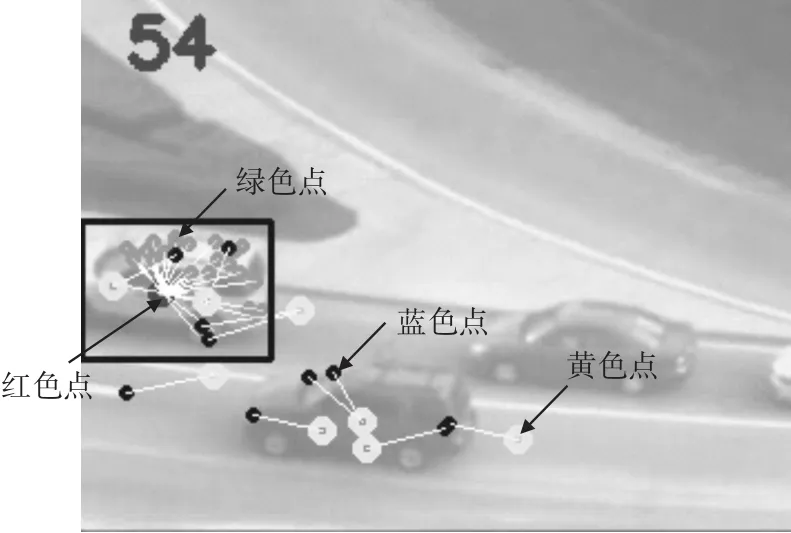

圖4中藍色點和綠色點表示匹配的特征點。紅色點和黃色點是通過聚類后各類投票的中心點。綠色點表示聚類得到的最大類別所包含的特征點。紅色點表示綠色點投票選出的聚類中心點。

圖4 特征點聚類

定義第t幀中特征點計算出中心位置兩兩之間相隔距離為

根據式(10)中計算出的每個特征點對應的中心坐標相隔的距離,對中心點坐標做聚類,當兩個類之間的距離小于閾值,合并這兩個類,以此得到結果中最大的類。被聚類到一起的特征點稱為聚類特征點。再利用聚類特征點投票的中心坐標值,求均值得到第t幀最終的目標中心位置。

2.3 基于置信度評判的融合器

2.3.1 置信度評判器設計

本文采用最近鄰分思想[9]作為對檢測和跟蹤結果的置信度評判器。

首先定義兩張圖像 pi,pj的相似度為

式(11)中NCC表示歸一化相關函數。

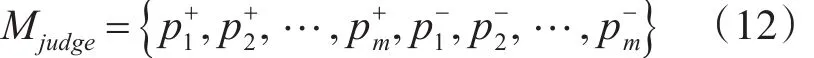

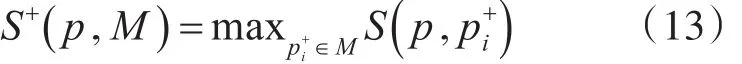

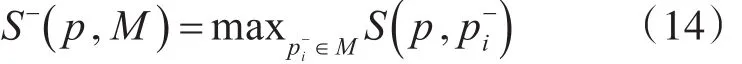

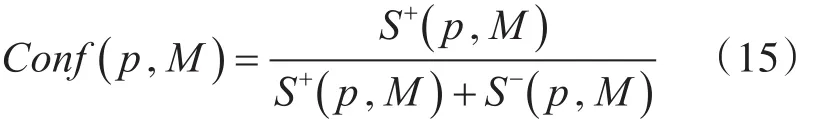

置信度評判器模型是一個包含目標圖像以及周圍背景圖像的數據結構。可表示為

當給定一張圖像 p以及評判模型M時,本文定義以下相似度指標:

正樣本最近鄰相似度為

負樣本最近鄰相似度為

根據式(13~14),定義圖像置信度定義為

置信度評判器的更新是一個在線訓練的過程[10],當跟蹤器和檢測器給出了一致的結果,而置信度評判器得出的置信度小于閾值時,則將該結果圖像加入評判器模型的正樣本數據集中。當檢測器和跟蹤器給出不一樣的結果,且兩結果置信度均大于閾值時,則將置信度較小的圖像加入評判器模型的負樣本數據集中。

2.3.2 結果融合與模型更新

基于以上的分析,改進算法結果輸出及模型更新流程如下:

圖5 結果融合與模型更新流程圖

跟蹤器和檢測器是獨立運行的,當融合器收到跟蹤器和檢測器給出的結果,需要判斷兩者是否都有結果且結果是否一致。結果是否一致,用兩者給出結果的重疊度作為衡量。

融合器最終輸出可以分為以下幾種情況討論:

1)跟蹤器和檢測器都有結果,且結果一致時:

CMT檢測更新策略:如果當前目標樣本與CMT檢測模板樣本相似度低于閾值時,則重新初始化CMT模型否則不更新。

STC跟蹤更新策略:利用跟蹤結果通過公式更新空間上下文模型hsc()x,再利用公式更新時空上下文模型hstc()x。2)檢測器結果置信度有效且高于跟蹤器結果:

這種情況通常是跟蹤器模型被錯誤更新,導致發生跟蹤漂移甚至是失敗的情況。

CMT檢測更新策略:如果當前目標樣本與CMT檢測模板樣本相似度低于閾值時,則重新初始化CMT模型。否則不更新。

STC跟蹤更新策略:這時需要用檢測器給出的結果重新初始化跟蹤器,以此修正跟蹤器錯誤的更新。

3)跟蹤器結果有效且高于檢測器結果置信度時:

這種情況通常是目標發生了較大面積的遮擋,檢測器特征點匹配過少導致檢測失敗,跟蹤器由于考慮了目標周圍區域的信息,因此在這種情況下仍能很好跟蹤。

CMT檢測更新策略:這種情況下,由于目標發生了遮擋,特征點信息不全面,因此檢測器不更新模型。

STC跟蹤更新策略:利用跟蹤結果通過公式更新空間上下文模型hsc()x,再利用公式更新時空上下文模型hstc()x。

4)跟蹤器,檢測器都無效時:

輸出目標消失,沒有當前目標信息不進行跟蹤器檢測器模型更新。

3 算法實驗

實驗所用電腦為Intel Core i7 2640m@2.8GHz與8G內存,操作系統為Windows8.1,軟件為Visual Studio 2013。

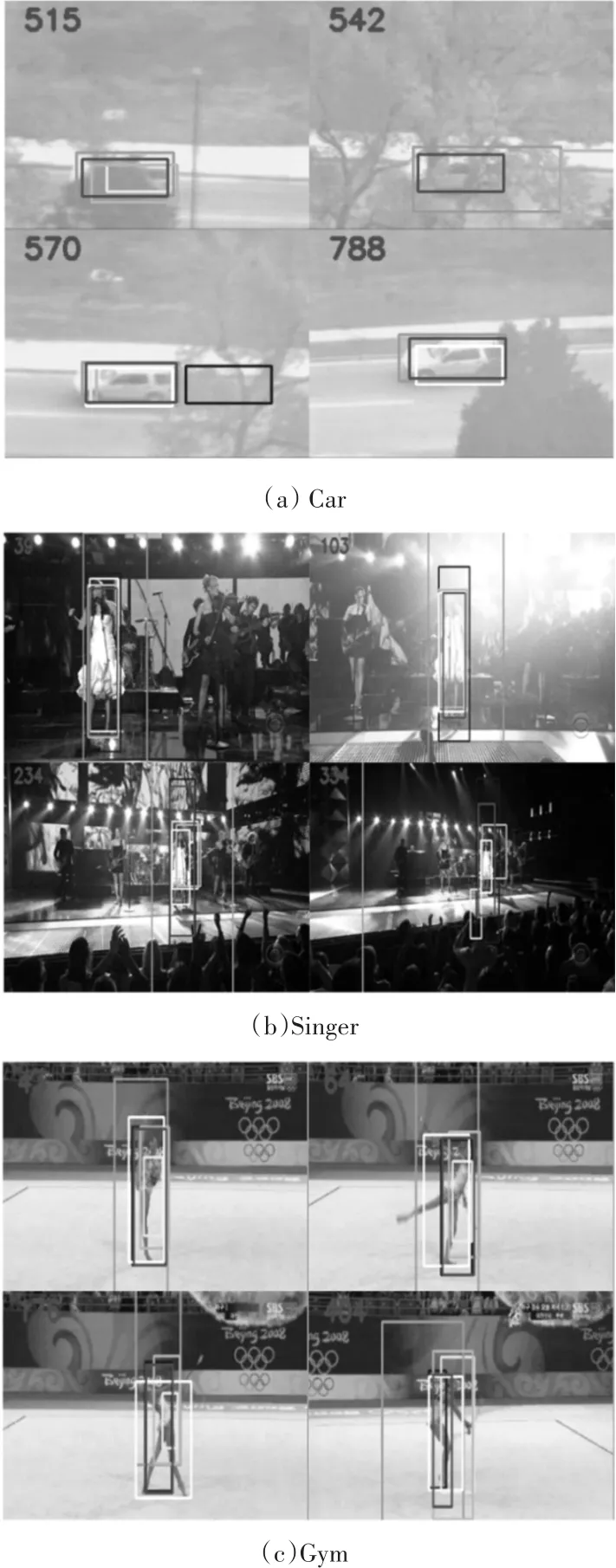

為驗證本文提出算法的性能,本文選取car、singer、gym三段視頻分別測試算法的遮擋時,變尺度時以及目標形變時跟蹤性能,對比算法有STC,CMT,TLD[11]。

本次實驗選用跟蹤成功率和中心定位偏差這兩個常用的指標作為性能指標。當算法結果與真實值的重疊度大于0.5時,認為是跟蹤成功的。中心定位偏差是指算法結果與真實值的中心距離。

圖6展示的是實驗中各算法的跟蹤效果,其中本文算法為紅色框,STC算法為藍色框,CMT為綠色框,TLD為黃色框,真實結果是白色框。

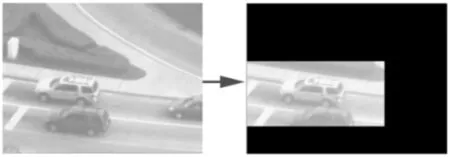

視頻片段(a)Car是一段分辨率為320*240的視頻,視頻中的跟蹤目標為白色小汽車。在汽車行駛中經歷了三次遮擋。在目標被遮擋時,只有STC與本文算法穩定跟蹤,TLD跟蹤丟失,CMT跟蹤錯誤。在離開遮擋區域后,STC算法發生跟蹤漂移,TLD與CMT算法從新定位跟蹤。本文算法則始終保持高精度跟蹤。

視頻片段(b)Singer是一段分辨率為624*352的視頻,視頻中的跟蹤目標是一位女歌手。本段視頻主要考驗的是跟蹤算法對跟蹤目標尺度的測量,以及在強光暗光交替變換時的跟蹤魯棒性。通過跟蹤結果可發現,本文算法除了寬高比不太滿意以外,對目標的中心定位一直很準,STC算法對目標中心定位也很穩定,但是對目標尺寸的估計比本文算法差。CMT算法對跟蹤目標發生形變時的魯棒性差。

視頻片段(c)Gym是一段分辨率為426*234的視頻,視頻中跟蹤目標是一位跳舞的舞者。視頻中她花樣繁多的舞姿,多變的體形給跟蹤算法制造了極大的難度,本段視頻中本文算法和STC算法都體現了極高的跟蹤性能,而CMT算法由于很難將舞者當前幀中出現的特征點與初始幀中出現的特征點配對,導致跟蹤效果很差。TLD算法在整段視頻中也很難穩定跟蹤目標。

圖6 各算法跟蹤效果

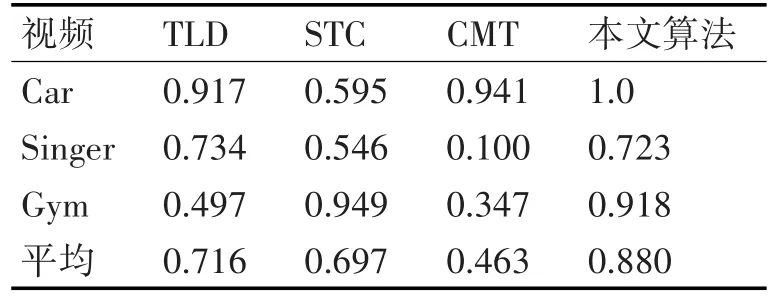

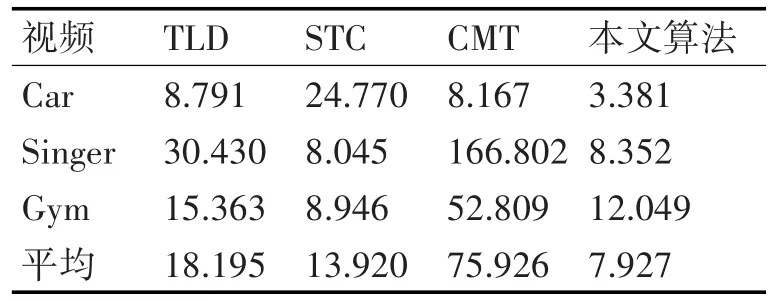

表1展示了各算法的跟蹤成功率,本文提出的基于CMT算法的改進算法不但在成功率上比與原算法高出了近一倍,與相比的TLD算法和STC算法跟蹤成功率也高出了不少。表2展示的是各算法在測試片段中的中心誤差指標。這反應了跟蹤算法的跟蹤精度,無疑本文提出的改進跟蹤算法的跟蹤精度是最好的。

表1 各算法跟蹤成功率

表2 各算法中心偏差(像素)

在運行速度上,TLD算法是7.691幀/秒,STC算法是32.476幀/秒,CMT算法是8.120幀/秒,而本文的改進算法是10.377幀/秒,比改進的CMT算法快了27.8%的速度,比TLD算法快了34.9%的速度,雖然本文算法比STC算法在速度上有所降低,但是在算法跟蹤精度和準確度上有了較大提升,尤其是在跟蹤目標消失或持續遮擋后再出現的場景下具有更為突出的表現。在目標發生較大形變以及背景復雜的場景下,本文提出的改進算法依然具有卓越的跟蹤魯棒性。

4 結語

本文針對CMT算法在長時間目標跟蹤的情況下,模型不更新導致跟蹤效果不穩定的問題,提出了一種基于CMT算法的改進算法。該算法將原算法的光流跟蹤模塊替換成時空上下文跟蹤模塊,使跟蹤結果更加魯棒;引入了Kalman濾波算法,預測目標運動狀態,給出目標出現的候選區域,避免了無效區域特征點的檢測和匹配;同時增加結果融合器評判跟蹤器和檢測器的結果置信度,給出最好的融合結果和模型更新方案。在多組實驗上表明本文改進算法相比于原算法在跟蹤性能和運行速度上都具有較大提升。

[1]凌超,吳薇.視頻圖像中運動目標跟蹤算法研究綜述[J].科技資訊,2012(16):7-7.

LING Chao,WU Wei.A Survey of Moving Target Tracking Algorithms in Video Images[J].Science&Technology Information,2012(16):7-7.

[2]Zhang K,Zhang L,Yang M H,et al.Fast tracking via spatio-temporal context learning[J].arXiv preprint arXiv:1311.1939,2013.

[3]Nebehay G,Pflugfelder R.Clustering of static-adaptive correspondences for deformable object tracking[C]//Computer Vision and Pattern Recognition.2015:2784-2791.

[4]Kalal Z,Mikolajczyk K,Matas J.Forward-Backward Error:Automatic Detection of Tracking Failures[J].2010:2756-2759.

[5]Provost M J,Nevell D A.Data processing system using a Kalman Filter:U.S.Patent 5,105,372[P].1992-4-14.

[6]Wolf L,Bileschi S.A Critical View of Context[J].International Journal of Computer Vision,2006,69(2):251-261.

[7]Duhamel P,Vetterli M.Fast fourier transforms:A tutorial review and a state of the art[J].Modern Radar,1990,19(4):259-299.

[8]張中偉.基于時空上下文和核相關濾波器的密集采樣目標跟蹤方法研究[D].西北農林科技大學,2015.ZHANG Zhongwei.Research on dense sampling target tracking method based on spatio-temporal context and kernel correlation filter[D].Northwest A&F University,2015.

[9]林曉帆,丁曉青.最近鄰分類器置信度估計的理論分析[J].科學通報,1998(3):322-325.LIN Xiaofan,DING Xiaoqing.Theoretical Analysis of Confidence Estimation of Nearest Neighbor Classifier[J].Chinese Science Bulletin,1998(3):322-325.

[10]陳東成,朱明,高文,等.在線加權多示例學習實時目標跟蹤[J].光學精密工程,2014,22(6):1661-1667.CHEN Dongcheng,ZHU Ming,GAO Wen,et al.Weight weighted multiple example learning real-time target tracking[J].Optics and Precision Engineering,2014,22(6):1661-1667.

[11]Kalal Z,Mikolajczyk K,Matas J.Tracking-Learning-Detection[J].IEEE Transactions on Pattern Analysis&Machine Intelligence,2012,34(7):1409-1422.

Object Tracking Algorithm Based on CMT Framework

YUAN Jun XU FengleiREN Mingwu

(School of computer science and Engineering,Nanjing University of Science and Technology,Nanjing 210094)

In this paper,an algorithm of object tracking based on CMT(Consensus-based Tracking and Matching of Keypoints for Object Tracking)is proposed.The original CMT algorithm only has a fixed object model.To solve this problem,an improved CMT algorithm which consist of tracker,detector and fusion is proposed.And spatio-temporal context(STC)tracking algorithm is introduced as a tracker.Kalman filtering predicts object position for reducing the range of detection of feature points.The feature points matching algorithm of CMT is used as detector.Fusion analyses and evaluates the results of tracker and detector,and gives the final result.At the same time,fusion runs an effective strategy of model update.

object tracking,CMT tracking algorithm,STC tracking algorithm,cascade detector,model update

TP391.41

10.3969/j.issn.1672-9722.2017.11.013

Class Number TP391.41

2017年5月8日,

2017年6月27日

袁峻,男,碩士研究生,研究方向:圖像處理、模式識別。徐峰磊,男,博士研究生,研究方向:圖像處理、模式識別。任明武,男,教授,博導,研究方向:無人駕駛車輛、圖像分析與處理。