一種改進的基于碼本和高斯混合模型的視頻背景分離*

詹 敏,鄒小波

(華僑大學 工學院, 福建 泉州 362021)

一種改進的基于碼本和高斯混合模型的視頻背景分離*

詹 敏,鄒小波

(華僑大學 工學院, 福建 泉州 362021)

文章提出一種基于改進的碼本(CB)和高斯混合模型(GMM)的視頻背景分離方法。該方法是以自適應的高斯混合模型背景為基礎,為每個顏色像素構建混合高斯背景模型,可以對視頻幀中每個像素的高斯分布數進行動態控制,并且通過CB(Codebook)算法得到每個像素的時間序列模型,從而對高斯分布的各參數進行學習。實驗結果表明,該方法在背景分離的精確度和處理時間上都表現出優異的性能,此外還具有良好的適用性,對復雜場景的變化,可以有效快速地分離視頻的前景和背景。

碼本;高斯混合模型;背景分離;視頻幀;高斯分布

0 引言

“背景”在不同的應用場合下是一個很難定義的問題。例如,若正在觀測一個大型商場,那么或許來來往往的人流應該被認為是背景。通常情況下,背景被認為是在任何所感興趣的時期內,場景中保持靜止或周期運動的目標。 到目前為止,通過基于像素不斷調整的方式來訓練和更新背景顏色信息的背景建模技術是背景分離的關鍵所在。雖然視頻背景分離已經取得了長足的進步,但是其在實時監控環境中的應用,大多數傳統的方法還存在許多問題,所以其仍然是一個具有挑戰性的任務。

目前最流行的估計背景顏色的統計方法是基于參數的高斯混合模型和基于非參數的核密度估計(KDE)[1]。這種基于概率估計的方法最強大的地方在于它能夠有效地模擬出搖曳的樹和飄揚的旗幟這類移動的背景信息。一般來說,通過期望最大化(EM)[2]算法或k-均值聚類算法來計算GMM參數。然而,這些方法并不適合實時監視應用,其中EM算法的時間復雜度較高,而k-均值聚類算法存在聚類初始值的設定問題。KDE算法也不能解決在背景分離過程中所產生的高耗能問題。

為了解決這些問題,本文提出使用碼本(CB)這種更加實用的背景建模方法。對比這些概率統計的方法,CB方案能夠確保更有效的操作,因為它只專注于訓練能夠觀察到的像素值范圍,而不是構成概率密度函數(PDF)結構的框架。此外,它們需要為模型初始化的用戶提供的參數的數目較少。然而,CB方法也會導致這樣的問題,它們往往容易對動態背景的檢測產生誤判,只考慮到觀測區域的數據。

本文提出了一種新的背景分離法,該方法利用CB和GMM模型結合的技術。其基本思想是由CB采集背景顏色,統計每個像素進而估計基于GMM分布的參數。計算高效的CB方法能夠實時構建和維護背景聚類模型,并采用GMM分布從CB集群計算其參數檢測前景區域。

1 背景建模

1.1基本思想

基于碼本的高斯混合模型是利用Codebook算法[3]得到每個像素的時間序列模型,首先它基于一個基本的先驗分布:像素構建過程在時間序列上滿足或者近似滿足高斯分布。因此可以建立一個自適應的高斯分布來描述像素構建過程,對于偏離高斯分布均值較遠的像素判別為前景,否則為背景。

高斯混合模型[4]能夠根據樣本值(像素點的顏色值)進入模型的不同頻率,以及和模型中各個分布成功匹配的不同頻率,來不斷更新模型中所有高斯分布的參數,即對各個高斯分布的權重、均值和協方差等參數進行訓練,使背景像素值分布收斂于一個或幾個高斯分布,實現背景像素值的聚類,從而實現對背景的建模。

1.2模型定義

在高斯混合模型中視頻幀(或者圖像序列)中的某個像素點的顏色值構成了對應的像素值:

{X1,X2,…Xt}={I(x,y,i),1≤i≤t}

(1)

其中,I(x,y,i)表示像素點(x,y)在i時刻的顏色值。高斯混合背景建模就是假設該像素值滿足高斯混合分布,即對每個像素點建立一個由K個單高斯模型混合而成的高斯混合模型:

(2)

(3)

其中,n表示Xt的維數。

K一般取3~5之間,K值越大,處理波動能力[5]越強,所需處理時間也越長。K中每個狀態用一個高斯函數表示。為了避免繁瑣的矩陣運算,通常假設像素值X的各分量(如RGB顏色模型中的紅綠藍分量)相互獨立,并且具有相同的協方差,此假設可以加快運算速度并且對結果影響很小。

1.3模型匹配和更新

高斯混合背景建模首先將當前像素值與模型中的K個高斯分布匹配,若第j個模型滿足下式:

|xt-μj,t-1|<2.5σj,t-1

(4)

則認為當前像素點與j個分布匹配成功,并中止與后續模型的匹配。否則取當前觀測值為均值,給定一個較大的值為方差,構造一個新的高斯分布,替代ω/σ最小的分布;然后,根據當前像素與其K個高斯分布相匹配的結果對模型進行更新[6]。對于未匹配上的模型,其均值和方差均保持不變,而匹配成功的第j個模型按下列方式更新:

(5)

其中,α為學習速率,它反映了當前像素融入背景模型的速率。匹配的分布Mi,t=1,其余分布Mi,t=0。

2 改進的背景建模算法

本文采用碼本(CB)和高斯混合模型(GMM)的方法構建給定場景的背景模型[7]。一個碼本背景模型的幾何結構通常使用傳統的d維碼字策略算法(dBCS)[8]來展現數據集。在采用dBCS算法進行建模的過程中,背景模型是以一組像素碼本的碼字組成的幾個實際觀察的樣本范圍為藍本的。在具有二維數據集的情況下,一個碼字可以代表一個矩形結構的兩側顯示水平和垂直范圍覆蓋的訓練樣本。該方案已被廣泛采用,因為它快速的運行速度可以在實際監控場合應用。然而,在許多情況下,是無法準確地檢測出運動目標的,因為在運動背景情況下,它忽略了訓練數據集的概率信息。

對于連續的視頻幀,每當觀察到顏色樣本T數是在一個像素位置時,系統自動將其聚類為若干dBCS編碼。然后對每一個碼字計算其權重,構建最終的CB-GMM背景模型的均值和協方差[9]。圖1為視頻幀背景分離的定性檢測結果,由此可以判斷CB-GMM 算法較之dBCS 算法對于快速變化的背景其分離效果具有更好的魯棒性[10],并且能夠良好適應背景和光照的變化。在下面的章節中,對背景建模方法進行了更詳細的說明。

圖1 背景分離的定性檢測結果

3 實驗結果及分析

為驗證本文方法的可行性及其算法性能,分別對688×565, 768×576的兩段視頻序列進行了背景建模。取背景學習率為0.002a-6k=0.1,對各算法進行了實時性、資源占用情況、準確率等方面的測試和比較。

表1為GMM、dBCS和CB-GMM三種背景建模方法下對應的精確率[11]、召回率和內存占用的比較。該數據是通過對以上三種算法在兩段視頻序列上進行多次測試后得出的平均值。從表中數據可以得出結論:GMM實時性最差且準確率較低,而其內存占用較少,這與其算法特性較為符合;而dBCS則相對GMM的內存占用增加了,但其準確率和召回率都有所提高;CB-GMM的準確率最高,召回率也為三者最高,但內存占用情況也為最多。綜上所述,在內存占用可以接受的范圍內,CB-GMM算法的性能最優,有較高的精確度和召回率,對于背景建模能夠取得較好的效果。

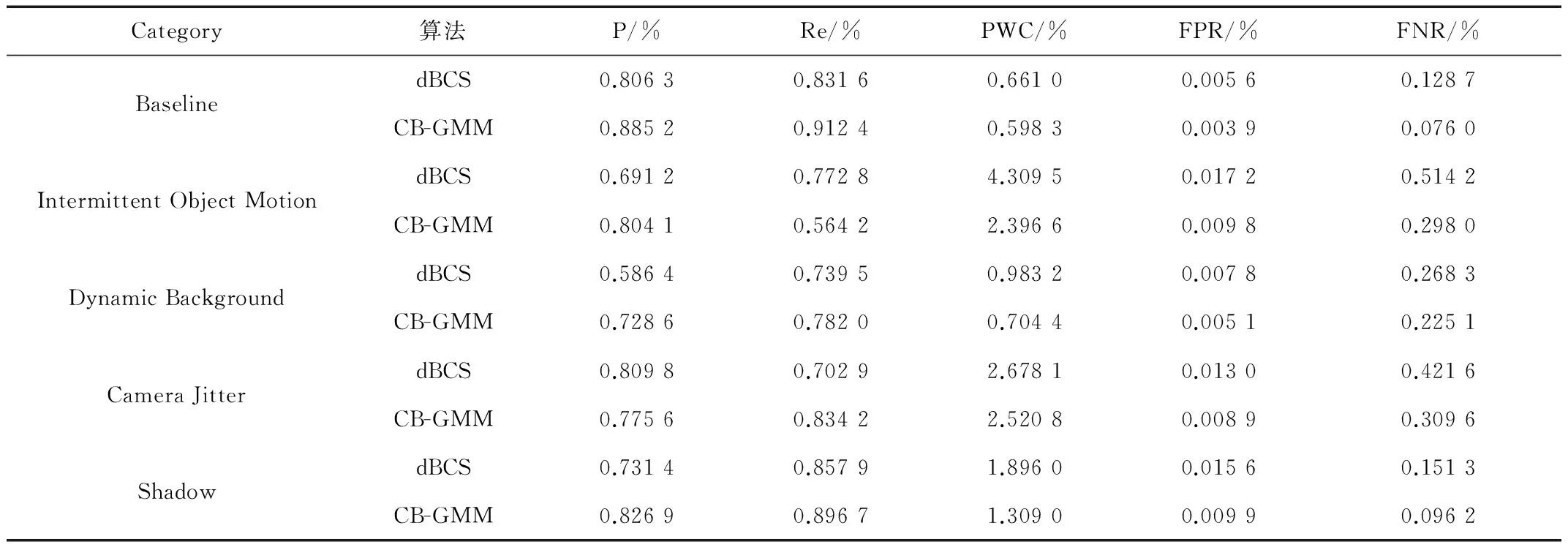

表2為基線(Baseline)、目標移動(Intermittent Object Motion)、動態背景(Dynamic Background)、相機抖動(Camera

表1 各算法的評價性能比較

Jitter)和陰影(Shadow)5種背景下針對dBCS和CB-GMM兩種背景分離算法進行的實驗數據對比。該實驗數據對比結果中包括了5個性能指標,分別為準確率(P)、召回率(Re)、錯分率(PWC)、假陽性率(FPR)和假陰性率(FNR)[12]。通過對5個場景中每一處對應度量計算其平均值來獲得所評估方法的平均性能度量。平均值的排名對應于通過參與每個平均度量的每個評估方法獲得的排名的平均值,因此為不同應用場景下給定方法的性能指標提供依據。

圖2為dBCS算法和CB-GMM算法進行背景建模的效果比較圖,其中將空間域檢測法僅應用在前端的運動檢測中,并未使用在前景點集的二次判斷,也即未用于區分運動物體和其陰影。測試圖像選取的序列分別為第435、753、998、和1 352幀。從圖中可以看出,本文CB-GMM算法檢測效果在背景分離的初步判斷較dBCS算法的檢測效果更為精確。

表2 不同場景下各算法的實驗數據對比

圖2 兩種算法的背景分離結果

4 結束語

本文提出了一種改進的碼本和高斯混合模型背景分離方法。為了構建和更新對于給定場景中的背景模型,在無偏估計的基礎上,利用高效計算d維碼字的方法來確定GMM背景模型的參數。通過對視頻幀中每個像素的高斯分布數目進行動態控制,并且通過codebook算法對高斯分布的各參數進行學習,此外還可根據場景的變化實時調整每個像素的權值更新速率。筆者對其結果進行了多次實驗與測試,驗證了該算法對于背景分離具有較好的分離效果。然而,當它們的顏色特征與那些背景或場景十分相似時該方法可能無法檢測前景區域。為了克服這個缺點,接下來會考慮將語義信息作為今后的工作以提高水平。

[1] POWER P W, SCHOONEES J A. Understanding background mixture models for foreground segmentation[J]. Image and Vision Computing, 2006,24(5): 267-271.

[2] Seung Jong Noh, Moongu Jeon. A new framework for backgroudn subtraction using mulltiple cues[C]. In Eleventh Asian Conference on Computer Vision, 2012: 493-506.

[3] ELGAMMAL A, HARWOOD D, DAVIS L S. Non- parametric model for background subtraction[C]. In Thirteenth European Conference on Computer Vision, 2000: 751-767.

[4] HORPRASERT T, HARWOOD D, DAVIS L S. A statistical approach for real-time robust background subtraction and shadow detection[C]. In Proc. IEEE Conf. ICCV, 1999,99: 1-19.

[5] TOYAMA K, KRUMM J, BRUMITT B, et al. Wallflower: Principles and practice of background maintenance[C]. In Proc. IEEE Int. Conf. Comput. Vis., Sep. 1999: 255-261.

[6] BRUTZER S, HOFERLIN B, HEIDEMANN G. Evaluation of background subtraction techniques for video surveillance[C]. In Proc. IEEE Int. Conf. Comput. Vis. Pattern Recognit., Jun. 2011: 1937-1944.

[7] LEE D S. Effective Gaussian mixture learning for video background subtraction[J]. IEEE Transactions on Pattern Anal. Machactions on Intell., 2005,27(5): 827-832.

[8] GORUR P, AMRUTUR B. Speeded up Gaussian mixture model algorithm for background subtraction[C]. In Proc. 8th IEEE Int. Conf. Adv. Video Signal Based Surveillance, Sep. 2011: 386-391.

[9] UEDA N, NAKANO R, GHAHRAMANI Z, et al. Split and merge EM algorithm for improving Gaussian mixture density estimates[J]. VLSI Signal Process, 2000,26(1-2): 133-140.

[10] BOUMANS T. Advanced statistical background modeling for foreground detection[J]. RPCS. J., 2011(4): 147-176.

[11] DAVID M W. Evaluation: from precsion, recall and F-measure to ROC[J]. Informedness, markedness & Correlation, MLT. J., 2011(2): 37-63.

[12] 申勤.基于模糊C均值聚類的遙感圖像分割方法[J].微型機與應用,2011,30(1):30-31.

An improved video background separation based on codebook and Gaussian mixture model

Zhan Min, Zou Xiaobo

(College of Technology,Huaqiao University, Quanzhou 362021, China)

This paper proposes a video background separation method based on improved Codebook (CB) and Gauss mixture model (GMM).This method is based on the adaptive Gauss mixture model background, and constructs a hybrid Gauss background model for each pixel color, which can dynamically control the Gauss distribution number of each pixel in the video frame, and through CB (Codebook) algorithm to obtain each pixel of the time series model, and study on the parameters of Gauss distribution.The experimental results show that the proposed method in accuracy and time background separation have shown excellent performance, also has good applicability, changes of a complex environment, can effectively separate the foreground and background from a video.

Codebook(CB); Gauss Mixture Model(GMM); background separation; video frame; gauss distribution

TP391

A

10.19358/j.issn.1674- 7720.2017.19.014

詹敏,鄒小波.一種改進的基于碼本和高斯混合模型的視頻背景分離[J].微型機與應用,2017,36(19):48-51.

華僑大學研究生科研創新能力培育計劃項目(1511422006)

2017-03-14)

詹敏(1993-),女,碩士,主要研究方向:圖像處理與模式識別、行人再識別。鄒小波(1993-),男,碩士,主要研究方向:大數據技術、數據挖掘。