圍棋“大師”背后的科技力量

劉嘟嘟

人工智能的領跑者

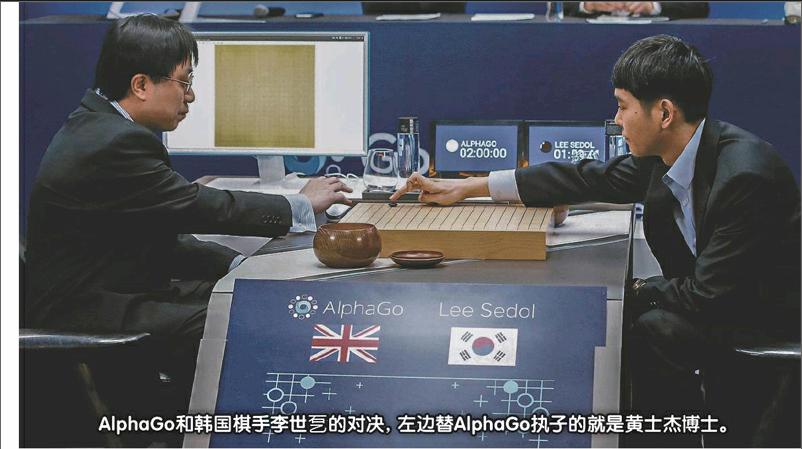

著名的人工智能圍棋程序AlphaGo在2016年3月與韓國頂尖圍棋高手李世乭進行人機大戰,并以4:1的總比分獲勝。與李世乭的對決讓世界看到了人工智能的無限潛力,而到了2016年歲末,AlphaGo的進擊版更是通過名為Master(“大師”)的賬號,在網絡上與中韓高手連番過招,以連贏60場的成績令人驚嘆。

在創造這一前所未有圍棋奇跡的背后,是一支充滿了智慧和活力、用數字構建未來的團隊——DeepMind。

在倫敦國王十字火車站旁邊一座不起眼的建筑里,藏著這樣一家潛力無限的公司DeepMind(深度思維),該公司努力將機器學習和人類系統神經科學的先進技術結合,發展人工智能深度學習,建立強大的通用算法,將這種技術與游戲、醫療等多項實用產業結合。誰也不曾想到,一家成立于2010年的年輕初創公司會是世界兩大科技巨頭——谷歌和臉書競相爭奪的寶物。最終谷歌獲勝,2014年,谷歌公司以4億英鎊的高價將DeepMind收歸麾下,該公司正式成為谷歌旗下人工智能領域探索的排頭兵。

谷歌和臉書已經在機器學習和人工智能領域走在世界最前沿了,那么,這家公司到底存在著怎樣的價值,吸引了這些行業巨頭的注意呢?

谷歌招攬的超強大腦

DeepMind可以說是一個智庫集合,集結了400余名優秀的計算機科學家和神經學專家。下面這些人物可謂是DeepMind 團隊精英中的精英。

德米斯·哈薩比斯

身為DeepMind創始人之一,德米斯·哈薩比斯可以說是整個公司的核心人物。哈薩比斯1976年出生于英國倫敦,4歲開始下國際象棋,13歲時就已經獲得國際象棋大師頭銜,15歲時,他連跳兩級,提前從高中畢業。1993年,17歲的哈薩比斯進入劍橋大學學習計算機專業,同年,他依靠自己開發的游戲獲得了某游戲設計比賽的亞軍,進入頂尖游戲公司“牛蛙”實習,并參與開發了在全球風靡一時的虛擬游戲《主題公園》。

自1999年至2003年,哈薩比斯連續5年參加“國際智力奧運會”,連奪5次冠軍,可謂是“地球上最聰明的男人”。2005年,29歲的哈薩比斯重新走進學校,在英國倫敦大學攻讀神經科學博士學位,潛心研究負責記憶、學習、空間導向的大腦海馬體。2011年,35歲的哈薩比斯結合自己游戲設計、計算機編程和神經科學研究經驗,成立DeepMind科技公司,專注研究模仿大腦的人工智能系統。

黃士杰

AlphaGo設計團隊的另一位杰出人才是來自臺灣的黃士杰博士。黃士杰本科就讀于臺灣交通大學,研究生和博士在臺灣師范大學研習。他從小熱愛圍棋,是個業余六段圍棋選手,在臺灣師范大學讀書時就曾經在學校創辦圍棋社。大學期間,黃士杰醉心研究圍棋軟件開發,他設計的軟件參加國際電腦奧林匹克競賽,獲得19路電腦圍棋金牌,這個程序甚至擊敗了當時圍棋人工智能領域公認最強的程序“Zen”,在業內引起極大的轟動。隨后,他進入加拿大阿爾伯塔大學繼續圍棋程序研究。在博士和博士后階段,他深入研究蒙特卡洛樹搜索技術,后來將其運用在AlphaGo的走棋程序當中。

大衛·西爾弗

大衛·西爾弗是哈薩比斯在劍橋大學讀書期間認識的朋友,計算機專業的他常年霸占著專業第一的寶座。在校期間,他還教會了哈薩比斯多種棋類游戲的玩法,包括圍棋。1998年,哈薩比斯創立游戲公司Elixir Studios,西爾弗作為聯合創始人之一,在這間公司擔任首席技術官和主程序設計師。2004年,他進入加拿大阿爾伯塔大學攻讀博士學位,研究人工智能增強學習。2013年,西爾弗重新與哈薩比斯會合,加入DeepMind團隊,以增強學習技術助力AlphaGo的設計和程序優化。

除了上面這些人,DeepMind中還有諸多學界執牛耳者,在神經科學、計算機科學、卷積神經網絡研究等方面人才濟濟。DeepMind簡直就是一群超級極客組合而成的深度學習全明星戰隊。

“大師”是怎樣煉成的

DeepMind發布的AlphaGo在圍棋棋局上出盡風頭,讓世界級的圍棋大師們為之驚嘆。圍棋規則看似簡單,但棋局變化卻相當多,在很長的時間里,圍棋都被視為人工智能開發領域的一座難以攻克的圣杯。圍棋第一步361個點,下第二步有360點,如果要下到底,大概有10360種下法,即便運算量驚人的計算機也很難找到最佳解法。

AlphaGo和傳統的計算機圍棋游戲完全不同,可以進行深度學習。它并非只是按照棋局庫的固定章法來照本宣科,而是能夠進行自我學習和提升,以現有數據庫為基礎主動創造新棋路,甚至能夠走出讓專業棋手摸不著頭腦的步法。

DeepMind主攻人工智能的意識,讓機器理解自己的任務的同時,也能夠理解環境或別人在做什么,并據此作出反應,完成決定。首先,需要讓計算機“懂得”棋局的規則,程序員將圍棋以計算機語言描述出來。比如在19×19的棋盤上的361個交叉點進行定義。

人類在下圍棋時,除了謀篇布局,精妙計算之外,更重要的是基于棋手經驗的“直覺”在幫助棋手思考,為棋手指路。AlphaGo也運用了這種方法,與深度學習結合,利用“策略網絡”與“價值網絡”優化人工智能的走棋。策略網絡可以判斷出最佳棋路,就好像人類用直覺來下出好棋一樣。當然,開發團隊也會事先給AlphaGo閱讀各種不同的參考棋譜。至于“價值網絡”則能幫助計算機在搜尋一個點之后,判斷盤面局勢、優勢大小。

所以,當計算機懂得走棋的任務后,它可以再隨機選擇落點進行走棋訓練,對取勝率較高的落點展開深入研究,并通過觀察上百萬局棋譜來豐富計算機的走棋數據庫。綜合這些信息后,計算機能夠反復進行左右互搏的對弈訓練,強化學習,自我精進。而且,通過結合神經科學的計算機深度學習,利用蒙特卡洛樹搜索和卷積神經網絡等技術手段,計算機可以改進現有的經驗,創造獨特的新經驗,并將這些智慧結晶內化,成為幾乎可以獨立“思考”的超級圍棋大師。

人工智能的“下半場”

日本著名圍棋棋士藤澤秀行曾說過:“棋道一百,我只知七”。即使是棋藝最高的棋手在圍棋對弈方面所參悟的也十分有限,以七搏百,量力難行。AlphaGo的出現既是人工智能技術向人類發出的挑戰,同時也是這一技術在向人類伸出援手。

人工智能在圍棋領域帶來的沖擊預示了它將在互聯網的“下半場”中大放異彩。未來,DeepMind可能將會成為谷歌公司的算法工廠,他們所深入研究的人工智能深度學習所涉及的范圍不會僅僅局限在棋盤之上,而是會運用在更多領域,用于解決更多更復雜的問題,從醫療到交通,我們生活的方方面面都會逐漸與其相聯結。谷歌將其收入麾下是一個非常明智的選擇,DeepMind未來將會創造更多價值。