基于字典學習的遙感影像超分辨率融合方法

李成軼, 田淑芳

(中國地質大學(北京)地球科學與資源學院,北京 100083)

基于字典學習的遙感影像超分辨率融合方法

李成軼, 田淑芳

(中國地質大學(北京)地球科學與資源學院,北京 100083)

鑒于多源遙感影像融合受現有分辨率的限制,結合稀疏表示理論,提出了一種基于字典學習的遙感影像超分辨率融合方法,可將多光譜影像的空間分辨率提升到全色影像空間分辨率的1倍或2倍。在遙感影像融合框架下,首先建立學習字典,利用冗余字典對影像稀疏表示,重構超分辨率; 然后采用Gram-Schmidt(GS)光譜銳化法,融合得到超分辨率多光譜影像。利用QuickBird數據對提出的方法進行3個實驗,結果都表明本文方法相對傳統融合方法、傳統超分辨率方法和其他字典學習方案具有一定優勢,適用于遙感影像超分辨率融合,可為多源遙感影像融合的超分辨率問題提供1種可行的解決方案,而且對其他融合方法也有借鑒意義。

QuickBird; 字典學習; 稀疏表示; 超分辨率; 影像融合

0 引言

遙感數據融合技術能對不同來源的數據進行優化組合,從而提高影像的分辨率和影像分析結果的準確性與置信度,并最終提高對待定目標自動監測和識別的有效性[1]。目前廣泛應用的像素級遙感影像融合,能更多地保留影像的原有信息,提供更多的細節信息[2]。然而傳統的像素級融合方法受現有分辨率的限制,常將多光譜影像通過插值方法“放大”到全色影像大小,再按一定的融合規則進行融合,因而在同一區域只能融合得到當前現有影像的分辨率; 而插值往往不能真實反映地物客觀情況,融合得到的影像信息可靠性不強。一些學者將稀疏表示法用于實現影像超分辨率,在重構影像的同時實現了影像“放大”,并很好地保證了影像質量[3]。

本文以突破遙感影像融合受現有分辨率限制為出發點,引入影像處理領域中的超分辨率影像重構概念。超分辨率影像重構的目的在于復原采樣之外的信息,使影像獲得更多的細節信息[4]。超分辨率影像重構有太多的未知數和病態條件組成的欠定方程組,其往往難以求解[5]。針對該問題,Stark等[6]采用了凸集投影,而Irani等[7]采用了反向迭代投影。針對上述方法的不足,本文利用字典學習具有的更好的稀疏性和自適應能力,提出了基于字典學習的遙感影像超分辨率融合方法。通過對樣本進行學習得到學習字典,利用字典稀疏表示分別實現影像各波段的超分辨率重構; 再把重構后的多光譜與全色影像按一定的融合規則進行融合,得到最終的超分辨率融合影像。

1 稀疏表示的基本原理

稀疏表示的主要思想是先求解源影像在冗余字典下最稀疏的表示,即稀疏表示系數; 再將稀疏表示系數與冗余字典相乘,從而精確地重構影像。

如果1個信號中大部分值為0,則稱這個信號是稀疏的; 若其中有K個不為0的值,則稱信號是K稀疏的(K-sparse)。信號的稀疏表示就是將信號投影到某個稀疏基,使絕大部分稀疏系數為0或很小,于是得到信號在這個稀疏基下的稀疏表示。常用的稀疏基有離散余弦變換基、快速傅里葉變換基、離散小波變換基、Curvelet基、Gabor基以及冗余字典等[8]。信號實值x∈RN×1可用稀疏基Ψ∈RN×K線性表示為[9]

x=Ψs,

(1)

式中s為信號x在稀疏基Ψ下的稀疏表示。

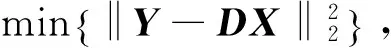

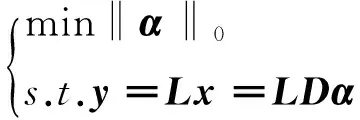

由少量測量值y重構x在本質上是1個病態問題,難以求解。但是,在壓縮感知先驗條件和理論框架下,信號x可由測量值y通過求解最優l0范數問題精確重構[10],即

(2)

式中L為測量矩陣,優化問題可以等價用l1范數最小化算法或用貪婪算法等求解。常用的l1范數最小化算法有基追蹤(basis pursuit,BP)和線性規劃等; 貪婪算法有正交匹配追蹤(orthogonal matching pursuit,OMP)等。線性規劃方法重構質量好,但計算復雜度很高[11-12]; 貪婪算法速度快,但迭代相同次數的重構質量較BP算法差[13]。

2 基于字典學習的超分辨率融合

2.1 超分辨率融合流程

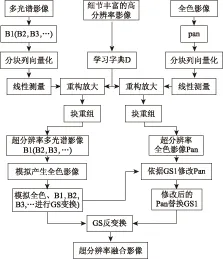

本文超分辨率融合的技術流程主要包括影像的超分辨率重構和對重構影像的優化組合(圖1)。

圖1 技術流程圖

2.2 字典學習

在基于字典的稀疏表示中,采用冗余字典作為稀疏基; 常用2類方法獲得冗余字典: ①采用固定字典; ②采用學習的方法獲得字典。針對選取固定字典的自適應性不足,本文采取用于K稀疏表示的奇異值分解(K-singular value decomposition,K-SVD)方法[14]對細節更豐富的遙感影像進行學習,獲得冗余字典,并與離散余弦轉換(discrete cosine transformation, DCT)固定字典進行比較。

K-SVD依據誤差最小的原則,對誤差項進行SVD分解,選擇使誤差最小的分解項作為更新的字典原子和對應的原子系數,經過不斷的迭代得到優化解,求解方法為

(3)

式中:Y為初始輸入的DCT字典;D為待求解的高分辨率字典;X為隨機選取的影像塊;i為X中的列號;T為稀疏度控制系數。

2.3 分波段超分辨率重構

分波段重構即分別對多光譜影像各波段和全色影像進行超分辨率重構。現有的超分辨率融合方法的處理思路是: 將3個波段進行RGB彩色合成; 對合成影像進行RGB向HIS彩色空間轉換后,再對其中的I分量重構,對H和S分量進行插值放大; 最后進行HIS逆變換,得到融合后的影像。這類融合方法在遙感應用中存在嚴重不足: ①沒有充分發揮遙感影像高光譜分辨率的優勢,遙感影像一般多于3個波段; ②僅對HIS中的1個分量進行重構,而對另2個分量值只進行簡單插值,這種處理方式得到的融合結果并不客觀、可靠性不高。

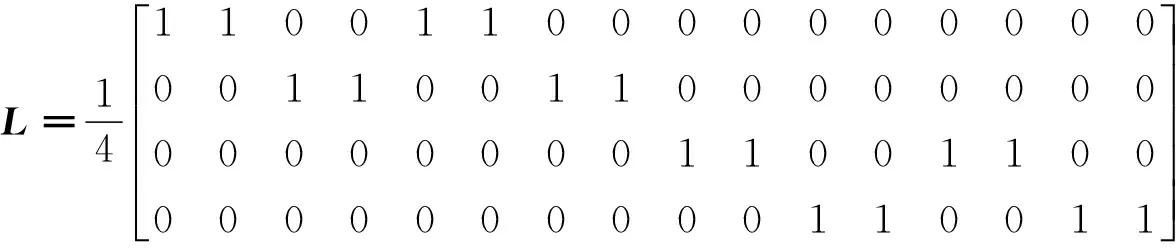

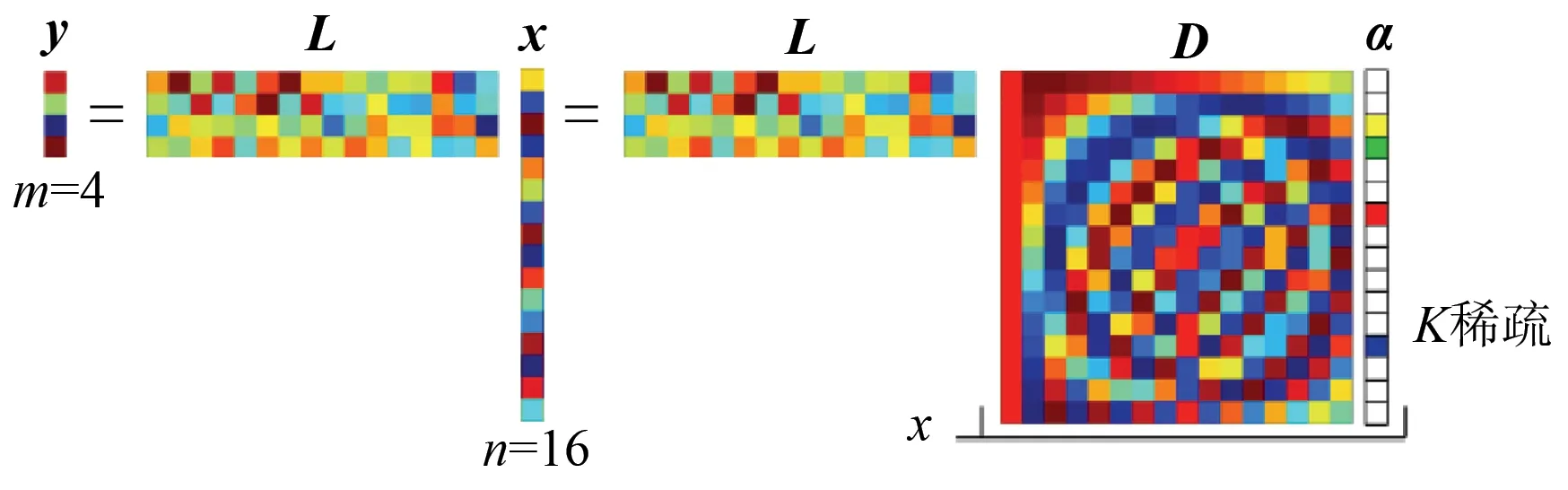

為此,分別把多光譜影像各波段和全色影像分塊列向量化。給定1個p×p(p∈Z+)低分辨率影像塊,將其按“列優先”原則轉化為向量y∈Rm,m=p2,重構獲得q×q(q∈Z+)超分辨率影像塊x∈Rn,n=q2。單個多光譜影像波段與全色影像的關系可以用一個線性測量矩陣L表示為

y=Lx,L∈Rm×n。

(4)

將y認為是x的1個下采樣版本,即把低分辨率影像認為是將超分辨率影像經過降質采樣后得到的影像,令p=2,q=4,則L∈R4×16有如下形式,即

(5)

重構放大系數為M=q/p。

根據式(5),低分辨率影像和超分辨率影像的關系可表示為

y=Lx=LDα,

(6)

式中:y為低分辨率影像塊向量;L為感知矩陣;x為超分辨率影像塊向量;α為x的稀疏表示;D為學習得到的冗余字典。

在冗余字典稀疏基下,超分辨率影像塊向量x被稀疏表示為α,感知矩陣L與x相乘對應到所觀測的低分辨率影像塊向量y。其中k為稀疏度,即向量α中只有k個值不為0(圖2)。

圖2 超分辨率重構示意圖

α∈RN,‖α‖0=K< (7) 對此,采用重構性能較好的基追蹤(BP)算法[15]求解。BP算法是基于l1范數的凸重建算法,即 (8) 式中ε為重構誤差。 2.4 融合規則 由于本文基于字典學習的超分辨率融合方法的核心技術體現在基于K-SVD學習字典分波段超分辨率環節,為了與遙感影像處理很好地結合,考慮到Gram-Schmidt(GS)正交化變換具有良好的數值穩定性,可充分利用每個波段的特性,消除矩陣的冗余信息,因此本文的融合規則僅選用遙感影像融合中常用的GS光譜銳化法為融合規則[16]。 GS光譜銳化方法融合步驟: ①從低分辨率的多光譜影像中復制出1個全色波段; ②對該全色波段和多光譜波段進行GS變換,其中全色波段被作為第1個波段; ③用GS變換后的第1個波段替換高空間分辨率的全色波段; ④應用GS反變換構成最終的超分辨率融合影像。 GS正交化算法如下: 設{u1,u2,…,un}是1組相互獨立的向量,通過GS變換構造正交向量{v1,v2,…,vn},則 實驗采用高分數據QuickBird作為數據源,對多光譜影像和全色影像進行超分辨率融合。仿真平臺硬件環境為: Intel(R)Core (TM)i7-3770CPU,4GB內存的PC機; 軟件開發工具為Windows7操作系統,MATLAB(R2013a)。 進行3個實驗,用本文方法對多光譜和全色影像進行超分辨率融合。實驗1(第3.1節)把多光譜影像分辨率提升到全色影像的分辨率,與傳統融合方法進行對比; 實驗2(第3.2節)把多光譜影像分辨率提升到全色影像分辨率的2倍,與傳統超分辨方法進行對比; 實驗3(第3.3節)提升多光譜影像分辨率到全色影像分辨率的2倍,與DCT固定字典超分辨率方法和文獻[17]中的K-SVD方法學習字典的超分辨率方法進行對比。為了分別評價本文方法融合的實際效果和突破分辨率的保真情況,實驗1主要引入平均梯度、信息熵、聯合熵、標準差和偏差指數作為評價指標,綜合評價本文方法與傳統方法的融合效果。在實驗2和實驗3中,由于將超分辨率放大到全色影像的2倍,缺少真值作為參考,因此舍棄了偏差指數和聯合熵,主要用平均梯度、信息熵和標準差作為評價指標,評價影像本身的質量。其中,平均梯度表征影像清晰度,信息熵表征信息豐富度,聯合熵表征與原影像信息的互信息關系,標準差表征影像對比度,偏差指數表征光譜失真度。 3.1 與傳統融合方法對比 針對QuickBird影像多光譜波段和全色波段進行融合,即把多光譜波段的空間分辨率從2.8 m提升到0.7 m,并與常用的HSV,Brovey和PCA影像融合方法進行對比分析。 對實驗結果(圖3)從目視角度可以看出,PCA融合影像失真嚴重,HSV和Brovey融合影像出現了彩色噪點,總體來說本文方法融合影像在視覺上具有優勢。 (a) HSV (b) PCA(c) Brovey(d) 本文方法 圖3 本文方法與傳統融合方法效果對比 Fig.3 Comparison of fusion effects between method proposed in this paper and traditional methods 表1為4種方法融合質量的客觀評價指標。 表1 4種方法融合質量評價 ①()內的數字表示評價指標從優到差排序的位置,(1)為最優,(4)為最差。 從表1可以看出,本文融合方法在平均梯度指標上僅次于HSV,而優于其他3種方法,清晰度較好; 而聯合熵指標最高,信息熵僅次于PCA,信息蘊含量大; 標準差指標僅次于HSV,對于人眼目視效果較好; 偏差指數指標最優,對光譜保持最好,較少產生畸變。本文方法在5項指標中占了2項最優、3項次優,綜合評價為4種融合方法中的質量最優融合方法。 3.2 與傳統超分辨率重構方法對比 為了驗證本文方法的超分辨率重構效果,分別用本文方法和常用的超分辨率插值方法將多光譜影像分辨率提高到全色影像的2倍,從平均梯度、信息熵、標準差和目視效果4個方面來評價重構結果。 圖4為同一個區域的QuickBird影像,其多光譜影像(圖4(a),Band3(R)Band2(G)Band 1(B)假彩色合成)空間分辨率為2.8 m(影像大小為512像元×512像元),全色影像分辨率為0.7 m(影像大小為2 048像元×2 048像元)。如果使用傳統融合方法,只能融合得到空間分辨率為0.7 m(影像大小為2 048像元×2 048像元)的多光譜影像。然而,在基于字典學習的超分辨率理論下,本文對影像進行超分辨率重構,突破了最大分辨率的限制,得到全色波段影像分辨率的2倍(空間分辨率為0.35 m,影像大小為4 096像元×4 096像元)的多光譜波段影像。 (a) 原始影像(b) 最鄰近(c) 雙線性(d) 三次卷積 (e) 本文方法 圖4 本文方法與超分辨率方法對比 (QuickBird B3(R),B2(G),B1(B)假彩色合成影像) Fig.4 Comparison between proposed method and traditional super-resolution method 圖4(a)是大小為512像元×512像元的QuickBird原始多光譜影像; 圖4(b)(c)(d)分別是原始影像經最鄰近、雙線性、三次卷積方法傳統超分辨率插值后放大到4 096像元×4 096像元后的影像; 圖4(e)是用本文方法融合提升到4 096像元×4 096像元后的高保真影像。由于進行了超分辨率放大,沒有真值作為參考,因此舍棄了聯合熵與偏差指數指標,本實驗主要選取了表征融合影像本身信息量的平均梯度、信息熵和標準差作為評價指標。質量評價結果表明(表2),基于插值的方法信息損失嚴重,影像會出現鋸齒現象,尤其是原始影像中的細節信息很容易出現過模糊現象; 而本文超分辨率融合的方法能很好地保留地物的真實信息,3項評價指標明顯優于傳統插值方法。 表2 超分辨率融合質量評價 ①()內的數字表示評價指標從優到差排序的位置,(1)為最優,(4)為最差。 3.3 K-SVD學習字典與DCT固定字典對比 考慮到一個合適的字典對重構影像非常重要,為了驗證本文K-SVD字典學習方法的有效性,針對本文融合過程中的重構環節,在文獻[17]基礎上做出了改進。文獻[17]基于字典學習策略實現了單景影像的超分辨率重構,其選取的訓練樣本為自然影像。為了使訓練字典的樣本空間細節更加豐富,考慮到WorldView2影像分辨率更高(全色影像空間分辨率0.5 m,多光譜影像空間分辨率1.8 m),細節更豐富,且與QuickBird影像的統計特征相似,本文有針對性地采用空間分辨率為0.5 m的WorldView2全色波段影像(影像大小為3 075像元×3 502像元)隨機提取100 000個小塊(每個小塊為4像元×4像元)作為樣本訓練字典, 并且采用K-SVD方法進行字典學習(圖5); 在此基礎上結合融合規則,能更好地補充QuickBird影像的細節信息,使其各波段經超分辨率融合后信息量保持更大,得到空間分辨率是全色波段影像分別率2倍的超分辨率多光譜影像。 (a) 用于訓練字典的WorldView2影像 (b) DCT字典 (c) 文獻[17]字典 (d) 本文字典 圖5 WorldView2影像及其訓練得到的字典 Fig.5 WorldView2 image and its dictionaries obtained by training 圖6(a)是大小為512像元×512像元的原始影像, 圖6(b)(c)(d)分別是用DCT字典、經文獻[17]的稀疏重構和本文方法超分辨率融合提升到4 096像元×4 096像元后的高保真影像。 (a) 原始影像(b) DCT字典(c) 文獻[17]方法(d) 本文方法 圖6 不同字典獲取方法對比 Fig.6 Comparison among different dictionary access methods 由于進行了超分辨率放大,沒有真值作為參考,因此舍棄了聯合熵與偏差指數指標,本實驗主要選取了表征融合影像本身信息量的平均梯度、信息熵和標準差作為評價指標(表3)。可以看出,本文、DCT和文獻[17]的基于重構的方法均能很好地保留地物真實信息,3項指標均明顯優于實驗2中傳統插值方法,學習字典的方法較之DCT字典方法重構的質量更好,本文方法比DCT字典和文獻[17]的超分辨率重構方法得到的融合影像在評價指標和目視效果上都更為合理,擁有3項最優的地位。 表3 不同字典獲取方法融合質量評價 ①()內的數字表示評價指標從優到差排序的位置,(1)為最優,(4)為最差。 1)本文提出了一種基于字典學習的遙感影像超分辨率融合方法,實現了稀疏表示超分辨率與影像融合的結合。該方法通過超分辨重構使多光譜和全色影像分別達到預期空間分辨率大小,解決了遙感影像融合中突破現有分辨率限制的問題; 既可達到傳統意義上的融合目的,也能突破現有分辨率,得到更高分辨率的遙感影像。 2)相對于其他基于稀疏表示和字典學習的影像超分辨率方案,本文提出的方法針對更高分辨率遙感影像選取K-SVD方法訓練字典,能達到更好的遙感影像超分辨率融合效果。 3)有資料顯示,噪聲與信號的稀疏情況不同。本文的重構算法(BP)也常用于稀疏信號去噪,在理論上本文方法具有一定的抗噪性,因篇幅有限,本文暫未進行詳細論述。 本文方法依然在以下方面有待改進和發展: ①如何找到一個合適的稀疏基,使影像最為稀疏,確保重構精度更高; ②改進重構方法,提高重構效率; ③進一步與壓縮感知理論相結合,改進傳感器采樣方式,實現在壓縮域進行融合重構,這在海量高精度遙感數據處理和應用中具有良好的發展前景。 [1] 柴艷妹.多源遙感圖像融合技術研究[D].西安:西北工業大學,2004. Chai Y M.The Study on Multi-sensor Image Fusion in Remote Sensing[D].Xi’an:Northwestern Polytechnical University,2004. [2] 謝茜.像素級遙感圖像融合方法研究[D].長沙:中南大學,2009. Xie X.Remote Sensing Image Fusion Method Based on Pixel-level[D].Changsha:Central South University,2009. [3] Yang J C,Wright J,Huang T S,et al.Image super-resolution via sparse representation[J].IEEE Transactions on Image Processing,2010,19(11):2861-2873. [4] 蘇秉華,金偉其,牛麗紅,等.超分辨率圖像復原及其進展[J].光學技術,2001,27(1):6-9. Sun B H,Jin W Q,Niu L H,et al.Super-resolution image restoration and progress[J].Optical Technique,2001,27(1):6-9. [5] 史祥燕.基于稀疏表示的視頻圖像超分辨率重建算法研究[D].大連:大連海事大學,2013. Shi X Y.Research on Sparse Representation Based Video Super-resolution Reconstruction Algorithm[D].Dalian:Dalian Maritime University,2013. [6] Stark H,Oskoui P.High-resolution image recovery from image-plane arrays,using convex projections[J].Journal of the Optical Society of America A,1989,6(11):1715-1726. [7] Irani M,Peleg S.Improving resolution by image registration[J].CVGIP:Graphical Models and Image Processing,1991,53(3):231-239. [8] 李樹濤,魏丹.壓縮傳感綜述[J].自動化學報,2009,35(11):1369-1377. Li S T,Wei D.A survey on compressive sensing[J].Acta Automatica Sinica,2009,35(11):1369-1377. [9] Wan T,Canagarajah N,Achim A.Compressive image fusion[C]//Proceedings of the 15th IEEE International Conference on Image Processing.San Diego,CA:IEEE,2008:1308-1311. [10]Donoho D L.Compressed sensing[J].IEEE Transactions on Information Theory,2006,52(4):1289-1306. [11]Candès E J,Romberg J,Tao T.Robust uncertainty principles:Exact signal reconstruction from highly incomplete frequency information[J].IEEE Transactions on Information Theory,2006,52(2):489-509. [12]Candès E J.Compressive sampling[C]//Proceedings of the International Congress of Mathematicians.Madrid:[s.n.],2006:1433-1452. [13]Tropp J A,Gilbert A C.Signal recovery from random measurements via orthogonal matching pursuit[J].IEEE Transactions on Information Theory,2007,53(12):4655-4666. [14]Aharon M,Elad M,Bruckstein A.rmK-SVD:An algorithm for designing overcomplete dictionaries for sparse representation[J].IEEE Transactions on Signal Processing,2006,54(11):4311-4322. [15]Chen S S,Donoho D L,Saunders M A.Atomic decomposition by basis pursuit[J].SIAM Journal on Scientific Computing,1998,20(1):33-61. [16]黃健,顧海.基于Gram-Schmidt變換的QuickBird影像融合[C]//地理信息與物聯網論壇暨江蘇省測繪學會2010年學術年會論文集.無錫:江蘇省測繪學會,2010. Huang J,Gu H.QuickBird image fusion based on Gramm-Schmidt transform[C]//Geographic Information and Internet BBS and Surveying and Mapping Institute of Jiangsu Province in 2010 Academic Essays.Wuxi:Jiangsu Surveying and Mapping Institute,2010. [17]Yang S Y,Sun F H, Wang M,et al.Novel super resolution restoration of remote sensing images based on compressive sensing and example patches-aided dictionary learning[C]//Proceedings of the 2011 International Workshop on Multi-Platform/Multi-Sensor Remote Sensing and Mapping.Xiamen:IEEE,2011:1-6. (責任編輯: 邢宇) Super-resolution fusion method for remote sensing image based on dictionary learning LI Chengyi, TIAN Shufang (SchoolofEarthSciencesandResources,ChinaUniversityofGeosciences(Beijing),Beijing100083,China) In consideration of the fact that multi-source remote sensing image fusion is restricted by the existing resolution, the authors propose a super-resolution remote sensing image fusion method based on dictionary learning with sparse representation theory in this paper. The spatial resolution of multispectral images can be promoted to 1 or 2 times higher than the spatial resolution of panchromatic image. Under the framework of the method in remote sensing image fusion, a learning dictionary was established, the redundant dictionary on image sparse representation was used to conduct super-resolution reconstruction implementation. Then the Gram-Schmidt(GS)spectrum sharpening method was used as a fusion rule to obtain super resolution multispectral image fusion. Three experiments were carried out using QuickBird data. The results show that the proposed method is suitable for remote sensing image super-resolution fusion with some advantages in comparison with traditional fusion method, traditional super-resolution method and the other dictionary learning strategy. This paper provides a feasible solution for multi-source remote sensing image fusion, and has referential significance for other fusion methods. QuickBird; dictionary learning; sparse representation; super-resolution; image fusion 10.6046/gtzyyg.2017.01.08 李成軼,田淑芳.基于字典學習的遙感影像超分辨率融合方法[J].國土資源遙感,2017,29(1):50-56.(Li C Y,Tian S F.Super-resolution fusion method for remote sensing image based on dictionary learning[J].Remote Sensing for Land and Resources,2017,29(1):50-56.) 2015-07-24; 2015-11-20 中國地質調查局地質調查項目“京津地區礦產資源開發環境遙感監測”(編號: 12120115060901)資助。 李成軼(1992- ),男,碩士研究生,主要研究方向為遙感與GIS數據處理。Email: lcy@cugb.edu.cn。 田淑芳(1963-),女,副教授,主要從事遙感與GIS的教學和科研工作。Email: sftian@cugb.edu.cn。 TP 751.1 A 1001-070X(2017)01-0050-07

3 結果與分析

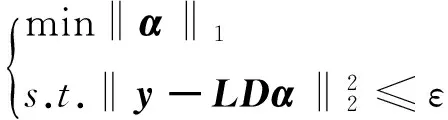

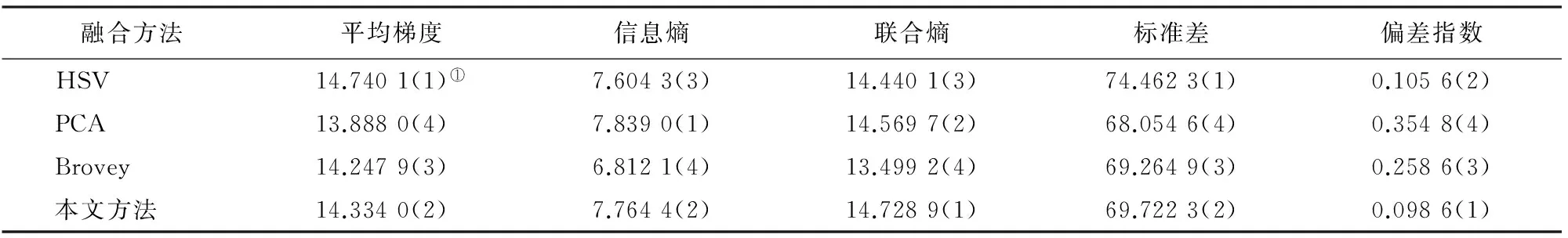

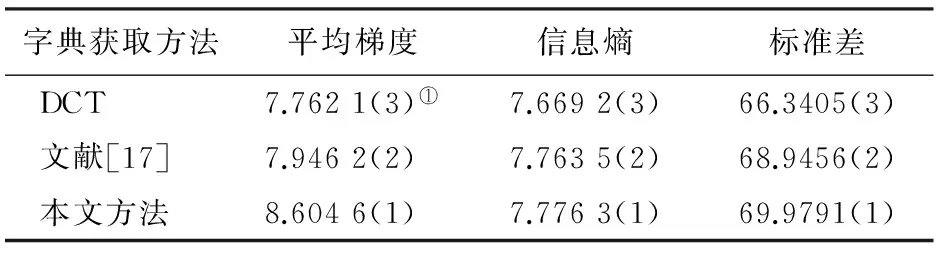

4 結論