基于Kinect的拆卸工具運動軌跡識別方法

張志佳,魏 信,周自強,劉 政

(1.沈陽工業大學 視覺檢測技術研究所,沈陽 110020;2.江蘇省機電產品循環利用技術重點建設實驗室,常熟 215500;3.遼寧省廣播電視中心發射臺,沈陽 110016)

基于Kinect的拆卸工具運動軌跡識別方法

張志佳1,2,魏 信1,2,周自強2,劉 政3

(1.沈陽工業大學 視覺檢測技術研究所,沈陽 110020;2.江蘇省機電產品循環利用技術重點建設實驗室,常熟 215500;3.遼寧省廣播電視中心發射臺,沈陽 110016)

為了獲取拆卸工具的運動軌跡,提出了基于Kinect的軌跡識別方法。首先采用Kinect傳感器獲取拆卸人員前臂及拆卸工具深度圖像,通過圖像細化獲得拆卸工具頂端位置并提取軌跡特征,進而提出了一種基于歐式距離和隨機抽樣一致性的樣本軌跡預處理方法,然后利用隱馬爾科夫模型(HMM)訓練軌跡樣本并實現軌跡的識別。實驗結果表明,該方法能有效地識別拆卸工具運動軌跡,并且對樣本預處理后,能顯著提高識別率。

Kinect傳感器;深度圖像;圖像細化;歐式距離;隨機抽樣一致性;隱馬爾科夫

0 引言

在廢舊產品的自動化拆卸中,如何獲取人工拆卸的相關信息并進行學習,能大幅度提高拆卸過程的自動化程度。Kinect設備是微軟于2010年正式推出[1,5],可以獲取RGB和深度圖像數據,同時進行實時的全身骨骼跟蹤[2],并可以進行人體動作姿態識別[3,4]。目前大部分運動跟蹤設備需要穿戴,通過標記來識別[6],微軟開發的Kinect不做任何標定直接獲取人體姿態動作,滿足了便捷性。

Kinect在人體手勢識別方面[7]已經有了研究,但在利用拆卸工具的情況下,對拆卸工具的軌跡識別還未見有相關研究。基于以上背景,本文提出基于Kinect的拆卸工具運動軌跡識別方法。該方法通過Kinect提取手持拆卸工具的深度圖像,并進行二值化、圖像細化[8]等處理,獲取拆卸工具頂端位置,提取拆卸工具軌跡,然后對提取的軌跡進行量化編碼。構建隱馬爾科夫(HMM)模型[9],將編碼值輸入到HMM模型中進行訓練,優化選取模型參數,實現拆卸工具軌跡識別。

1 Kinect與關節跟蹤

Kinect共有三個攝像頭(如圖1所示),中間的鏡頭是RGB彩色攝像頭,左右兩邊鏡頭分別是紅外線發射器和紅外線CMOS攝像機。Kinect在底部還配備了傳動馬達,在兩側內置了陣列麥克風系統,用于語音識別。

圖1 Kinect傳感器

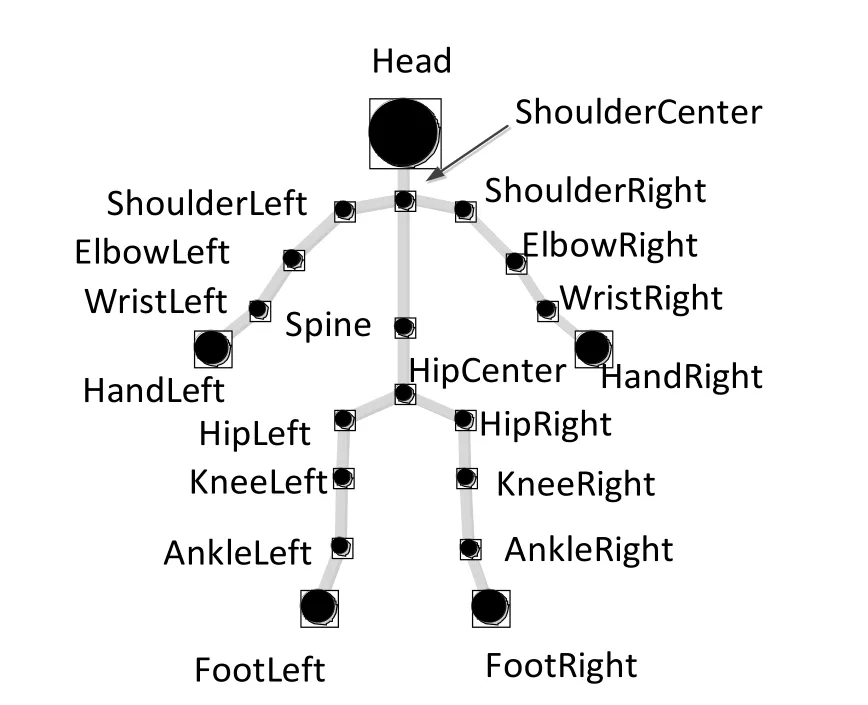

Kinect具有骨骼跟蹤技術,它是通過處理深度數據來建立人體各個關節的坐標,骨骼追蹤能夠確定人體各個部分(如:手,頭部以及身體),還能確定他們相對于Kinect所在的空間位置。基于這一特性,在拆卸過程中,可以利用Kinect對人體骨骼進行跟蹤。

圖2 20個人體關節點

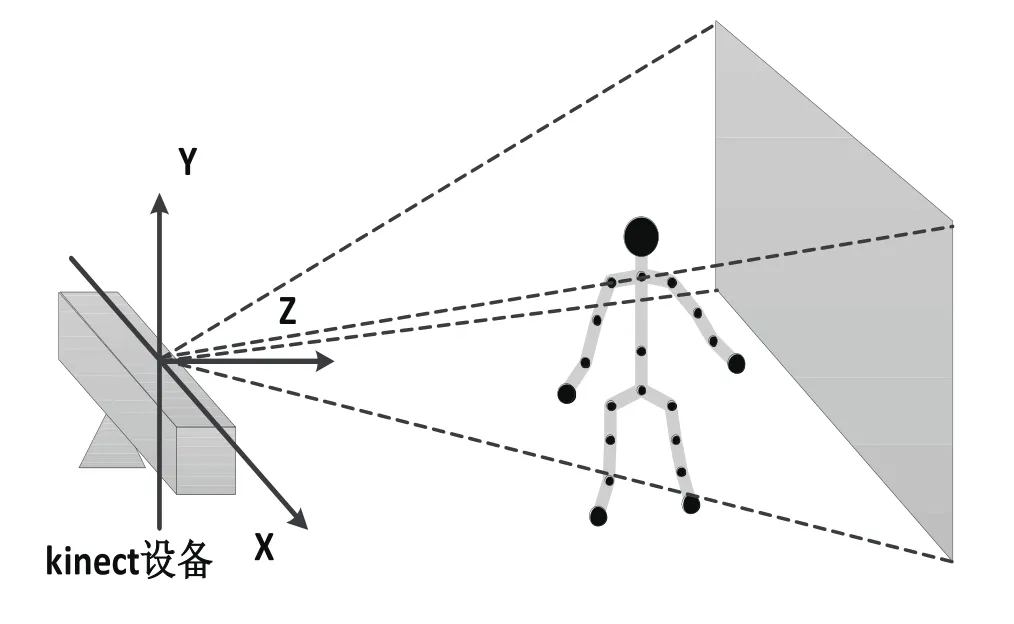

Kinect系統通過20個關節點來表示一個骨架,如圖2所示。當人進入如圖3所示的Kinect視野范圍內,Kinect會把人的20個骨骼關節點找到,且以坐標形式表示出來。

圖3 Kinect場景內的人體骨骼

2 軌跡提取及預處理

手持拆卸工具的軌跡提取主要包括以下主要步驟:提取右臂及拆卸工具的深度圖像,對深度圖像二值化;然后對二值化圖像進行細化,獲取細化圖像頂端的位置;提取拆卸工具運動軌跡,將軌跡進行量化編碼,以方便對軌跡進行識別。

2.1 獲取工具的深度圖像

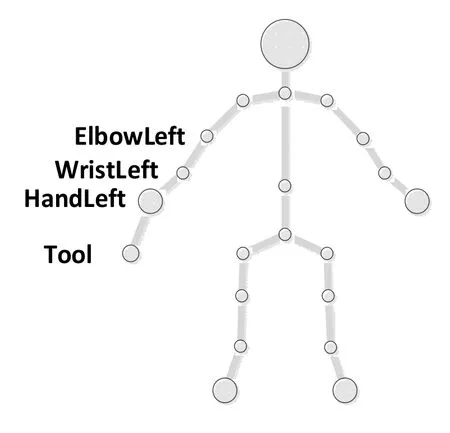

深度圖像包含與場景物體表面距離有關信息的一種圖像。與彩色圖像相比,深度圖像能反映物體表面的三維特征,且不受光照等外在因素的影響。利用Kinect獲得的深度圖像可以對人體主要部位進行識別,本文主要研究手持拆卸工具軌跡,所以對手持拆卸工具進行識別。加入工具的關節點作為第21個關節點,如圖4所示。

圖4 21個人體關節點

由于是手持拆卸工具,為了獲取更多的圖像信息方便圖像處理,利用Kinect提取前臂及拆卸工具的整個深度圖像如圖5所示。

圖5 右前臂及拆卸工具

2.2 圖像細化

由于獲取的前臂及拆卸工具深度圖像特征不精細,這給拆卸工具頂端坐標獲取帶來很大難度,因此引入圖像分析方法,得到一個精細的骨架特征,這就是圖像細化[8]。

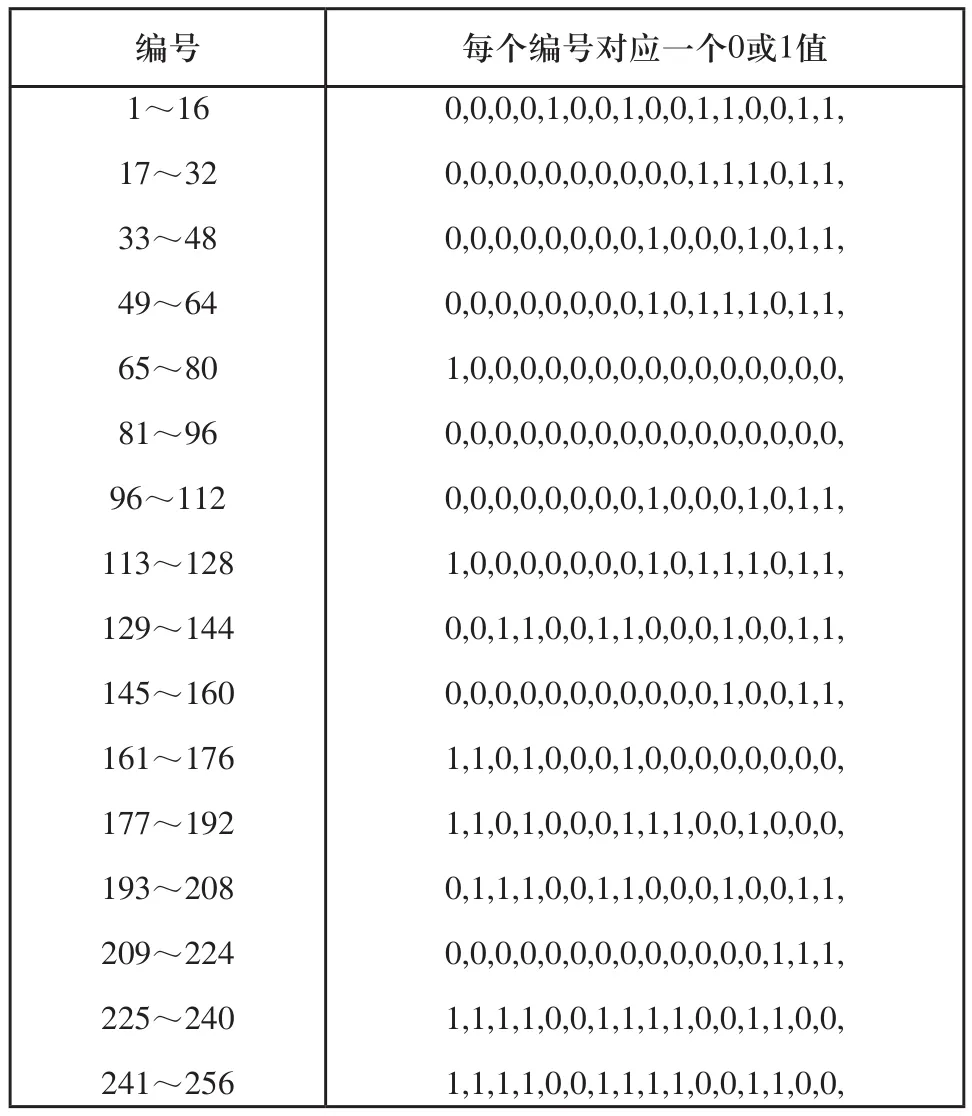

圖像細化是針對二值圖像的細化,對于640×480的二值圖像,1代表待細化的像素點區域,0代表背景。對邊界點P及其八鄰域點P0,P1,…,P6,P7,如圖6所示。

圖6 細化規則

對于邊界點P,判斷P0到P7所對應的像素值,計算八個鄰域點的權值S,對S值查表1的編號,若編號對應的值為1,則可以判斷P為可刪除點。

式中:Pk表示第k個鄰域點的像素值;k表示第幾個鄰域點。

通過上述方法對人體前臂及拆卸工具的二值圖像進行細化,如圖7所示。

圖7 細化示意圖

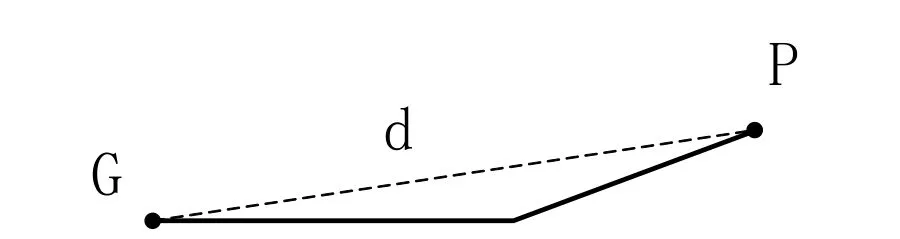

2.3 提取拆卸工具頂端三維坐標

對于細化后的圖像,獲取曲線上點的坐標。利用Kinect的關節跟蹤,可以提取出肘關節G點的坐標為(x,y),計算G點與曲線上其他點的歐式距離d,則歐式距離d最大值所對應的點P為拆卸工具頂點,其坐標為(x',y'),如圖8所示。

表1 索引表

圖8 尋找頂端示意圖

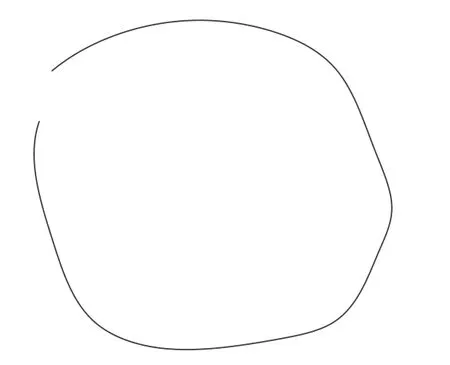

2.4 獲取拆卸工具軌跡

人拿拆卸工具進行運動(以圓為例),在運動的整個過程中,利用Kinect提取一系列深度圖像,對每一幅深度圖像進行2.2~2.3節的操作,獲得拆卸工具頂端的位置,提取軌跡特征,如圖9所示的是一個近似圓形的工具軌跡。

圖9 軌跡模型

2.5 軌跡預處理及量化編碼

1)對軌跡進行預處理

樣本數據里存在干擾點,所以提出利用歐式距離和隨機抽樣一致性對樣本進行預處理。

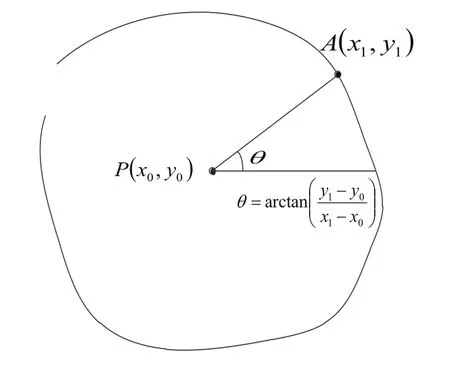

對于獲取的軌跡特征點的數據集合Q,計算其重心點P(x0,y0)。

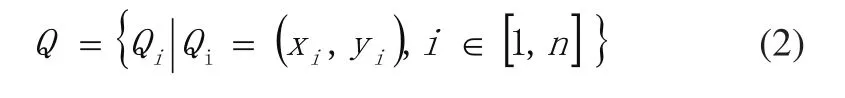

軌跡特征點集合可表示為:

式中:Qi表示(xi,yi)處的位置坐標;n表示特征點數目。

重心點坐標可表示為:

式中:xi表示點的橫坐標;yi表示點的縱坐標。

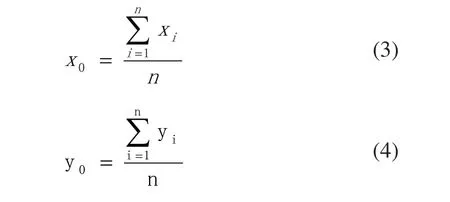

計算每個樣本里點到重心P(x0,y0)的歐式距離d,若則將d〉T所對應的點剔除;若對式(1)樣本,利用隨機抽樣一致性算法擬合成一條直線L,提取集合Q中每一點到直線L的距離d',將d'〉T'所對應的點剔除,圖10給出剔除干擾點示意圖。

圖10 干擾點剔除示意圖

如圖10所示,左圖A點離重心P(x0,y0)的歐式距離太大,作為剔除點;右圖B點離擬合的直線的歐式距離太大,作為剔除點。

2)對軌跡進行量化編碼

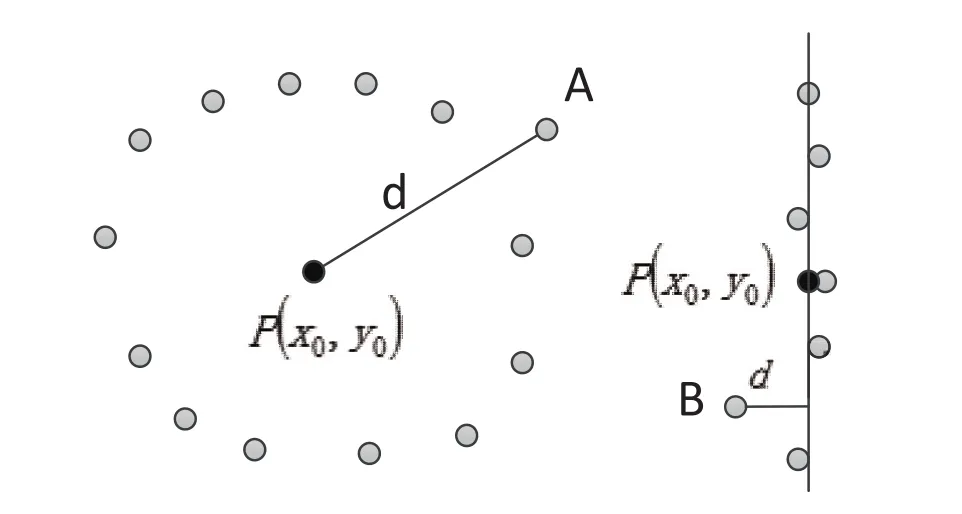

為了便于對軌跡進行識別,需要對軌跡進行量化編碼。對于提取的軌跡,將其深度值Z去掉,以便于量化編碼,圖11給出求取角度的方向矢量圖。

如圖11所示,P(x0,y0)是軌跡曲線的重心,對于軌跡曲線上任意點A(x1,y1),通過幾何關系,求出A點所在的角度值θ,其中:

圖11 方向矢量圖

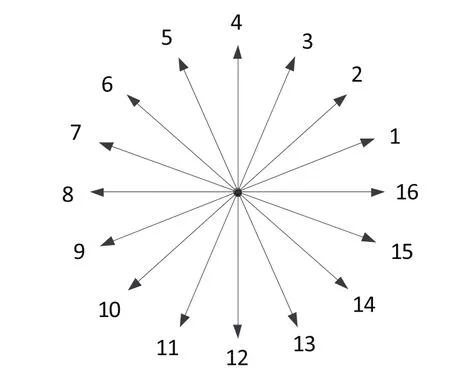

從軌跡曲線上得到一系列角度值,采用16方向鏈碼進行角度量化編碼,圖12給出里夾角量化編碼示意圖。

圖12 夾角量化編碼

如圖12所示,軌跡上每個點都對應一個角度值,根據對應關系將角度值轉化為1到16的碼值,通過碼值對軌跡進行識別。

3 軌跡識別

3.1 HMM模型

隱馬爾科夫模型(Hidden Markov Model, HMM)[9,10]是用于描述隨機過程統計特性的概率模型[11],可以用來描述含有隱含未知參數的馬爾科夫過程。首先通過可觀察的參數中確定該過程的隱含參數;然后利用這些參數進行模式識別[12]等。

HMM用5個元素來描述,包括兩個狀態和三個狀態概率矩陣。

1)隱藏狀態數目N。

3.2 HMM參數估計

利用HMM對軌跡識別之前,需要對HMM參數進行估計。前向-后向算法(Baum-Welch算法)可以解決隱馬爾科夫模型參數估計問題。

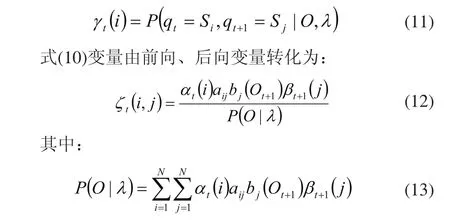

給定觀察序列O及隱馬爾科夫模型λ,定義t時刻位于隱藏狀態Si的概率變量為:

給定觀察序列O及隱馬爾科夫模型λ,定義t時刻位于隱藏狀態Si及t+1時刻位于隱藏狀態Sj的概率變量為:

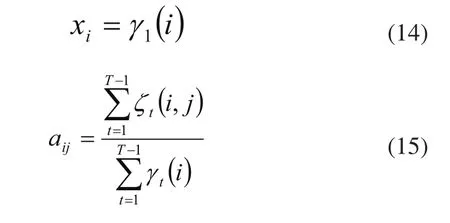

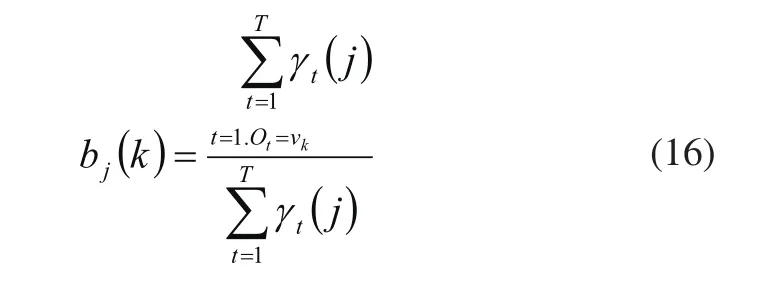

對多組角度量化編碼,進行迭代提取γ和ζ,用這兩個變量對HMM模型參數進行重新估計:

3.3 軌跡識別

4 實驗

4.1 提取拆卸工具軌跡

本文以螺絲刀為研究對象進行了拆卸工具的軌跡提取。利用Kinect獲取前臂及螺絲刀的深度圖,且提取出右肘所在的深度圖像坐標,圖13給出提取的前臂及螺絲刀深度圖,圖14給出了細化后的輪廓圖。

圖13 前臂及拆卸工具提取

圖14 前臂及拆卸工具圖像細化

如圖14所示,利用Kinect的骨骼跟蹤提取右肘圖像坐標,計算出離右肘最遠的點作為螺絲刀頂端所在的圖像坐標。最后通過Kinect SDK開發工具包將圖像坐標轉換為三維點云坐標。

拆卸工具運動時記錄下不同時刻其三維坐標則提取出拆卸工具頂端的運動軌跡。

4.2 軌跡識別

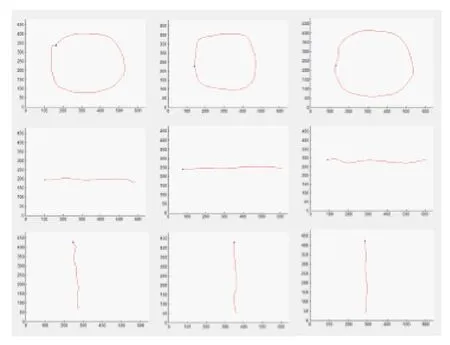

本文設計了三種軌跡類型來進行識別,有圓形軌跡、垂直運動軌跡和水平運動軌跡,典型的軌跡樣本如圖15所示。本研究對預處理前后的樣本利用HMM算法對三種軌跡進行識別實驗。

圖15 三種軌跡圖

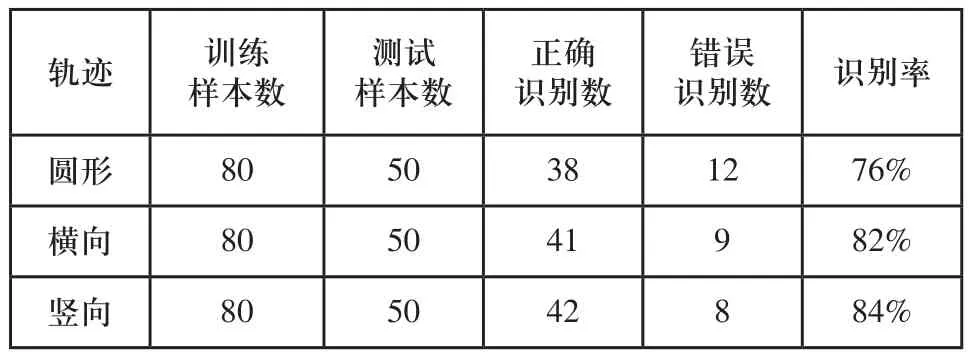

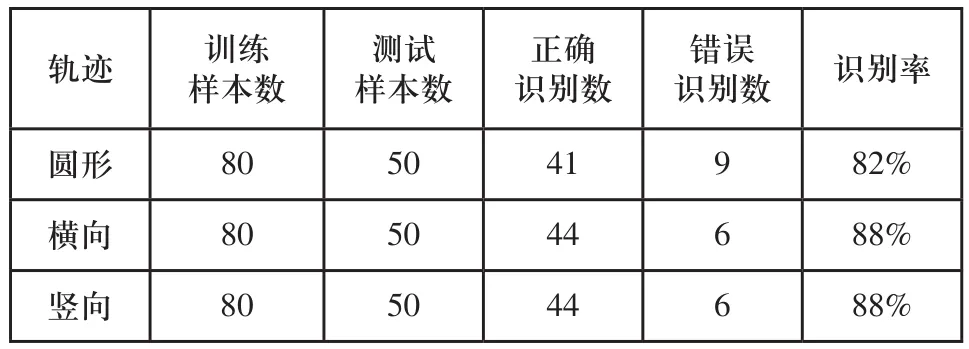

經過實驗與分析,各閾值參數確定為:T1=60,T2=300,T'=20。本研究對每種軌跡類型分別用80組樣本進行訓練。表2和表3分別為通過實驗分析得到原HMM算法和對樣本預處理后的軌跡識別率。

通過實驗分析可知:對樣本預處理后的識別率比沒有預處理的提高了6個百分點,驗證了本文對樣本預處理后用HMM算法能提高識別率。

表2 原HMM算法對三種軌跡的識別率

表3 樣本預處理后的識別率

5 結論

本文研究了利用Kinect獲取的深度圖像對人手拆卸工具進行軌跡識別。從深度圖像出發,結合圖像細化獲得拆卸工具頂端位置,提取軌跡特征,進而提取一種基于歐式距離和隨機抽樣一致性的樣本軌跡預處理方法;然后利用隱馬爾科夫算法訓練軌跡樣本并實現軌跡的識別。試驗結果表明樣本預處理后的識別率比未作預處理的識別率有了明顯提高。

[1] Biswas K K ,Basu S K. Gesture recognition using Microsoft Kinect[A].5th Internation Conference on Automation,Robotics and Application[C].IEEE,2011:100-103.

[2] Shotton J, Sharp T, Kipman A, et al. Real-time human pose recognition in parts from single depth images[J].Communications of the ACM,2013,56(1):116-124.

[3] Le T L, Nguyen M Q,Nguyen T T M,Human posture recognition using human skeleton provided by Kinect[A]. International Conference on Computing, Management and Telecommunications[C].IEEE,2013:340-345.

[4] 田國會,尹建芹,韓旭,等.一種基于關節點信息的人體行為識別新方法[J].機器人,2014,36(3):285-292.

[5] Microsoft Kinect Tear down(iFixit,4 November 2010).[EB/ OL].http://www.ifixit.com/Teardown/Microsoft_Kinect_ Teardown/4066/1.

[6] MEENAKSHI P.Hand gesture recognition based on shape parameters[A].Computing, Communication and Application(ICCCA), 2012 International Conference[C],2012.

[7] SILANON K, SUVONVORN N. Hand motion analysis for Thai alphabet recognition using HMM[J].International Journal of Information and Electronics Engineering,2011,1(1):65-71.

[8] Tian Jie Chen Xinjian,Zhang Yangyang et al. Recent progress on finger print identification technologies[J].Progress in Natural Science.2006,16(4):400-406.

[9] Marcinczuk M,Piasecki M. Study on named entity recognition for polish based on hidden Markov models[A].Proceedings of Text,Speech and Dialogue-13th International Conference(TSD 2010)[C],2010:142-149.

[10] 吳曉娟,張博洋,張楨,等.基于HMM動態手勢軌跡識別的門限模型研究方法[J].模式識別與人工智能.2003,16(1):122-125.

[11] RABINER R,JUANG H.An introduction to HMMs[J].IEEE ASSP Magazine,1986,3:4-16.

[12] Wu Haitao,Pan Wei, Xiong Xingyu,et al.Human activity recognition based on the combined SVM & HMM[A].Proceedings of 2014 IEEE International Conference on Information and Automation[C].Hailar:IEEE,2014:219-224.

Recognition of removal tool trajectory based on kinect

ZHANG Zhi-jia1,2, WEI Xin1,2, ZHOU Zi-qiang2, LIU Zheng3

TP391.4

A

1009-0134(2016)12-0140-06

2016-11-24

江蘇省機電產品循環利用技術重點建設實驗室基金(KF1508);國家自然科學基金(61540069)

張志佳(1974 -),男,副教授,博士,研究方向為機器視覺檢測技術、圖像處理與模式識別。