特斯拉命案誰之過?

Felix

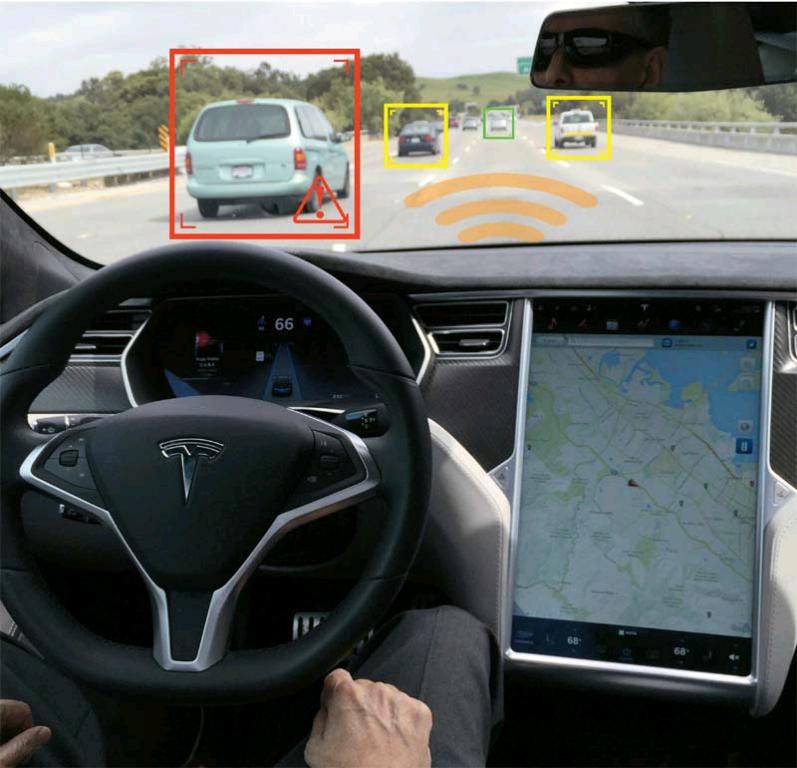

特斯拉最近又成焦點,不是因為又有什么黑科技,而是它的Model S出車禍了。在美國佛羅里達州的一條公路上,40歲的俄亥俄州居民Joshua D. Brown駕駛的特斯拉Model S在自動駕駛模式下,撞上了前方轉(zhuǎn)彎的一輛大掛車。這也是全球第一例與自動駕駛有關(guān)的致命事故。

據(jù)美國國家公路交通安全管理局(NHTSA)的數(shù)據(jù),美國每年因車輛事故致命的人數(shù)接近4萬,各種交通事故中人為犯錯導(dǎo)致的事件比例超過90%。特斯拉的官方聲明稱,相比起全美所有交通工具每9400萬英里造成一例死亡事故,這起事故之前它的自動駕駛功能已經(jīng)覆蓋了1.3億英里。言下之意,自動駕駛還是比人工駕駛安全。只不過在積累更多實際數(shù)據(jù)之前,自動駕駛的安全性更多還是依賴于系統(tǒng)模擬。公眾對這個創(chuàng)新的期待如此之大,以至于一點風(fēng)吹草動都能引發(fā)關(guān)注(比如,谷歌的自動駕駛汽車蹭上公交車),更別說碰撞致死的嚴(yán)重事故了。

同樣是推動自動駕駛,谷歌和特斯拉的做法其實是有差別的。特斯拉的Autopilot,嚴(yán)格來說是一種輔助駕駛系統(tǒng),它通過收集人的駕駛數(shù)據(jù),學(xué)會在一定條件下自行變道和剎車。但在整個行使過程中,駕駛員必須一直手扶方向盤,以便隨時介入。但在谷歌看來,讓駕駛員介入自動駕駛系統(tǒng),就像是給出租車上的乘客加裝方向盤一樣不合理。谷歌要做的是全自動駕駛,為了不給人犯錯的機會,谷歌的自動駕駛汽車不會再有方向盤、油門和剎車。

作為監(jiān)管機構(gòu),NHTSA給自動駕駛劃分了5個級別,從低到高分別是:非自動(Level 0)、特定功能自動化(Level 1)、組合功能自動化(Level 2)、有限的自動駕駛(Level 3)、全自動駕駛(Level 4)。特斯拉的Autopilot算是居于Level 2和Level 3之間,行駛操控還處在從人到機器的過渡階段。在一些場景下,Autopilot可以代替人完成如行駛居中、自行變道、自動加減速等操作,但特斯拉依然要求駕駛員時刻準(zhǔn)備接管,這里面既有對安全的顧慮,也有對事故責(zé)任的規(guī)避。

沒有交通事故,沒有人員傷亡,這是自動駕駛描繪的理想出行。但技術(shù)遠非我們想象的那樣完美,再精密的儀器也會生產(chǎn)出次品。自動駕駛汽車不可避免會卷入事故當(dāng)中,如何在事故中盡可能減少傷亡,已經(jīng)不單單是技術(shù)問題了。

《科學(xué)》雜志的一篇最新研究反映了自動駕駛正面臨的倫理兩難。舉個具體的例子,當(dāng)一輛僅有一名乘客的自動駕駛汽車沖向10位行人,人們通常都支持車輛避開行人,撞向路邊。但當(dāng)人們被問到自己是否會乘坐按照這個程序設(shè)定的車輛時,他們都拒絕了。研究人員之一,MIT的教授Iyad Rahwan認(rèn)為,這個研究表明,絕大多數(shù)人希望生活在一個車輛能最小化傷亡的世界,但每一個人又希望自己的車輛會不惜代價保護自己。