基于卷積神經網絡的人臉識別方法

陳耀丹,王連明

(東北師范大學物理學院,吉林 長春 130024)

基于卷積神經網絡的人臉識別方法

陳耀丹,王連明

(東北師范大學物理學院,吉林 長春 130024)

[摘要]研究并實現了一種基于卷積神經網絡的人臉識別方法.該網絡由2個卷積層、2個池化層、1個全連接層和1個Softmax回歸層組成,它能自動提取人臉特征并進行分類.網絡通過批量梯度下降法訓練特征提取器和分類器,各隱層應用“dropout”方法解決了過擬合問題.應用于ORL和AR人臉數據庫的人臉識別率分別達到99.50%和99.62%,識別單張人臉的時間均小于0.05 s,而且對光照差異、面部表情變化、有無遮擋物等干擾具有魯棒性.

[關鍵詞]人臉識別;卷積神經網絡;圖像處理;人臉數據庫

0引言

人臉識別作為生物特征識別(虹膜識別、指紋識別、掌紋識別等)技術之一,由于具有成本低、用戶易接受、可靠性高等優點,在身份認證、安防監控、人機交互等領域具有廣泛的應用前景.[1]目前人臉識別算法大致可分為兩類:

(1)基于表象(appearance-based)的方法.基本思想是將二維的人臉輸入轉換到另一個空間,然后用統計方法分析人臉模式,例如eigenface[2]、fisherface[3]和SVM[4]等方法.

(2)基于特征(feature-based)的方法.一般是提取局部或者全局特征,然后送入一個分類器進行人臉識別,例如基于幾何特征的識別[5]和HMM[6]等方法.

卷積神經網絡是一個受生物視覺啟發、以最簡化預處理操作為目的的多層感知器的變形,本質是一個前向反饋神經網絡.卷積神經網絡與多層感知器的最大區別是網絡前幾層由卷積層和池化層交替級聯組成,模擬視覺皮層中用于高層次特征提取的簡單細胞和復雜細胞交替級聯結構.卷積層的神經元對前一層輸入的一部分區域(稱為局部感受野,區域之間有重疊)有響應,提取輸入的更高層次特征;池化層的神經元對前一層輸入的一部分區域(區域之間無重疊)求平均值或者最大值,抵抗輸入的輕微形變或者位移.卷積神經網絡的后幾層一般是若干個全連接層和一個分類器構成的輸出層.近年來,卷積神經網絡已經成功應用于字符識別[7]、人臉識別[8]、人體姿態估計[9]和目標檢測[10].

卷積神經網絡用于人臉識別是一種基于特征的方法.區別于傳統的人工特征提取和針對特征的高性能分類器設計,它的優點是通過逐層卷積降維進行特征提取,然后經過多層非線性映射,使網絡可以從未經特殊預處理的訓練樣本中,自動學習形成適合該識別任務的特征提取器和分類器.該方法降低了對訓練樣本的要求,而且網絡層數越多,學習到的特征更具有全局性.

LeNet-5[11]是LeCun提出的一個具有高識別率的用于手寫數字識別的卷積神經網絡.本文借鑒LeNet-5的模型結構,提出6層卷積神經網絡用于ORL人臉庫和AR人臉庫的人臉識別.網絡前4層由卷積層和池化層交替級聯用于特征提取,隨后接入一個全連接層,最后一層采用非線性分類能力強的Softmax分類器.該6層卷積神經網絡采用sigmoid激活函數和固定的學習速率.

16層卷積神經網絡模型

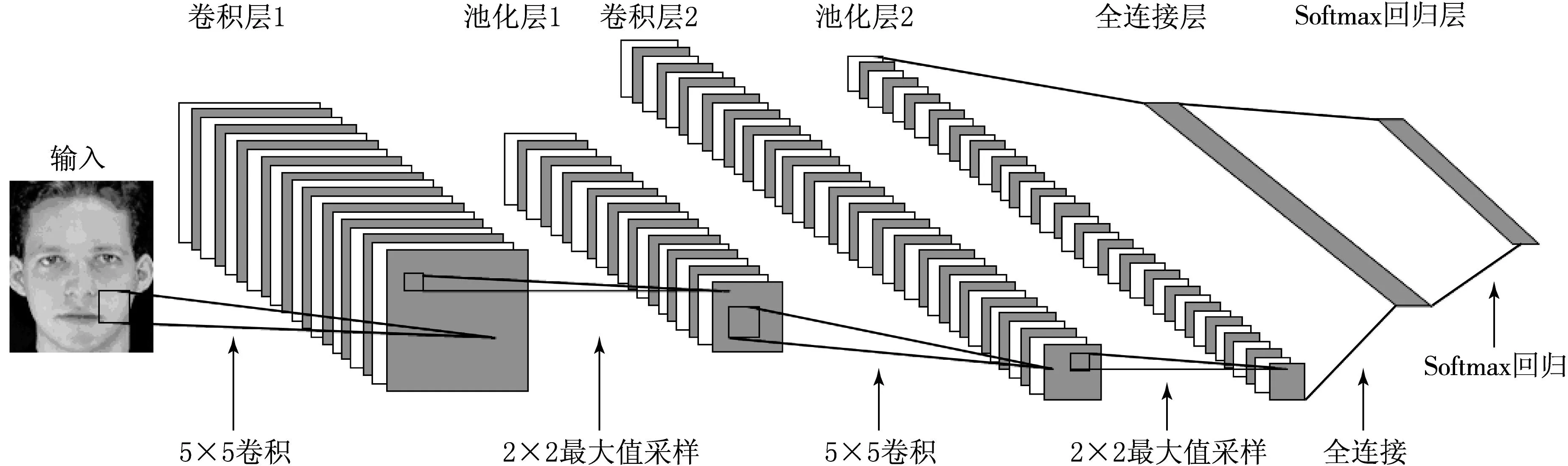

本文提出的6層卷積神經網絡模型由2個卷積層、2個池化層、1個全連接層和1個Softmax回歸層組成,如圖1所示.卷積層和池化層由多個特征圖(即二維平面)組成,每個特征圖由多個神經元組成,每一層的特征圖作為下一層的輸入.卷積層的特征圖可能與前一層的若干特征圖建立關系.

圖1 6層卷積神經網絡模型

1.1卷積層

卷積層通過局部連接和權值共享的方法,模擬具有局部感受野的簡單細胞,提取一些初級視覺特征的過程.局部連接指卷積層上的每個神經元與前一層特征圖中固定區域的神經元建立連接;權值共享指同一特征圖中的神經元用一組相同的連接強度與前一層局部連接,可以減少網絡訓練參數.上述一組相同的連接強度即為一個特征提取器,在運算過程中表現為一個卷積核,卷積核數值先隨機初始化,最后由網絡訓練確定.

與LeNet-5相比,考慮到人臉識別比數字識別更復雜,卷積層為了更充分地提取人臉特征進行了以下改進:(1)增加2個卷積層的特征提取器——卷積核的數量;(2)卷積層2的特征圖與池化層1的全部特征圖均建立關系.

卷積層每個神經元的輸入來自于前一層特征圖中固定區域的神經元,區域的大小由卷積核大小Kx×Ky決定.卷積層1的m張特征圖由1張輸入圖片跟m個可學習的卷積核卷積,加上偏置后,通過激活函數作用得到.卷積層2的n張特征圖,由池化層1的m張特征圖分別跟n×m個卷積核卷積,每m個卷積結果結合,再加上偏置,通過激活函數作用得到.卷積層操作如圖2所示.

圖2 卷積層操作

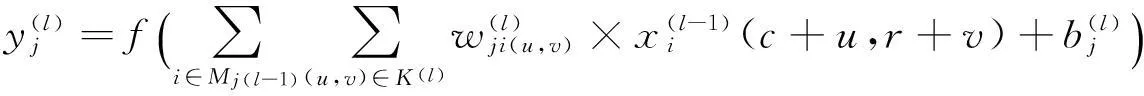

該層的數學表達式[8]為

(1)

1.2池化層

池化層模擬復雜細胞是將初級的視覺特征篩選并結合成更高級、抽象的視覺特征的過程,在網絡中通過采樣實現.經過池化層的采樣后,輸出特征圖的數量不變,但是特征圖的尺寸會變小,有減少計算復雜度、抵抗微小位移變化的作用.本文提出的池化層采用最大值采樣,采樣大小為2×2,即把輸入的特征圖分割成不重疊的2×2大小的矩形,對每個矩形取最大值,所以輸出特征圖的長和寬均是輸入特征圖的一半.本文定義池化層中的神經元不具備學習功能,數學表達式為

(2)

其中down表示最大值采樣的函數,該層運算不包含可學習的權值和閾值.

1.3全連接層

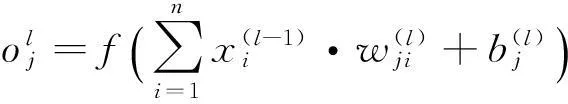

為增強網絡的非線性映射能力,同時限制網絡規模的大小,網絡在4個特征提取層提取特征后,接入一個全連接層.該層的每一個神經元與前一層的所有神經元互相連接,同層神經元之間不連接.數學表達式[8]為

(3)

1.4Softmax回歸層

LeNet-5最后一層是RBF分類器,采用由ASCII碼表中的數字作為模板算出的糾錯碼或者以等概率的方式任選-1和1作為RBF的權值,每個RBF輸出單元計算輸入特征和參數向量之間的歐式距離.但是人臉特征比數字特征更復雜,而且人臉類別多又沒有統一的模板,所以網絡最后一層采用非線性分類能力強的Softmax回歸作為分類器.

假定可分為k類的m個樣本組成訓練集{(x(L),y(L)),…,(x(m),y(m))},樣本x(i)∈Rn+1,類標y(i)∈{1,2,…,k},n是樣本維數,Softmax回歸假設函數[12]為

(4)

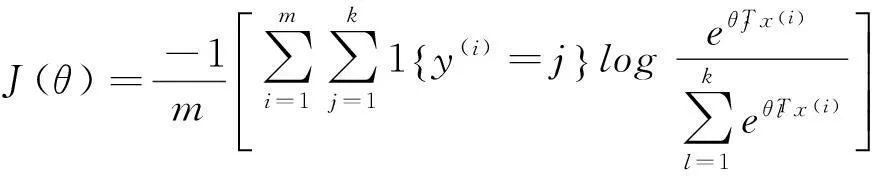

模型的代價函數為

(5)

其中:1{·}為示性函數,若{}內值為真的表達式,則示性函數值為1;反之,則為0.本文通過批量梯度下降法求解使代價函數J(θ)最小化時的θ.

2網絡訓練

2.1數據預處理

ORL人臉庫由40人的400張圖片組成,即每人10張圖片,人臉有表情、微小姿態等變化.取AR人臉庫的一個子集,由男、女各50人組成的2 600張圖片,即每人的圖片為26張,人臉有表情、遮擋、光照等變化.圖3是ORL人臉庫中人臉樣例,圖4是AR人臉庫中人臉樣例.

圖3 ORL人臉庫人臉樣例

圖4 AR人臉庫人臉樣例

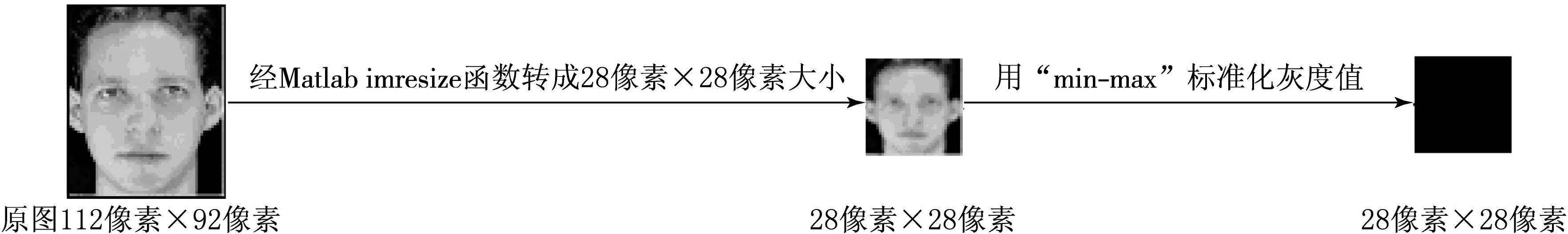

對2個數據庫同做以下處理:隨機抽取庫中90%的人臉作為訓練集,剩下的10%的人臉作為測試集,然后標準化2個集合中的人臉,如圖5所示.

圖5 人臉標準化過程

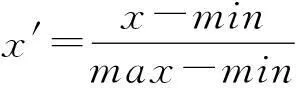

“min-max”標準化灰度值,即對圖片中每個像素點的灰度值標準化為[0,1].用x和x′分別表示當前和標準化后的灰度值,min和max分別表示圖片中的最小和最大的灰度值,標準化公式為

(6)

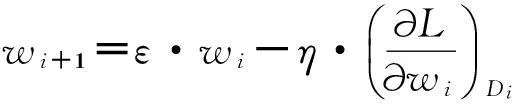

2.2網絡訓練算法

由于2個人臉庫訓練樣本較多,本文采用的是在實踐中收斂速度較快的批量隨機梯度下降法.對于ORL人臉庫的卷積神經網絡的訓練,批處理塊大小為40,動量為0.9,學習速率恒為0.12;對于AR人臉庫的卷積神經網絡的訓練,批處理塊大小為65,動量為0.9,學習速率恒為0.15.每次迭代會遍歷訓練集的所有批處理塊,遍歷完一個批處理塊更新一次網絡參數.更新公式為

(7)

本文用于ORL人臉庫的某個卷積神經網絡包含104.210×104個待訓練參數;用于AR人臉庫的某個卷積神經網絡包含150.266×104個待訓練參數.針對參數遠大于訓練樣本數量可能導致的過擬合問題,Hinton提出了“dropout”[13],即在網絡訓練時以一定的概率p(0≤p≤1)將輸入層或者隱層的神經元輸出置為0,被置為0的神經元不再參與網絡的前向傳播和誤差反向傳播,而在測試時,將該輸入層或者隱層的神經元輸出乘以p作為該層的輸出.由于每輸入一張圖片網絡中神經元隨機被置0,所以就要求隱層神經元必須提取圖片中最本質的特征,因此可以用“dropout”來解決過擬合問題.

3實驗結果

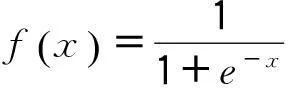

本文采用Windows XP下的Matlab 2010a作為實驗環境,計算機CPU為3.3 GHz的Intel i3-3220,內存為4 GB,2個卷積層中卷積核大小為5×5,2個采樣層采用最大值池化,采樣大小為2×2,激活函數采用sigmoid函數,即

(8)

網絡權值采用高斯初始化,網絡閾值初始化為0,網絡的代價函數J(θ)見公式(5),卷積層、全連接層和Softmax回歸層均采用“dropout”方法,概率p分別設為0.5,0.2和0.5.

6層卷積神經網絡模型可簡約描述為“A-b-c”,A表示卷積層1有A個卷積核,經過該層得到A張特征圖,再經過池化層1采樣得到縮小的A張特征圖;b表示卷積層2有b×A個卷積核,經過該層得到b張特征圖,再經過池化層2采樣得到縮小的b張特征圖;c表示全連接層的神經元個數.輸出層神經元個數是人臉庫的模式類個數.本文分別改變全連接層神經元個數c和2個卷積層的特征圖數量A和b,找到最適合2人臉庫的網絡模型.

3.1改變全連接層神經元個數對網絡的影響

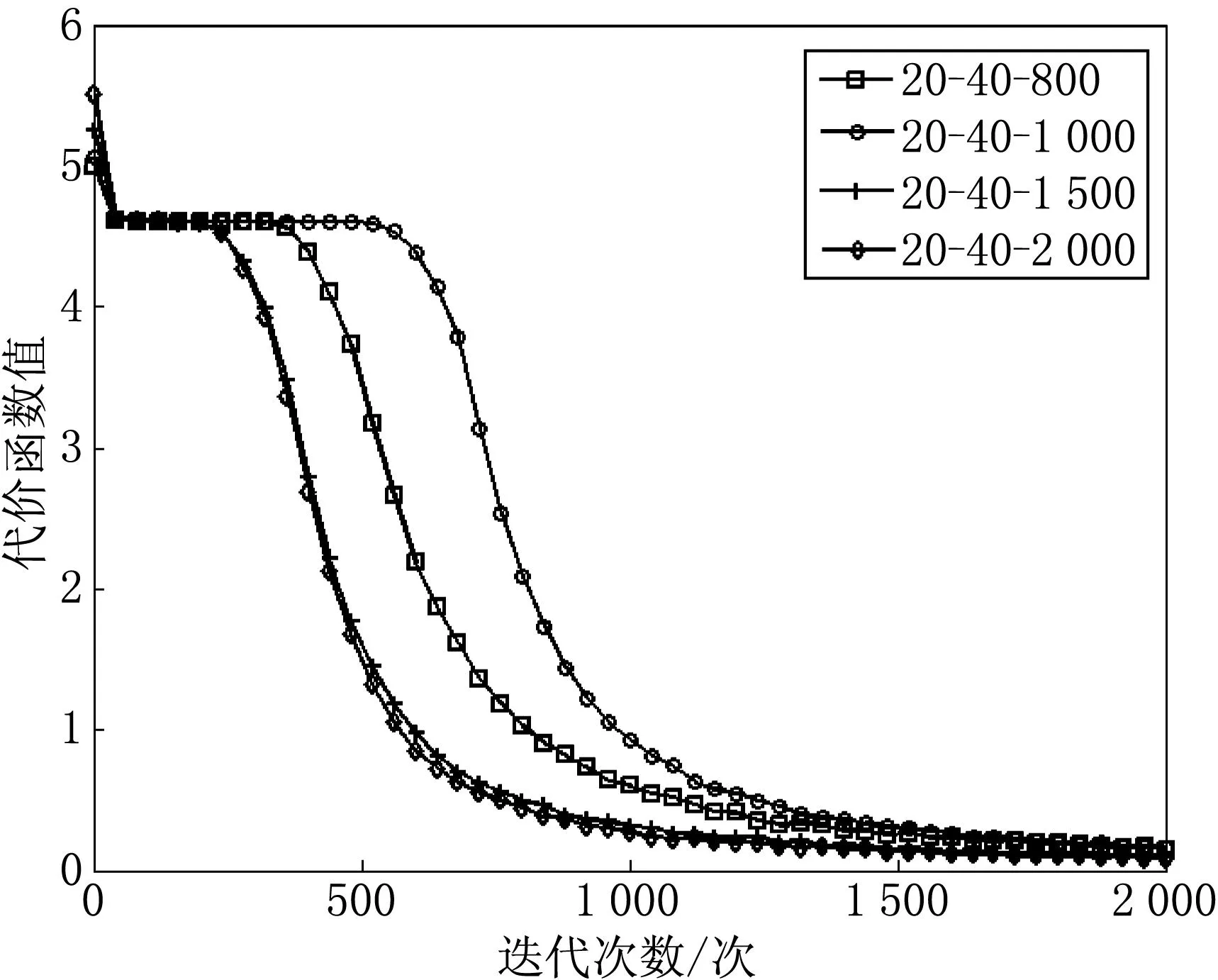

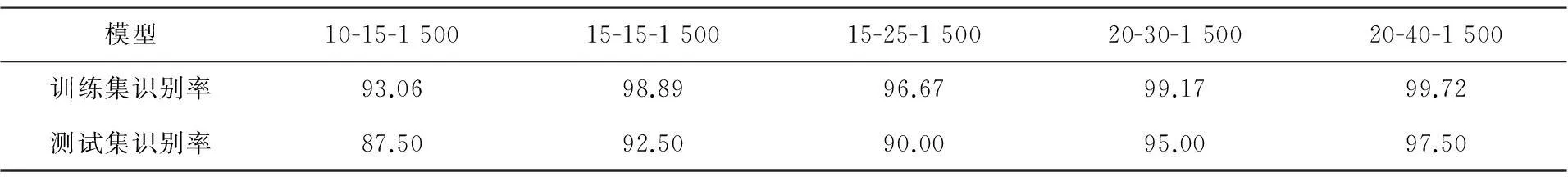

ORL人臉庫的6層卷積神經網絡用20-40-300,20-40-500,20-40-800,20-40-1 100,20-40-1 500模型測試.AR人臉庫的6層卷積神經網絡用20-40-800,20-40-1 000,20-40-1 500,20-40-2 000模型測試.

圖6描述ORL人臉庫中每次迭代對應的代價函數J(θ)的值,圖7描述AR人臉庫中每次迭代對應的代價函數J(θ)的值.圖6和7顯示各個網絡模型從迭代次數為1 900至2 000時基本訓練.選取迭代次數為2 000時,測量各個模型對于相應人臉庫訓練集和測試集的正確識別率,結果如表1和2所示.

圖6 改變全連接層的ORL人臉庫的J(θ)

圖7 改變全連接層的AR人臉庫的J(θ)

%

表2 改變全連接層的AR人臉庫的正確識別率 %

對于ORL人臉庫,最佳的卷積神經網絡模型為20-40-1 500;對于AR人臉庫,最佳的卷積神經網絡模型為20-40-2 000.增加全連接層神經元個數可以加快網絡的訓練速度,在一定程度內能提高正確識別率.

3.2改變2個卷積層特征圖數量對網絡的影響

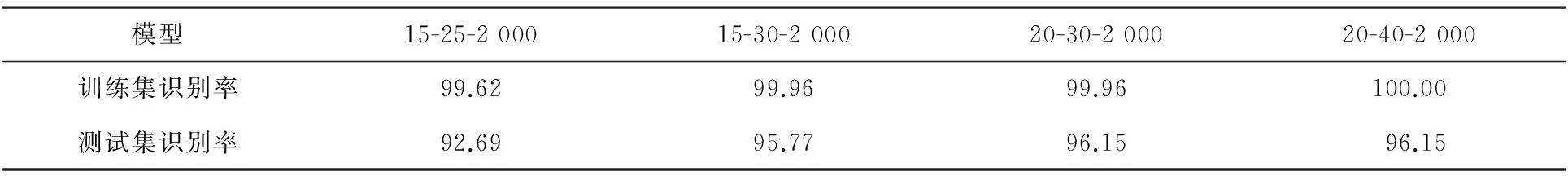

ORL人臉庫的6層卷積神經網絡用10-15-1 500,15-15-1 500,15-25-1 500, 20-30-1 500, 20-40-1 500模型測試.AR人臉庫的6層卷積神經網絡用15-25-2 000,15-30-2 000,20-30-2 000,20-40-2 000模型測試.

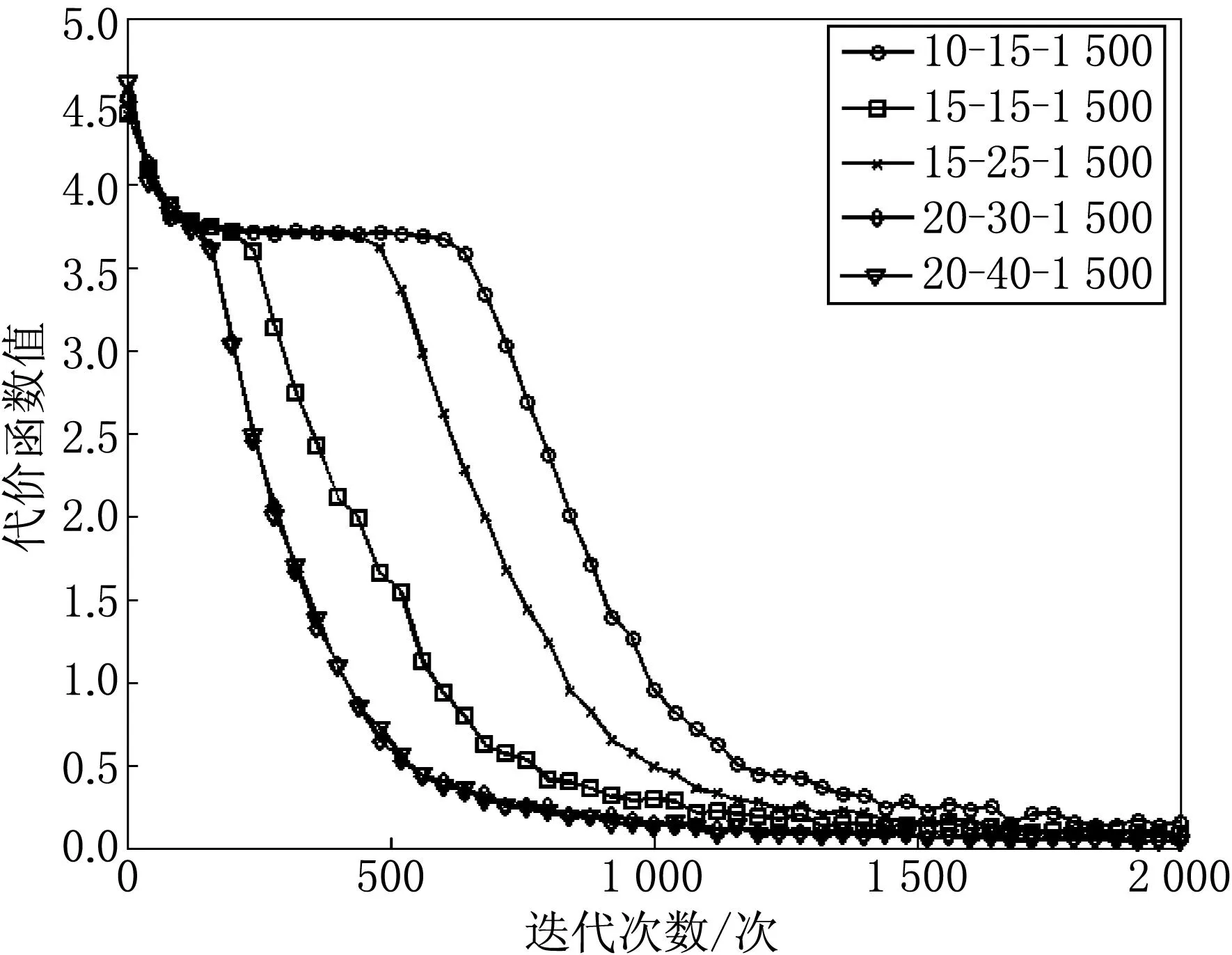

圖8描述ORL人臉庫中每次迭代對應的代價函數J(θ)的值,圖9描述AR人臉庫中每次迭代對應的代價函數J(θ)的值.同理,選取迭代次數為2 000時,測量各個模型對于相應人臉庫訓練集和測試集的正確識別率,結果如表3和4所示.

圖8 改變2個卷積層的ORL人臉庫的J(θ)

圖9 改變2個卷積層的AR人臉庫的J(θ)

%

表4 改變2個卷積層的AR人臉庫的正確識別率 %

對于ORL人臉庫,最佳的卷積神經網絡模型為20-40-1 500;對于AR人臉庫,最佳的卷積神經網絡模型為20-40-2 000.適當增加卷積層特征圖數量可以提高正確識別率.

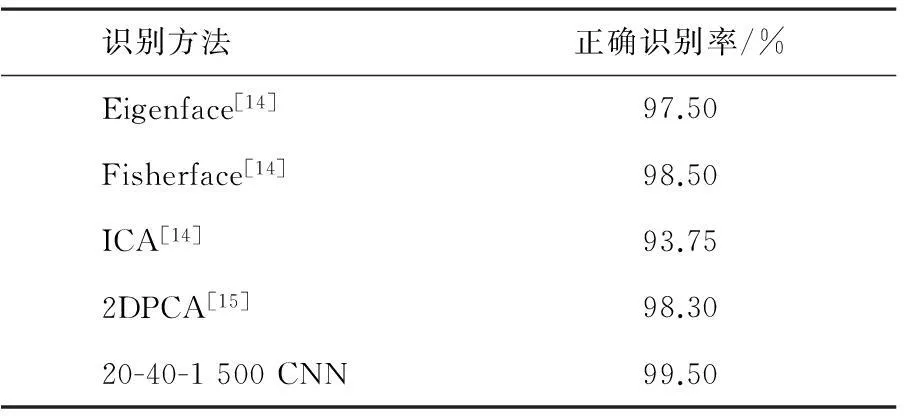

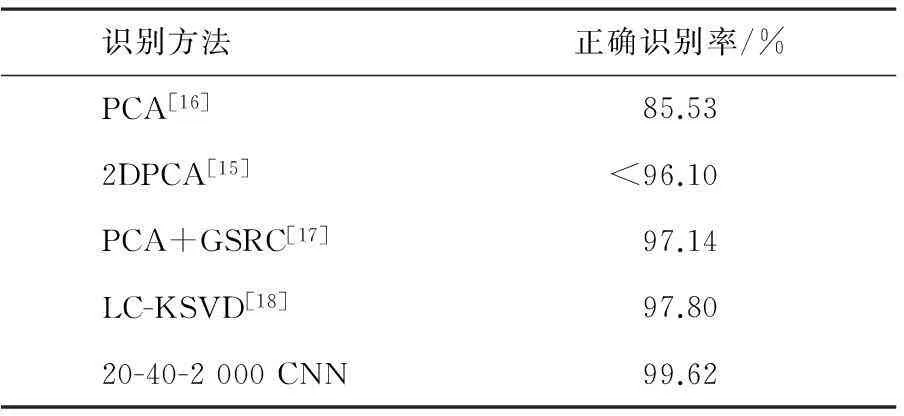

3.320-40-1 500卷積神經網絡模型與其他算法的比較

20-40-1 500的卷積神經網絡模型對ORL人臉庫全部樣本的識別率為99.50%, 20-40-2 000的卷積神經網絡模型對AR人臉庫全部樣本的識別率為99.62%.表5是本文提出的網絡與其他算法在ORL庫識別率的比較,表6是本文提出的網絡與其他算法在AR庫識別率的比較.可以看出本文提出的網絡在2個人臉庫上的識別率較好,并且網絡抵抗光照差異、面部表情變化、有無遮擋物等干擾的能力較強.

表520-40-1 500卷積神經網絡模型與用于ORL庫的其他算法比較

識別方法正確識別率/%Eigenface[14]97.50Fisherface[14]98.50ICA[14]93.752DPCA[15]98.3020-40-1500CNN99.50

表6 20-40-1 500卷積神經網絡模型與用于AR庫的其他算法比較

4總結

本文提出了一個6層卷積神經網絡用于ORL和AR人臉庫的人臉識別,對測試樣本的識別率分別為99.75%和96.15%,對全部樣本的識別率分別為99.50%和99.62%.用于AR人臉庫的卷積神經網絡對光照差異、面部表情變化、有無遮擋物等干擾具有魯棒性.采用Matlab 2010a作為實驗環境,在CPU為3.3 GHz的Intel i3-3220,內存為4 GB的計算機上,ORL和AR人臉庫的單張人臉識別時間均小于0.05 s,識別實時性好,為人臉識別提供一種新思路.

[參考文獻]

[1]陳海霞,崔茜.基于Gabor小波和PCA的人臉識別[J].東北師大學報(自然科學版),2014,46(4):77-80.

[2]孟繁靜,王連明.視頻人臉識別系統中的最佳人臉捕獲[J].東北師大學報(自然科學版),2015,47(3):90-95.

[3]WANG X,TANG X.Dual-space linear discriminant analysis for face recognition[C]//CVPR 2004 Proceedings of the 2004 IEEE Computer Society Conference on Computer Vision and Pattern Recognition.Washington:IEEE,2004,2:564-569.

[4]HEISELE B,HO P,POGGIO T.Face recognition with support vector machines:Global versus component-based approach[C]//ICCV 2001 Proceedings.Eighth IEEE International Conference on Computer Vision.Los Alamitos:IEEE,2001,2:688-694.

[5]ABATE A F,NAPPI M,RICCIO D,et al.2D and 3D face recognition a survey[J].Pattern Recognition Letters,2007,28(14):1885-1906.

[6]NEFIAN A V,HAYES III M H.Hidden markov models for face recognition[C]//1998 IEEE International Conference on Acoustics,Speed and Signal Processing,Washington:IEEE,1998:2721-2724.

[7]AHRANJANY S S,RAZZAZI F,GHASSEMIAN M H.A very high accuracy handwritten character recognition system for Farsi/Arabic digits using Convolutional Neural Networks[C]//Theories and Applications (BIC-TA),2010 IEEE Fifth International Conference on Bio-Inspired Computing.Beijing:IEEE,2010:1585-1592.

[8]SYAFEEZA A R,KHALIL-HANI M,LIEW S S,et al.Convolutional neural network for face recognition with pose and Illumination Variation[J].International Journal of Engineering & Technology,2014,6(1):44-57.

[9]TOSHEV A,SZEGEDY C.Deeppose:Human pose estimation via deep neural networks[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Los Alamitos:IEEE,2014:1653-1660.

[10]SERMANET P,EIGEN D,ZHANG X,et al.Overfeat integrated recognition,localization and detection using convolutional networks[J].Neural Networks,2003,16(5):555-559.

[11]LECUN Y,BOTTOU L,BENGIO Y,et al.Gradient-based learning applied to document recognition[J].Proceedings of the IEEE,1998,86(11):2278-2324.

[12]HUANG V S,SHADMEHR R,DIEDRICHSEN J.Active learning:learning a motor skill without a coach[J].Journal of neurophysiology,2008,100(2):879-887.

[13]SRIVASTAVA S,HINTION G,KRIZHEVSKY A,et al.Droput:a simple way to prevent neural networks from overfitting[J].The Journal of Machine Learning Reserch,2014,15(1):1929-1958.

[14]YANG M H.Kernel eigenfaces vs.kernel fisherfaces:Face recognition using kernel methods[C]//2013 10th IEEE International Conference and Workshops on Automatic Face and Gesture Recognition (FG).Washington:IEEE,2002:0215-0215.

[15]YANG J,ZHANG D,FRANGI A F,et al.Two-dimensional PCA:a new approach to appearance-based face representation and recognition[J].Pattern Analysis and Machine Intelligence,IEEE Transactions on,2004,26(1):131-137.

[16]ROLI F,MARCIALIS G L.Semi-supervised PCA-based face recognition using self-training[M].Structural,Syntactic,and Statistical Pattern Recognition.Berlin Heidelberg:Springer,2006:560-568.

[17]YANG M,ZHANG L.Gabor feature based sparse representation for face recognition with gabor occlusion dictionary[M].Computer Vision-ECCV 2010.Berlin Heidelberg:Springer,2010:448-461.

[18]JIANG Z,LIN Z,DAVIS L S.Learning a discriminative dictionary for sparse coding via label consistent K-SVD[C]//2011 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Washington:IEEE,2011:1697-1704.

(責任編輯:石紹慶)

Convolutional neural network for face recognition

CHEN Yao-dan,WANG Lian-ming

(School of Physics,Northeast Normal University,Changchun 130024,China)

Abstract:Feature extraction and classification are two key steps in face recognition.A convolutional neural network composed of two convolutional layers,two pooling layers,one full-connection layer and one Softmax regression layer for face recognition is proposed.The neural network can automatically extract facial features and classify face,with trained feature extractors and the classifier using batch gradient descent.And the network adopts dropout method in hidden layers to avoid the overfitting problem.Experimental results show that proposed network achieves 99.50% recognition accuracy on ORL database and an accuracy of 99.62% on AR database,and it can complete one-time facial recognition in less than 0.05s.More importantly,the network is robust to illumination variances,facial expressions and occlusions.

Keywords:face recognition;convolutional neural network;image processing;face database

[文章編號]1000-1832(2016)02-0070-07

[收稿日期]2015-05-17

[基金項目]國家自然科學基金資助項目(21227008);吉林省科技發展計劃項目(20130102028JC).

[作者簡介]陳耀丹(1993—),女,碩士研究生,主要從事模式識別研究;通訊作者:王連明(1972—),男,博士,教授,主要從事智能信息處理及嵌入式系統領域研究.

[中圖分類號]TP 391.4[學科代碼]520·2040

[文獻標志碼]A

[DOI]10.16163/j.cnki.22-1123/n.2016.02.016