大數據分析的無限深度神經網絡方法

張 蕾 章 毅

(四川大學計算機學院機器智能實驗室 成都 610065)

(leizhang@scu.edu.cn)

?

大數據分析的無限深度神經網絡方法

張蕾章毅

(四川大學計算機學院機器智能實驗室成都610065)

(leizhang@scu.edu.cn)

Big Data Analysis by Infinite Deep Neural Networks

Zhang Lei and Zhang Yi

(MachineIntelligenceLaboratory,CollegeofComputerScience,SichuanUniversity,Chengdu610065)

AbstractDeep neural networks (DNNs) and their learning algorithms are well known in the academic community and industry as the most successful methods for big data analysis. Compared with traditional methods, deep learning methods use data-driven and can extract features (knowledge) automatically from data. Deep learning methods have significant advantages in analyzing unstructured, unknown and varied model and cross field big data. At present, the most widely used deep neural networks in big data analysis are feedforward neural networks (FNNs). They work well in extracting the correlation from static data and suiting for data application scenarios based on classification. But limited by its intrinsic structure, the ability of feedforward neural networks to extract time sequence features is weak. Infinite deep neural networks, i.e. recurrent neural networks (RNNs) are dynamical systems essentially. Their essential character is that the states of the networks change with time and couple the time parameter. Hence they are very suit for extracting time sequence features. It means that infinite deep neural networks can perform the prediction of big data. If extending recurrent structure of recurrent neural networks in the time dimension, the depth of networks can be infinite with time running, so they are called infinite deep neural networks. In this paper, we focus on the topology and some learning algorithms of infinite deep neural networks, and introduce some successful applications in speech recognition and image understanding.

Key wordsdeep neural networks (DNNs); infinite deep neural networks; feedforward neural networks (FNNs); recurrent neural networks (RNNs); big data

摘要深度神經網絡(deep neural networks, DNNs)及其學習算法,作為成功的大數據分析方法,已為學術界和工業界所熟知.與傳統方法相比,深度學習方法以數據驅動、能自動地從數據中提取特征(知識),對于分析非結構化、模式不明多變、跨領域的大數據具有顯著優勢.目前,在大數據分析中使用的深度神經網絡主要是前饋神經網絡(feedforward neural networks, FNNs),這種網絡擅長提取靜態數據的相關關系,適用于基于分類的數據應用場景.但是受到自身結構本質的限制,它提取數據時序特征的能力有限.無限深度神經網絡(infinite deep neural networks)是一種具有反饋連接的回復式神經網絡(recurrent neural networks, RNNs),本質上是一個動力學系統,網絡狀態隨時間演化是這種網絡的本質屬性,它耦合了“時間參數”,更加適用于提取數據的時序特征,從而進行大數據的預測.將這種網絡的反饋結構在時間維度展開,隨著時間的運行,這種網絡可以“無限深”,故稱之為無限深度神經網絡.重點介紹這種網絡的拓撲結構和若干學習算法及其在語音識別和圖像理解領域的成功實例.

關鍵詞深度神經網絡;無限深度神經網絡;前饋神經網絡;回復式神經網絡;大數據

自步入大數據時代伊始,大數據分析也應運而生.從數據源頭到最終獲得價值,大數據在信息系統中的生命周期一般經過“數據準備、數據存儲與管理、計算處理、數據分析和知識展現[1]”5個主要環節,其中數據分析環節需要從“體量巨大(volume)、增長迅速(velocity)、類型多樣(variety)”的大數據中發現規律、提取知識.只有經過了“數據分析”環節,才能獲得深入的、有價值的信息,大數據的第4V特性,也是它的最重要特性——價值(value)才能夠真正得以體現.因此大數據分析在大數據領域顯得尤為重要,是“從數據到信息”的決定性因素.

大數據的4V特性也給大數據分析帶來新的挑戰.全球數字數據量以每2年翻番的速度增長,今年內將達到8ZB,相當于1800萬個美國國會圖書館[2].從人手一部的智能手機到視頻監控攝像頭等傳感設備,時時刻刻都在不斷生成復雜的結構化數據和非結構化數據,且非結構化數據的增長速率比結構化數據更快.IDC2011年的調查中指出,在未來10年產生的數據中非結構化數據將占到90%.在人類全部數字化數據中,僅有一小部分數值型結構化數據得到了深入分析和挖掘,也就是傳統的數據挖掘領域.網頁索引、社交數據等半結構化數據在Google,Facebook等大型互聯網企業得到了一些淺層分析(如排序等).而占數據總量75%以上的文本、語音、圖片、視頻、社交網絡交互數據等非結構化數據還難以進行有效的分析[2].

傳統的數據分析方法,根據隨機采樣的先驗知識預先人工建立模型,然后依據既定模型進行分析.這種方法曾經有效,因為當時它的處理對象多是結構化、單一對象的小數據集[1].但在大數據環境中,它的固有弊端:依賴專家知識、無法遷移、精確性差等,已經凸顯到無法忽視的地步了.因為占大數據主要部分的非結構化數據,往往模式不明且多變,無法獲得先驗知識,很難建立顯式的數學模型,這就需要發展更加智能的數據挖掘技術.因此,大數據分析技術亟待在對非結構化數據分析方面取得突破,從海量、復雜、多源數據中提取有用的知識,這就是以深度學習、神經計算為代表的結合智能計算的大數據分析方法.

2006年,深度學習領域學術奠基人之一——加拿大多倫多大學Hinton教授,根據人腦認知過程的分層特性,提出增加人工神經網絡的層數和神經元數量,構建深度神經網絡(deep neural networks, DNNs),可獲得優異的特征學習能力,并在后續一系列的試驗中得以證實[3].這一事件引起學術界和工業界的高度關注,從此開啟了深度學習研究和大數據應用的浪潮.今天,這股浪潮已席卷全球,而且還在持續升溫.2014年12月在北京舉行的2014中國大數據技術大會(BDTC 2014)暨第二屆CCF大數據學術會議上,由中國計算機學會(CCF)大數據專家委員會和中關村大數據產業聯盟主編的《中國大數據技術與產業發展白皮書(2014)》中,對2015年度大數據發展進行了十大預測,其中,“結合智能計算的大數據分析成為熱點”位列十大預測之首.文中明確指出“大數據與神經計算、深度學習、語義計算以及人工智能其他相關技術結合,成為大數據分析領域的熱點”.

以深度學習為代表的神經計算方法,以數據驅動、能自動地從數據中提取特征(知識)[4],對于分析非結構化、模式不明多變、跨領域的大數據具有顯著優勢.深度學習的實質是通過構建具有很多隱層的機器學習模型和海量的訓練數據,學習更精準的特征,從而最終提高分類或預測的準確性.由于大數據的信息維度極為豐富,只有像深度神經計算模型這樣更復雜、表達力更強的模型,才能夠發掘數據中豐富的內在信息.因此,大數據分析需要深度學習.

1深度神經網絡

神經網絡隸屬于人工智能領域的連接主義學派,是一種應用類似于大腦神經突觸連接的結構進行信息處理的數學模型.20世紀50年代,第一代神經網絡——感知機誕生[5],能夠實現線性分類、聯想記憶等;20世紀80年代,多層感知機及其訓練算法——反向傳播算法(backpropagation, BP)[6],因為能夠解決線性不可分問題被廣泛研究和應用.但是當時較為低下的硬件計算能力和網絡訓練算法易陷入局部極小等問題,成為制約神經計算方法發展的瓶頸,直到2006年Hinton教授開創的“多層結構、逐層學習”的深度學習方法[3],才使得神經網絡的強大計算能力真正發揮出來,并在大數據的時代背景下成為大數據分析領域的一顆璀璨的明星.這種方法在語音識別、圖像識別、自然語言處理等方面,已經取得了突破性的成功,以驚人的速度和結果,不斷刷新著這些應用領域內的各種標志性紀錄[4].

目前,在大數據分析中使用的深度神經網絡主要是前饋神經網絡(feedforward neural networks, FNNs).顧名思義,數據在這種網絡中的流向是單向的:由第一層(輸入層)流入,通過逐層(隱層)傳遞和映射,從最后一層(輸出層)流出.網絡的深度,即神經網絡中神經元層次的數量.通過增加隱層的數量,各層以接力的方式進行原始數據的特征學習,本質上是在逼近原始數據與其特征之間非線性極強的映射關系.根據神經網絡的一致逼近原理(universal approximation theory)[7],對于任意一個非線性映射,一定能找到一個淺層網絡和一個深度網絡以任意精度逼近它,只要淺層網絡的隱層神經元個數足夠多或者深度網絡足夠深.但通常,較淺層網絡而言,深度網絡只需要少得多的參數就可以達到與之相同的逼近效果.

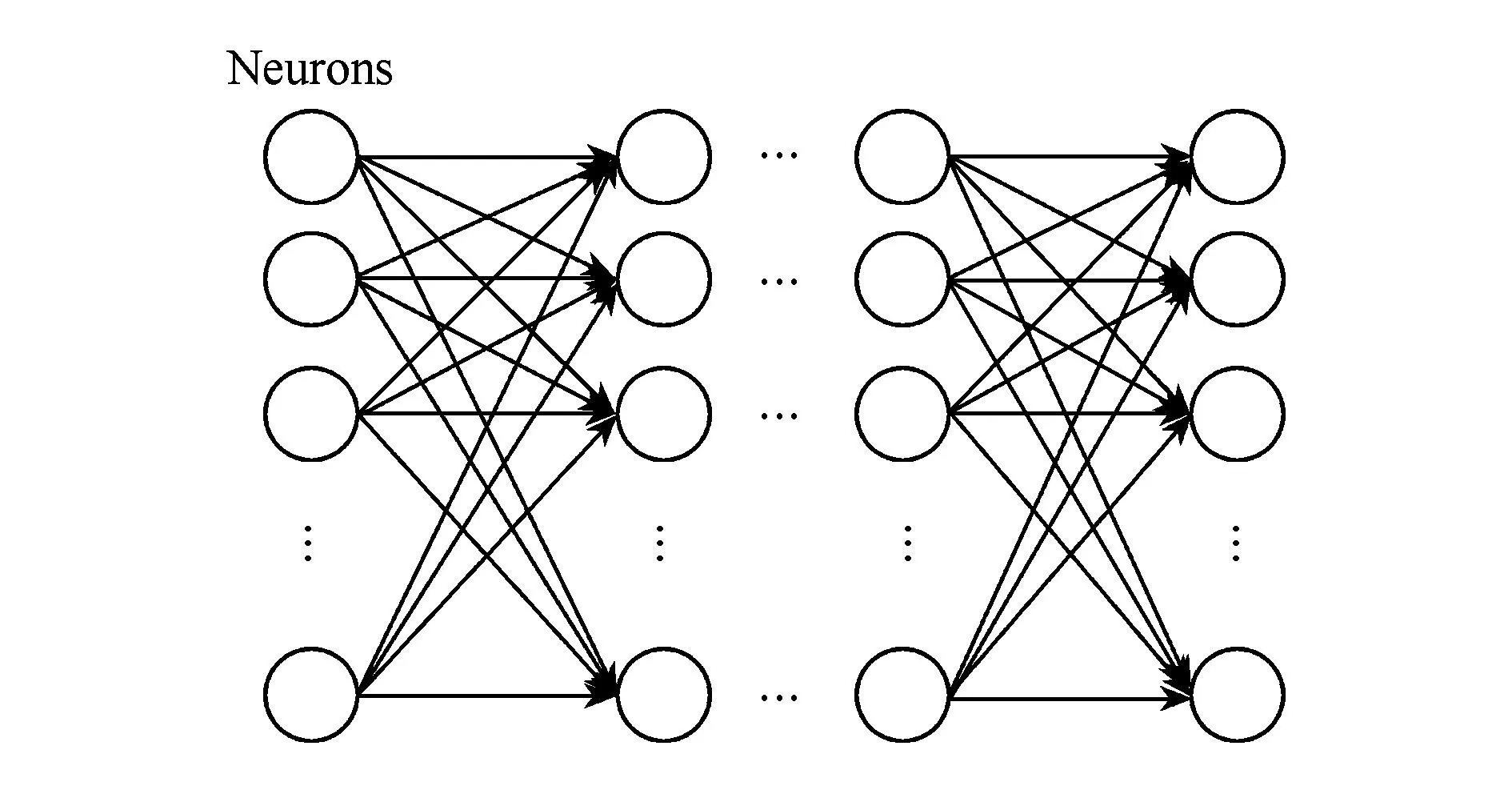

一般的深度FNNs的拓撲結構如圖1所示.當下應用最廣泛的自編碼網絡(autoencoder)和卷積神經網絡(convolution neural networks, CNNs)都屬于前饋網絡[8-9].

Fig. 1 The topology of deep feedforward neural network.圖1 深度前饋神經網絡拓撲結構圖

2無限深度神經網絡

目前,學術界和工業界所指的“深度神經網絡”,通常指具有一定深度的前饋網絡,前饋網絡的特點是同層神經元之間沒有反饋連接,沒有“時間參數”屬性,所以深度神經網絡擅長處理靜態數據.而“無限深度神經網絡(infinite deep neural networks, infinite DNNs)”,是一種全互連的回復式神經網絡(recurrent neural networks, RNNs),神經元之間存在反饋連接.將這種反饋結構在時間維度展開,隨著時間的不斷運行,網絡可以“無限深”,在這個意義下,我們稱回復式神經網絡為“無限深度網絡”.“無限深度神經網絡”和“回復式神經網絡”分別從2個不同的角度看待具有全互連結構的神經網絡模型.使用“無限深度神經網絡”名稱時,表明我們是從網絡計算的角度出發,著重研究網絡的學習和訓練方法;而采用“回復神經網絡”時,我們意在強調網絡中存在“反饋連接”,與不具有反饋連接的“前饋式網絡”有明顯區別.無限深度神經網絡本質上是一個動力學系統,能夠處理動態數據,即與時間相關的數據.

2.1網絡拓撲結構

對無限深度神經網絡中的每一個神經元而言,它的連接有3種:該神經元與所有的外部輸入的連接、與其他所有神經元的連接,以及該神經元與自身的反饋連接.圖2所示是一個具有3個神經元、2個外部輸入的無限深度神經網絡.

Fig. 2 Two structures of the completely connected RNN having three neurons and two inputs.圖2 具有3個神經元和2個外部輸入的無限深度神經網絡拓撲結構圖

一般地,假設一個無限深度網絡有m個外部輸入、n個神經元.令x(t)=(x1(t),x2(t),…,xm(t))T為網絡在時刻t的外部輸入,y(t)=(y1(t),y2(t),…,yn(t))T為時刻t的n個神經元的輸出.顯然,任意神經元k在時刻t+1獲得的總輸入sk(t+1)由x(t)和y(t)兩部分加權組成.設w為網絡的連接權值,是一個n×(n+m)的矩陣.不失一般性,可令w=[wU,wI],其中wU表示神經元之間的連接權值,wI表示神經元與網絡外部之間的連接權值,則時刻t+1網絡神經元獲得的總輸入為

(1)

其中,s(t+1)=(s1(t+1),s2(t+1),…,sn(t+1))T.而時刻t+1神經元k的輸出為

(2)

其中,fk是神經元k的激活函數.

Fig. 3 Unroll a recurrent neural network and get infinite deep neural network.圖3 將回復式神經網絡在時間維度展開形成“無限深度網絡”

為了便于分析,可以將無限深度網絡的反饋結構在時間維度展開.假設一個無限深度網絡N從時刻t0開始運行,每一個時間步網絡N被展開成一個前饋式網絡Ν*中的一層,網絡Ν*中的每一層都有n個神經元,且與這一時間步的網絡Ν具有完全相同的活動值.任一τ≥t0,網絡Ν中神經元(或外部輸入)j與神經元i之間的連接wi j被復制成網絡Ν*中τ層神經元(或外部輸入)j與τ+1層神經元i之間的連接wi j(τ+1),如圖3所示.隨著時間的不斷運行,Ν*的深度可以“無限深”,在這個意義下我們稱回復式神經網絡為“無限深度網絡”.

2.2與深度神經網絡的區別

深度神經網絡突出的特征學習能力使其特別擅長解決基于分類的各種識別問題,如語音識別、圖像識別等.近年來,深度學習方法獲得的各種標志性記錄,多是在這些方面.分類是大數據分析的其中一個目標,而另一個核心任務是對數據未來變化的預測,換句話說,就是提取數據的時序特征.但是由于深度神經網絡拓撲結構本身的限制,它提取動態數據時序特征的能力有限,可以通過“Bus Driver”問題為例說明這一點.

Fig. 4 Description of Bus Driver problem.圖4 Bus Driver問題描述

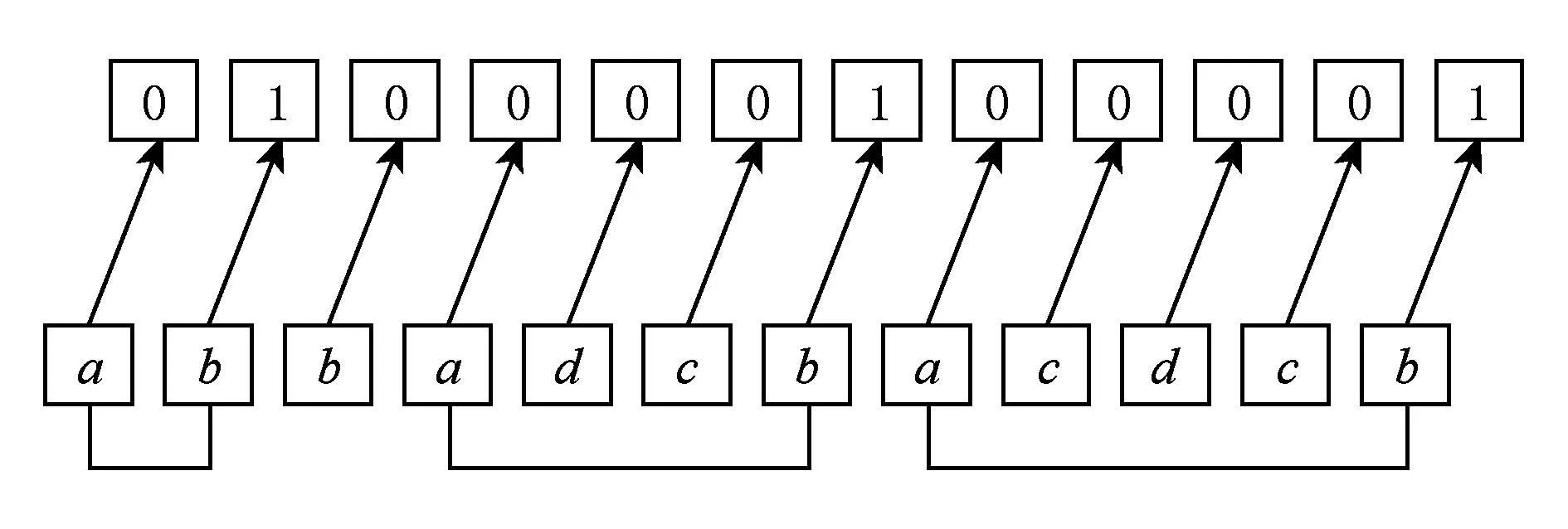

“Bus Driver”是一個序列識別問題.它要求網絡能夠識別按照特定順序發生的2個事件,無論中間的干擾事件有多少個.假設有a,b,c和d四個事件,一次輸入一個事件,如果事件a之后出現了第一個事件b,網絡就輸出1,否則就輸出0,如圖4所示.這個任務的難點在于事件a和a之后出現的第1個事件b之間的干擾事件的個數是不確定的,因此網絡必須要記住所有已經發生的事件.

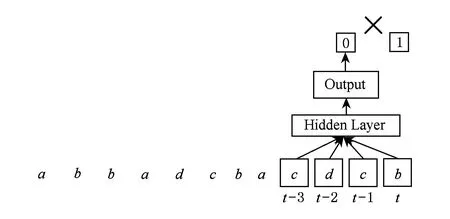

前饋神經網絡解決這個問題時,一般采用輸入端引入抽頭延遲線的方式,如圖5所示,抽頭延遲線以固定的窗口劃分輸入,當輸入包含指定的序列時就輸出1,否則輸出0,但是因為延遲線的長度是有限且固定的,而事件a和a之后的第1個事件b它們之間的延遲是不確定的.因此,對于干擾事件的個數大于延遲線長度的序列模式,網絡將無法正確識別,如圖6所示.

Fig. 5 Using a sliding window to determine the input.圖5 以固定的窗口劃分輸入序列

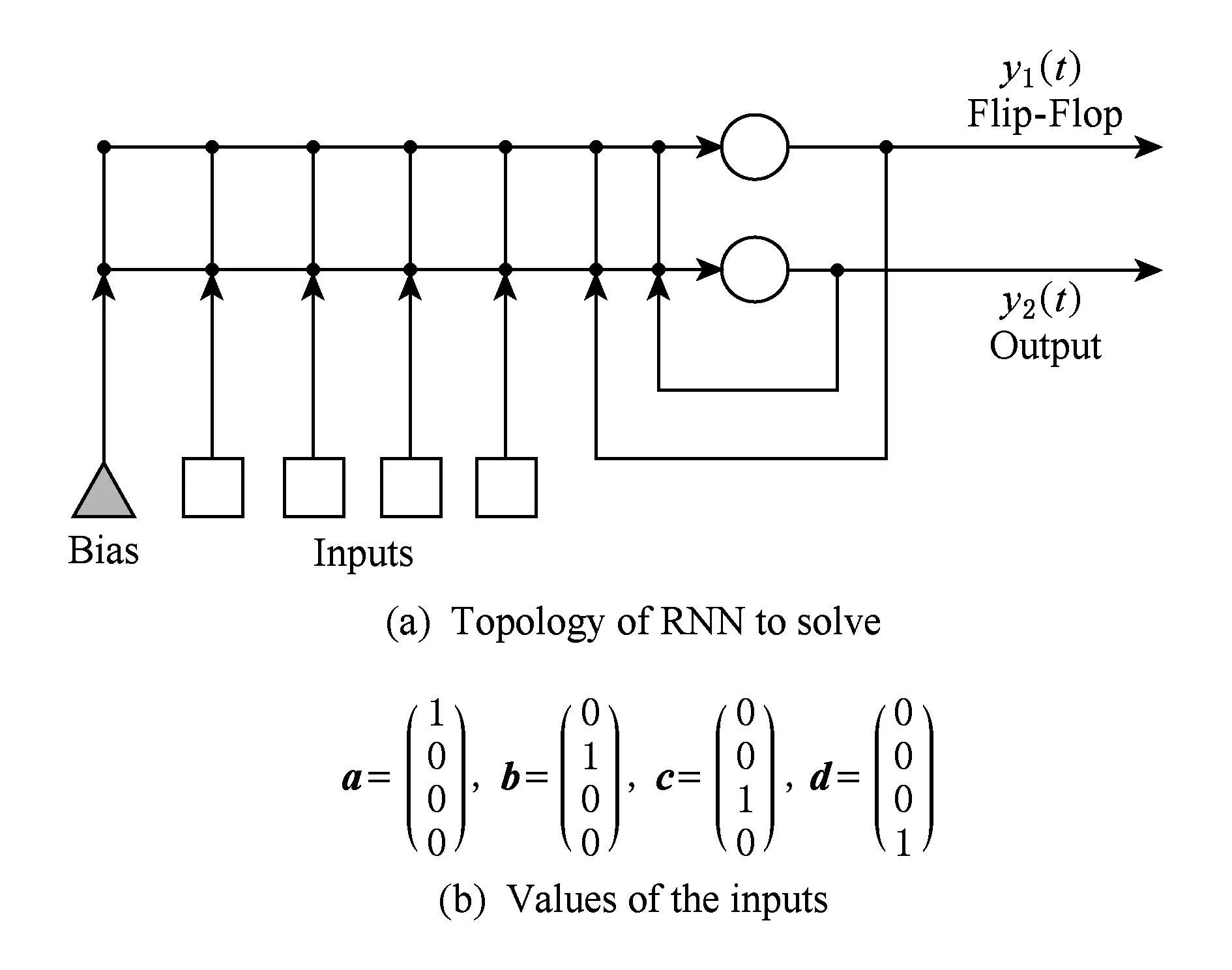

如本文前面所述,前饋網絡不能完成Bus Driver這個序列識別任務,但是使用僅有2個神經元的無限深度網絡卻可以很好地解決這個問題.網絡結構如圖7所示,其中一個神經元可作觸發器,另一個神經元的輸出作為網絡輸出.網絡有4個輸入,在每一個時刻隨機選取其中一個輸入的值為1,其他輸入的值為0,這就對應于a,b,c和d中的某一個字母,即一個時刻輸入一個字母,輸出規則為:如果a之后(可能經過多個干擾事件)出現了第1個b,網絡就輸出1,否則就輸出0.

Fig. 6 FNN cannot solve Bus Driver problem.圖6 前饋神經網絡無法完成Bus Driver問題

Fig. 7 Topology of RNN to solve Bus Driver problem and the values of the inputs.圖7 解決Bus Driver問題的無限深度神經網絡結構圖和輸入的值

“Bus Driver”問題的解決顯示了無限深度神經網絡的優勢:

1)學習并記憶以往模式;

2)利用記憶對

當前事件作出判斷;

3)在時間維度,自組織產生深度網絡.

2.3學習算法

神經網絡的計算能力,或者說“存儲的知識”,是體現在神經元之間的連接權值上.因此,學習算法就是調節網絡權值的方法,即:

(3)

權值調節的目標是使得網絡學習到某種知識,完成某一計算任務.網絡的計算任務通常量化為某種性能函數J(w)的優化.因此:

(4)

1) 性能函數

一般地,以一個有監督的序列學習任務為例,在任意時刻t,網絡均有外部輸入x(t)和目標輸出d(t).用T(t)表示目標輸出為dk(t)的神經元k的集合.那么,時刻t網絡中神經元k的輸出與目標輸出之間的誤差可表示為

(5)

網絡在時刻t的性能函數可表示為

(6)

若假設網絡運行的起止時間是t0和t1,則在時間段[t0,t1]內,網絡總的性能函數為

(7)

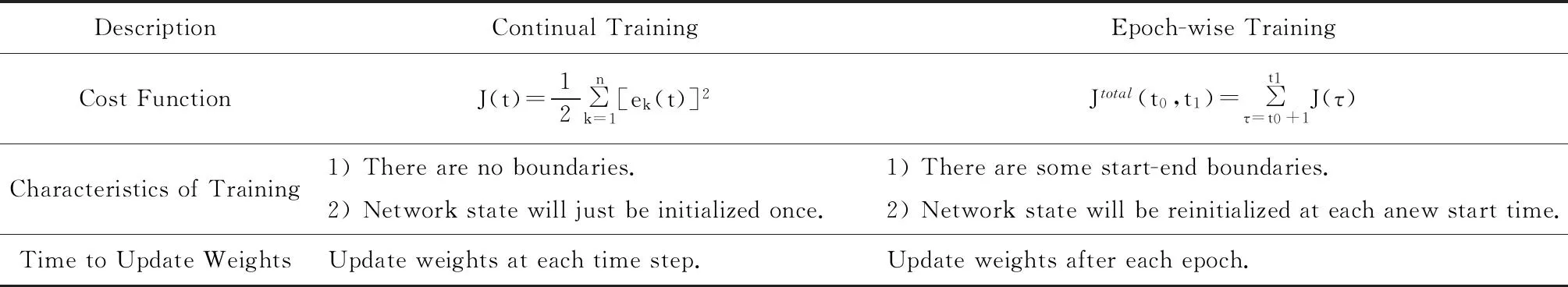

事實上,這2種性能函數對應于2種訓練方式:連續訓練(continual training)和階段性訓練(epochwise training),2種不同的訓練方式所具有的特點如表1所示:

Table 1 Difference Between Continual Training and Epoch-wise Training

雖然無限深度神經網絡早在20世紀80年代就被提出,但因為它本質上是一種動力學系統,所以其訓練比前饋網絡更復雜,存在更大的困難.下文我們將介紹3種具有代表性的無限深度網絡訓練方法,它們各有特色.

2) BPTT學習算法

BP算法是訓練前饋網絡最經典的算法,也取得了巨大的成功.基于BP算法的思想,美國Northeastern University大學的Williams R J教授在1990年提出了能夠訓練無限深度網絡的反向傳遞算法——BPTT (back-propagation through time)算法[10].

BPTT算法是經典BP算法的擴展,它首先按照2.1節所述的無限深度神經網絡按時間步展開的方法變換為一個前饋網絡,展開后的前饋網絡每層具有相同的權值,且與原來的回復式網絡權值相同,即對任意τ∈(t0,t],均有w(τ)=w.

根據階段性訓練和連續訓練2種不同的訓練方式,形成了Epoch-wiseBPTT和Real-timeBPTT兩種算法,如下所述:

①Epoch-wiseBPTT

Epoch-wiseBPTT采用階段性訓練方式調整網絡權值.采用該方式進行網絡訓練時,將用于無限深度神經網絡訓練的數據集分割成多個獨立的“段”,每一段表示一個感興趣的時序模式.假設某一個階段的開始時刻是t0,結束時刻是t1.由表1可知,在該階段的開始時刻t0,網絡狀態被重新初始化;在該階段的結束時刻t1,網絡權值進行更新;在[t0,t1]階段內,網絡的性能函數為

Epoch-wise BPTT算法的具體過程如下:

Ⅰ. 在時間階段[t0,t1]內,對網絡進行前向計算.

Ⅱ. 網絡運行到該階段的結束時刻t1時,通過性能函數對展開后的前饋神經網絡中每一層權值wi j(τ)的偏導疊加,計算性能函數Jtotal(t0,t1)對權值wi j的偏導,其中τ∈[t0+1,t1],即:

(8)

運用鏈式法則可知:

(9)

使用Epoch-wise BPTT算法訓練網絡時,定義網絡性能函數對神經元k的總輸入sk的敏感度δk=?Jtotal(t0,t1)?sk,網絡在某時刻τ對神經元k的注入誤差定義為

易知,網絡的性能函數Jtotal(t0,t1)與[t0+1,t]階段內的輸出y均有關.t0→t1前向計算的過程中,由于時刻τ網絡的輸出y(τ)=(y1(τ),y2(τ),…,yn(τ))T只對[τ,t1]的輸出y產生影響,因此在誤差回傳的過程中,神經元k的誤差δk(τ)只與由時刻t1傳至時刻τ+1的誤差δ(τ+1)=(δ1(τ+1),δ2(τ+1),…,δn(τ+1))T及時刻τ神經元k的注入錯誤ek(τ)相關.如圖8所示,δk(τ)由時刻τ+1的誤差δ(τ+1)和ek(τ)兩部分組成.因此

(10)

網絡性能函數在權值空間內的梯度為

(11)

Ⅲ. 誤差反向傳播到時刻t0+1時,更新網絡的權值.

(12)

Fig. 8 Illustration of Epoch-wise BPTT.圖8 Epoch-wise BPTT示意圖

② Real-time BPTT

Real-time BPTT采用實時(連續)方式調整網絡權值.假設網絡運行起始時刻是t0,當前時刻是t.由表1可知,與Epoch-wise BPTT不同,Real-time BPTT沒有階段的概念存在,網絡狀態只有在運行起始時刻t0被重新初始化,且網絡的權值不需要等到某一特定的時刻t1而是在運行中的每一時刻t都會被更新,網絡的性能函數為時刻t的性能函數J(t).

Real-time BPTT算法的具體過程如下:

Ⅰ. 使用時刻t-1更新后的權值w,前向計算時刻t網絡的輸出y(t)=(y1(t),y2(t),…,yn(t))T.對展開后的前饋神經網絡有wi j(τ)=wi j,其中τ∈[t0+1,t].

Ⅱ. 通過反向傳播算法,計算性能函數J(t)對權值wi j的偏導,可以通過性能函數對展開后的前饋神經網絡中每一層權重wi j(τ)的偏導疊加得到,其中τ∈[t0+1,t],即:

(13)

通過鏈式法則可知:

(14)

Fig. 9 Illustration of Real-time BPTT圖9 Real-time BPTT示意圖

與Epoch-wise BPTT不同,Real-time BPTT網絡的性能函數J(t)只與時刻t的輸出y(t)=(y1(t),y2(t),…,yn(t))T有關.t0→t前向計算的過程中,使用的是時刻t-1更新之后的權值w,由于時刻τ網絡的輸出y(τ)只對[τ+1,t]的輸出y產生影響,因此在誤差回傳的過程中,δk(τ)只與由時刻t傳至時刻τ+1的誤差δ(τ+1)=(δ1(τ+1),δ2(τ+1),…,δn(τ+1))T有關,如圖9所示.因此:

(15)

網絡性能函數在權值空間內的梯度為

(16)

Ⅲ. 更新網絡的權值:

(17)

3) RTRL學習算法

BPTT算法是基于反向傳播算法的擴展,誤差是從后向前傳播的.與BPTT不同,RTRL(real-time recurrent learning)是一種前向傳播“活動性”信息的算法.RTRL算法在20世紀80年代末被提出,該算法有多種不同的變形,分別由Robinson&Fallside[11],Bachrach[12],Mozer[13],Williams&Zipser[14]提出,本文針對Williams&Zipser提出的RTRL算法[15]進行討論.

(18)

同樣采用實時(連續)訓練方式,網絡在時刻t的性能函數為J(t),網絡的權值在每一時刻都會進行更新.假設網絡運行起始時刻是t0,當前時刻是t.由于yk(t)=f(sk(t)),因此網絡的活動性信息由t0→t遞歸傳遞為

(19)

其中,如果j∈U,則z(t-1)=yj(t-1);如果j∈I,則z(t-1)=xj(t-1).

網絡性能函數在權值空間內的梯度為

即:

(20)

同樣,更新網絡權值:

(21)

4) 傳統無限深度神經網絡的梯度問題

(22)

令uq=l,u0=k,可知:

(23)

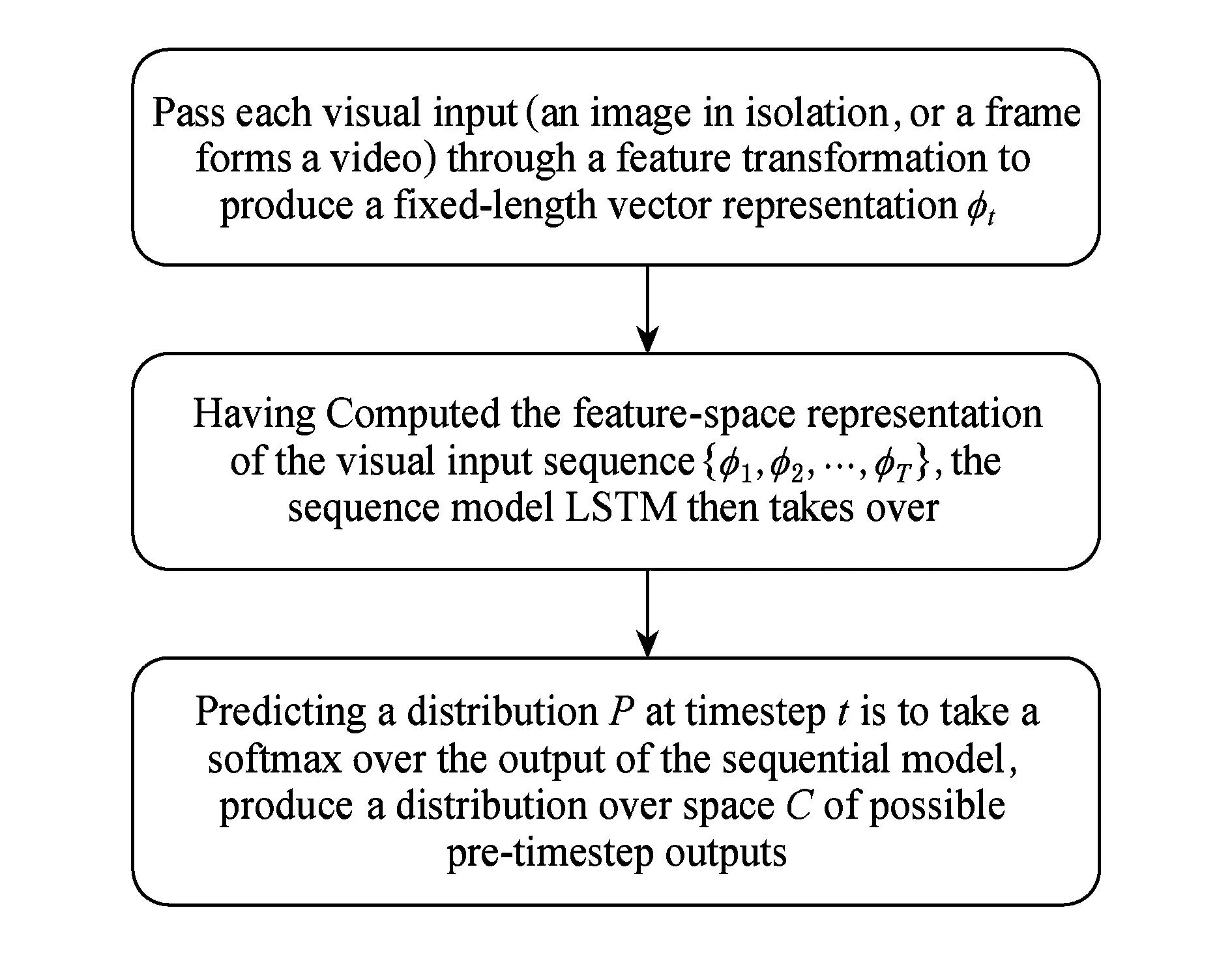

由于網絡的激活函數是非線性函數(一般為S型函數),則0 5) LSTM學習算法 為了解決無限深度神經網絡的“梯度消失”和“梯度爆炸”問題,瑞士人工智能實驗室的Schmidhuber教授于1997年提出了“長短時記憶”(long short-term memory, LSTM)網絡[16].之后又出現了LSTM的不同變形[17-18],本文主要介紹2000年Gers提出的改進LSTM算法[17]. Fig. 10 Illustration of LSTM.圖10 LSTM示意圖 由式(23)可知,如果網絡的激活函數是非線性函數,隨著q的增加網絡均會出現“梯度消失”或者“梯度爆炸”問題,一種有效的解決辦法是使用線性函數.圖10(a)所示的網絡結構可以解決傳統無限深度神經網絡梯度問題,稱該神經元為CEC(constant error carrousel).但是由于其激活函數是線性的,因此學習能力有限,并且存在“輸入輸出沖突問題”,輸入輸出問題在Schmidhuber教授的論文“Long Short-Term Memory”中給出了詳細的描述. Schmidhuber教授于1997年提出了“長短時記憶”(LSTM)網絡很好地解決了這一問題.之后其學生Graves在此基礎上對其進行發展,加上了Forget Gate.如圖10(b)所示是LSTM的一個Memory Block,其中包括多個Memory Cell,多個Memory Cell由一組Gate(Input Gate, Output Gate, Forget Gate)控制.一個LSTM網絡中可以包含多個Memory Block,不同的Memory Block由不同的Gate控制,同一個Memory Block的多個Memory Cell由同一組Gate共同控制.網絡由:輸入層、隱藏層、輸出層3部分組成,其中隱藏層除了Memory Block外也可以包含傳統無限深度神經網絡中的神經元,隱藏層采用全連接的方式. 網絡的訓練采用BPTT和RTRL相結合的方式:輸出層和Output Gate部分權值的訓練采用BPTT的方式進行,Forget Gate,Input Gate及網絡輸入部分的權值采用RTRL算法進行更新.同時,為了減少網絡學習的復雜度,采用了截斷(Truncate)的方式進行,即時刻t的Memory Cell和Gate的輸入{netc(t),netin(t),netout(t),netφ(t)}對時刻t-1網絡隱層的所有輸出不再敏感. 2.4在語音識別和圖像理解的應用實例 2.3節中介紹的這些經典學習算法,雖然大多發明于20世紀90年代,但隨著大數據浪潮的席卷而來,GPU等各種更加強大的計算設備的發展以及訓練深層網絡的新思路的提出[19-22],由于數據的極大豐富,這些無限深度學習的方法在實際應用中得到了飛躍性的發展.無限深度學習可以充分利用各種海量數據(標注數據、弱標注數據或者僅僅數據本身),完全自動地從海量數據中學習到數據中蘊含的抽象的知識表達,即把原始數據濃縮成某種知識.由于無限深度學習能夠大大提高任務的準確度,在短短的幾年時間里,無限深度學習已經顛覆了語義理解、圖像理解、文本理解等眾多領域的算法設計思路,漸漸形成了一種從訓練數據出發,經過一個端到端(end-to-end)的模型,然后直接輸出得到最終結果的一種新模式[23-29].本文中的無限深度神經網絡具有提取時序數據的時空特征等重要特性,雖然其優化過程相對于深度神經網絡更加困難,但是目前已經出現了BPTT,LSTM等很多解決方案和相關工作.另外,相較于基于前饋網絡結構的普通深度神經網絡而言,無限深度神經網絡也因此在時序數據處理任務中展現出了更強大的計算能力和優勢[23,30-31]. 以LSTM模型為例.在行為識別領域,基于LSTM的網絡模型能夠處理復雜的視頻序列,并能夠從傳統的視覺特征或深度特征中學習動態的時序信息,進而對視頻序列中的行為進行識別.在圖像理解領域,LSTM模型能夠在沒有任何明確的語言建模和語法結構定義的情況下,學習將單張圖像的像素強度映射成一個語法正確的自然語句,該語句能夠正確地描述該圖像.在視頻理解領域,LSTM能夠生成一個不定長的語句來正確地描述視頻內容.通過實驗驗證該模型在序列學習以及時空特征的提取上都展現出較強的處理能力. Fig. 11 Task-specific instantiations for activity recognition, image understanding, and video understanding.圖11 行為識別、圖像理解,視頻理解實例[31] Fig. 12 The flow chart of task-specific instantiations for activity recognition, image understanding, and video understanding.圖12 行為識別、圖像理解、視頻理解3個應用的處理流程 文獻[31]采用LRCN(long-term recurrent con-volutional network)模型在行為識別、圖像理解、視頻理解領域進行了研究并取得了較好的結果,如圖11所示.利用該方法,該文作者首先利用卷積神經網絡(CNN)提取靜態圖像的特征,但是對于行為識別、圖像理解、視頻理解等問題,更為復雜的任務是如何處理動態數據,然而類似于CNN,Autoencoder等前饋網絡無法提取數據中包含的時序特征,僅僅依靠這類前饋網絡無法實現該類復雜任務.因此,該文作者在利用卷積神經網絡(CNN)提取圖像靜態特征之后,用長短時記憶網絡(LSTM)提取時序特征.具體的處理過程如圖12所示:1)將一張圖像或者視頻中的一幀輸入到卷積網絡中得到一個固定長度的特征向量;2)將經過卷積網絡得到的特征序列輸入到LSTM中學習數據的時序特征;3)預測出在每個時間步詞表空間的概率分布,進而得到行為識別、圖像理解、視頻理解中每一幀圖像的識別結果或內容.以圖像理解為例具體闡述.該文作者在Flickr30K和COCO2014兩個數據集上展開了圖像理解研究,其中COCO2014包括有82 783張訓練集圖像、40 504張驗證集圖像及40 775張測試集圖像.在圖像理解任務中涉及的網絡架構包括:1個卷積神經網絡CNN(特征提取模塊)和4個長短時記憶網絡LSTM(序列學習模塊),在第4個長短時記憶網絡LSTM之后連接一個分類器.該實例中圖像理解具體的過程如下:在時刻t,特征提取模塊的輸入是待處理的圖像,序列學習模塊的輸入由卷積神經網絡提取出的特征φt及時刻t-1得到的單詞w(t-1)兩個部分組成.對于序列學習模塊,底層的長短時記憶網絡LSTM的輸入是時刻t-1得到的單詞w(t-1);第2個長短時記憶網絡LSTM的輸入包含第1個LSTM的輸出和卷積神經網絡CNN提取的特征φt,其輸出是得到兩者的級聯表達(joint representation);最后2個長短時記憶網絡LSTM的作用均是對第2個LSTM的結果進行更高層次的表達.分類器的輸入是第4個LSTM的輸出,即產生詞表空間中每個單詞可能是當前時刻目標單詞的概率P(wt|w1:t-1,φt),進而得到當前時刻的單詞w(t).GoogleDeepMind團隊成員Graves進一步發展了LSTM,并將其應用到了語音識別、人臉表情識別、手寫體識別、序列標注、序列生成等方面[27-29,32-34].在語音識別任務中,由于無限深度神經網絡能夠記住上下文,而前饋網絡只能處理當前幀,因此,無限深度神經網絡的識別精度相對于多層感知機(multi-layerperceptron,MLP)等前饋網絡更高,而且無限深度網絡的抗噪性能更強.文獻[35]將LSTM模型進行改進,更進一步將其用于并行處理大規模的語音序列.另外,在大詞匯量的語音識別任務(例如Google英語語音搜索任務)中,LSTM的識別精度明顯高于前饋網絡.在更具挑戰性的語義理解任務中,文獻[36]利用LSTM模型直接翻譯輸入語句,以實現將英語語句翻譯為法語語句的任務,并用實驗表明LSTM相比其他語義理解算法能夠取得更高的分數,其優勢尤其體現在短句的理解與翻譯.2009年基于LSTM模型構建的學習系統獲得了未切分草書的手寫體識別和語音識別任務的冠軍,這是第1個無限深度學習系統贏得官方的國際比賽[37].在文本理解領域,無限深度網絡能夠按順序處理一段話中的每個單詞,在處理后面的內容時,無限深度網絡的參數里還保留了前文信息的“抽象和整合”.由于其獨特的記憶功能,無限深度神經網絡已經被應用于文本理解領域[38-39]. 3總結與展望 近年來,基于回復式網絡結構的無限深度神經網絡計算方法得到了越來越廣泛的關注,并迅速成為了研究的熱點.2014年,谷歌的Sak等人利用無限深度神經網絡解決了大規模詞匯的語音識別問題[35],Sutskever等人將無限深度神經網絡方法用于機器翻譯上[36].今年,微軟雷德蒙研究院的Mesnil等人將無限深度神經網絡應用于口語理解問題[40];加州大學洛杉磯分校的Mao教授等人成功地利用無限深度神經網絡方法產生圖像標題[41];加州大學伯克利分校的Venugopalan教授等人將無限深度神經網絡方法應用到了視頻理解上面[42].百度的Deep Speech系統[43]也是基于無限深度神經網絡的方法建立的,其在公開數據集Switchboard Hub5’00上的正確率達到了84.0%.由此可見,無限深度神經網絡在處理時序數據方面具有巨大的潛力,在大數據分析預測任務中的強大計算能力日益顯現.隨著“結合智能計算的大數據分析”成為大數據時代的研究熱點,無限深度神經網絡計算領域更多新的理論和方法將被提出,其應用效果也必將不斷被刷新,推動大數據分析技術的發展和革新. 參考文獻 [1]White Paper on Big Data of the Telecommunications Research Institute of the Ministry of industry and Telecommunications(2014)[M]. Beijing: Telecommunications Research Institute of the Ministry of Industry and Information Technology, 2014 (in Chinese) (工信部電信研究院大數據白皮書(2014)[M].北京: 工業和信息化部電信研究院, 2014) [2]Intel IT Center. Big Data 101: Unstructured Data Analysis[MOL]. [2015-07-01]. http:www.intel.cncontentdamwwwpubliccnzhpdfsBig-data-101-Unstructured-data-Analytics.pdf, 2012 (in Chinese)(Intel IT Center. 大數據101:非結構化數據分析[MOL]. [2015-07-01]. http:www.intel.cncontentdamwwwpubliccnzhpdfsBig-data-101-Unstructured-data-Analytics.pdf, 2012) [3]Hinton G E, Salakhutdinov R R. Reducing the dimensionality of data with neural networks[J]. Science, 2006, 313(5786): 504-507 [4] Yu Kai, Jia Lei, Chen Yuqiang, et al. Yesterday, today and tomorrow of deep learning[J]. Journal of Computer research and development, 2013, 50(9): 1799-1804 (in Chinese)(余凱, 賈磊, 陳雨強, 等. 深度學習的昨天、今天和明天[J]. 計算機研究與發展, 2013, 50(9): 1799-1804) [5]Rosenblatt F. The perceptron: A probabilistic model for information storage and organization in the brain.[J]. Psychological Review, 1958, 65(6): 386-408 [6]Rumelhart D E, Hinton G E, Williams R J. Learning representations by back-propagating errors[J]. Nature, 1986, 323(6088): 533-536 [7]Huang G B, Chen L, Siew C K. Universal approximation using incremental constructive feedforward networks with random hidden nodes[J]. IEEE Trans on Neural Networks, 2006, 17(4): 879-892 [8]Vincent P, Larochelle H, Lajoie I, et al. Stacked denoising autoencoders: Learning useful representations in a deep network with a local denoising criterion[J]. Journal of Machine Learning Research, 2010, 11: 3371-3408 [9]LeCun Y, Bottou L, Bengio Y. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324 [10]Williams R J, Zipser D. Gradient-based learning algorithms for recurrent connectionist networks, NU-CCS-90-9[R]. Boston, MA: Northeastern University, 1990 [11]Robinson A J, Fallside F. The utility driven dynamic error propagation network[R]. Cambridge, UK: Department of Engineering, University of Cambridge, 1987 [12]Bachrach J. Learning to represent state[D]. Amherst, MA: University of Massachusetts Amherst, 1988 [13]Mozer M C. A focused back-propagation algorithm for temporal pattern recognition[J]. Complex Systems, 1989, 3(4): 349-381 [14]Williams R J, Zipser D. A learning algorithm for continually running fully recurrent neural networks[J]. Neural Computation, 1989, 1(2): 270-280 [15]Williams R J, Zipser D. Experimental analysis of the real-time recurrent learning algorithm[J]. Connection Science, 1989, 1(1): 87-111 [16]Hochreiter S, Schmidhuber J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780 [17]Gers F A, Schmidhuber J, et al. Learning to forget: Continual prediction with LSTM[J]. Neural Computation, 2000, 12(10): 2451-2471 [18]Gers F A, Schmidhuber J. Recurrent nets that time and count[C]Proc of the 2000 IEEE-INNS-ENNS Int Joint Conf on Neural Networks (IJCNN 2000). Piscataway, NJ: IEEE, 2000: 189-194 [19]Krizhevsky A. Convolutional deep belief networks on cifar-10[R]. Toronto, Ontario, Canada: University of Toronto, 2010 [20]Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C]Proc of Advances in Neural Information Processing Systems 25 (NIPS 2012). 2012: 1097-1105. [2015-11-17]. http:papers.nips.ccpaper4824-imagenet-classification-w [21]Kustikova V D, Druzhkov P N. A survey of deep learning methods and software for image classification and object detection[C]Proc of OGRW2014. 2014 [2015-11-17]. https:kola.opus.hbz-nrw.de [22]Jia Y, Shelhamer E, Donahue J, et al. Caffe: Convolutional architecture for fast feature embedding[C]Proc of the ACM Int Conf on Multimedia. New York: ACM, 2014: 675-678 [23]Mnih V, Heess N, Graves A. Recurrent models of visual attention[C]Proc of Advances in Neural Information Processing Systems 27 (NIPS 2014). 2014: 2204-2212.[2015-07-01]. http:papers.nips.ccpaper5542-recurrent-models-of-visual-attention [24]Vinyals O, Kaiser L, Koo T, et al. Grammar as a foreign language[J]. eprint arXiv:1412.7449, 2014 [25]Meng F, Lu Z, Tu Z, et al. Neural transformation machine: A new architecture for sequence-to-sequence learning[J]. eprint arXiv:1506.06442, 2015 [26]Tai K S, Socher R, Manning C D. Improved semantic representations from tree-structured long short-term memory networks[J]. eprint arXiv:1503.00075, 2015 [27]Graves A, Mohamed A, Hinton G. Speech recognition with deep recurrent neural networks[C]Proc of 2013 IEEE Int Conf on Acoustics, Speech and Signal Processing (ICASSP). Piscataway, NJ: IEEE, 2013: 6645-6649 [28]Graves A. Generating sequences with recurrent neural networks[J]. arXiv preprint arXiv:1308.0850, 2013 [29]Graves A, Jaitly N, Mohamed A. Hybrid speech recognition with deep bidirectional LSTM[C]Proc of 2013 IEEE Workshop on Automatic Speech Recognition and Understanding (ASRU). Piscataway, NJ: IEEE, 2013: 273-278 [30]Weber M, Liwicki M, Stricker D, et al. LSTM-based early recognition of motion patterns[C]Proc of the 22nd Int Conf on Pattern Recognition (ICPR2014). Piscataway, NJ: IEEE, 2014: 3552-3557 [31]Donahue J, Hendricks L A, Guadarrama S, et al. Long-term recurrent convolutional networks for visual recognition and description[J]. arXiv preprint arXiv:1411.4389, 2014 [32]Graves A. Supervised Sequence Labelling with Recurrent Neural networks[M]. Berlin: Springer, 2012 [33]Liwicki M, Graves A, Bunke H. Neural Networks for Handwriting Recognition[G]Computational Intelligence Paradigms in Advanced Pattern Classification. Berlin: Springer, 2012: 5-24 [34]Graves A. Generating sequences with recurrent neural networks[J]. arXiv preprint arXiv:1308.0850, 2013 [35]Sak H, Senior A, Beaufays F. Long short-term memory based recurrent neural network architectures for large vocabulary speech recognition[J]. arXiv preprint arXiv:1402.1128, 2014 [36]Sutskever I, Vinyals O, Le QVV. Sequence to sequence learning with neural networks[C]Proc of Advances in Neural Information Processing Systems 27 (NIPS 2014). 2014: 3104-3112. [2015-07-01]. http:papers.nips.ccpaper5346-information-based-learning-by-agents-in-unbounded-state-spaces [37]Graves A, Liwicki M, Fernandez S, et al. A novel connectionist system for improved unconstrained handwriting recognition[J]. IEEE Trans on Pattern Analysis and Machine Intelligence, 2009, 31(5): 855-868 [38]Eugene L, Caswell I. Making a manageable email experience with deep learning[R]. Palo Alto: Stanford University, 2015 [2015-07-01]. http:cs224d.stanford.edureportsEugeneLouis.pdf [39]Graves A. Offline Arabic Handwriting Recognition with Multidimensional Recurrent Neural Networks[G]Guide to OCR for Arabic Scripts. Berlin: Springer, 2012: 297-313 [40]Mesnil G, Dauphin Y, Yao K, et al. Using recurrent neural networks for slot filling in spoken language understanding[J]. IEEEACM Trans on Audio, Speech, and Language Processing, 2015, 23(3): 530-539 [41]Mao J, Xu W, Yang Y, et al. Deep captioning with multimodal recurrent neural networks[J]. eprint arXiv: 1412.6632, 2014 [42]Venugopalan S, Rohrbach M, Donahue J, et al. Sequence to sequence-video to text[J]. arXiv preprint arXiv:1505.00487, 2015 [43]Hannun A, Case C, Casper J, et al. DeepSpeech: Scaling up end-to-end speech recognition[J]. arXiv preprint arXiv: 1412.5567, 2014 Zhang Lei, born in 1980. Professor and PhD supervisor. Member of China Computer Federation. Her main research interests include big data, recurrent neural networks, deep learning and machine intelligence. Zhang Yi, born in 1963. Professor and PhD supervisor. His main research interests include big data, neural networks theory and its applications, deep learning and machine learning. 中圖法分類號TP183 基金項目:國家自然科學基金項目(61322203,61332002,61432012) 收稿日期:2015-07-16;修回日期:2015-11-18 This work was supported by the National Natural Science Foundation of China (61322203,61332002,61432012).