限制超級人工智能,需要中國參與

文 賽斯·鮑姆 編譯 孫夢璠

限制超級人工智能,需要中國參與

文 賽斯·鮑姆 編譯 孫夢璠

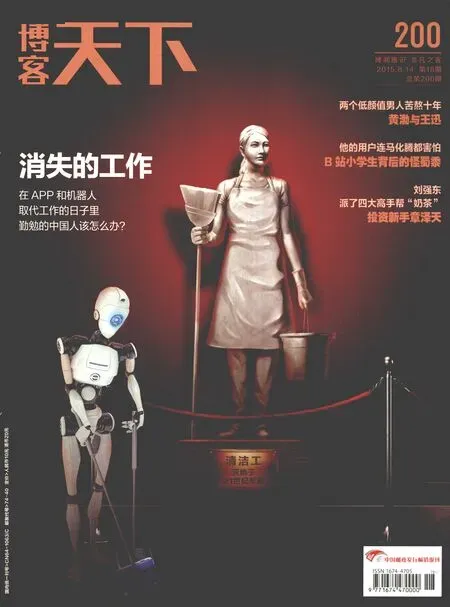

一旦機器人進化成為超級人工智能,人類極有可能完全無法招架或反攻。這種強弱形勢跟人和動物差不多—無論雞或豬如何努力,都無法擺脫由人類主宰的命運。

賽斯·鮑姆為美國非營利智庫全球風險研究所執行理事,也是生命未來研究所的資助對象,資助項目名為“超級人工智能安全發展路徑評估”

人工智能使人類受益良多。隨著科技不斷進步,人工智能仍將為人類帶來便利;但同時,與其他科技一樣,人工智能也可能造成危害。

當今國際上關于人工智能的爭論主要集中于自主武器,即能夠在無人干預情況下獨立搜索、識別并攻擊目標的新式武器。目前,人類還在控制著攻擊行為的決策過程,包括遠程無人機攻擊在內;僅有極少的情況不由人類決策,例如邊境自動防御系統。但是,自主武器的廣泛應用或許并不久遠。

自主武器的優勢早已為人熟知—讓士兵免受戰場傷害,同時避免了無人機操作者的疲勞問題。但另一方面,自主武器在識別攻擊對象的過程中,可能為了完成任務而毫無人性地傷害人類,導致更多人員傷亡。基于種種原因,人們開始反對自主武器,出現了Campaign to Stop Killer Robots(禁止機器人殺手運動)之類的國際非政府組織。

英國牛津大學哲學教授尼克·博斯特羅姆(Nick Bostrom)、美國加利福尼亞大學伯克利分校人工智能研究專家斯圖爾特·羅素(Stuart Russell)以及美國麻省理工學院物理學家馬克斯·泰格馬克(Max Tegmark)都曾表示對超級人工智能風險性的擔憂。幾年前,我曾在《技術預測與社會變革》期刊上發表文章,文中我收集了很多人工智能專家對超級人工智能的研究。我發現很多專家都在關注超級人工智能話題,包括超級人工智能是否會出現、何時將出現、可能帶來何種結果等。

對超級人工智能這種不可逆技術而言,前瞻性政策更顯必要。超級人工智能的智慧程度遠勝于人類,足以找到對抗人類行動的方法,所以我們不可能中途阻止它。如果不想落入這樣的被動境地,就必須防患于未然,在超級人工智能科技誕生之前,主動制定相關管理政策。

諸多專家認為,如果超級人工智能沒有被極其謹慎地設計,最有可能的后果便是——趕盡殺絕地球上的人類。機器人總是按部就班地執行命令,或許未來可以創造出一款能夠正確理解人類意圖的超級人工智能機器人。但如果沒有這套嚴密的程式算法,超級人工智能機器人便有可能違背人的本意,例如為了達成設定目標而傷害他人。

舉一個超級人工智能可能傷害人類的例子。假設人類研發出一款比“深藍”(Deep Blue,1997年戰勝了世界冠軍卡斯巴洛夫的超級計算機)更加高級的超級智能機器人,因為太“智能”,它可能會竭盡所能搜刮一切可用的計算資源,把整個地球乃至宇宙變成一個擁有更強下棋能力的巨型機器人;因為太“智能”,它有能力抵抗人類對自己的阻礙行為,人類及地球上的其他生物可能相繼死于機器人的手下。這些聽起來或許有些可笑,但確實是超級人工智能存在潛在風險的運行邏輯。

超級人工智能或許比《終結者》《黑客帝國》等電影中出現的邪惡機器人更具威脅。類似電影中出現的人類和機器人的“世界大戰”根本不可能發生,因為一旦機器人進化成為超級人工智能,人類極有可能完全無法招架或反攻。這種強弱形勢跟人和動物差不多——無論雞或豬如何努力,都無法擺脫由人類主宰的命運。

限制超級人工智能政策最重要的原則應為:不在存在風險的條件下開發超級人工智能。這一點必須各國合作,因為只要有一個國家為超級人工智能的研發開閘,便有可能帶來不可逆轉的災難。每個國家都應該加入這場保護人類免遭超級人工智能技術摧毀的戰斗,尤其是那些最有可能研發出此項技術的國家。

我有些同事質疑國際合作的可能性,他們大多來自美國或歐洲,認為其他國家不會有合作意愿,歐美才是親密同盟。其中,中國正是他們口中最常被提及、有可能制造危險性超級人工智能的國家。

坦率講包括中美在內的很多國家間仍存在緊張關系與沖突,這也是我的美國同事們認為中國可能研發危險性超級人工智能的原因之一。同樣,我也不會驚訝部分中國人對美國存有類似的擔憂。

但我不認同他們的觀點。首先,他們低估了國際社會主動應對的能力。當前關于自主武器的辯論,已經讓我們看到了國際社會的積極行動力。其次,他們低估了中國對世界安全積極貢獻的能力。例如,冷戰期間,在蘇聯和美國生產著數以萬計對世界存在破壞性威脅的核武器時,中國則僅持有數以百計的核武器,維持著規模更小、對世界更加安全的核武器儲備。

有人可能認為,中國之所以沒有參與美蘇核武器軍備競賽,是因為財力、技術的匱乏。沒錯,過去幾十年里可能是這樣,但現在已經完全不同了。崛起的中國已成為世界兩大經濟體之一,但仍然沒有加入美俄核均勢戰略中。相反,美國麻省理工學院副教授傅泰林、美國蘭德智庫麥艾文博士及美國國家安全委員會研究顯示,中國從毛澤東時代起就持有反對核武器競賽的一貫政策。中國能夠避免核武器軍備競賽,也有能力避免開發危險性的超級人工智能。

中國已成為與美國等少數國家比肩的世界主要大國之一,未來的幾十年甚至更長時間里仍將保持上升態勢。很多專家認為,研發超級人工智能需要數十年、上百年或者更久。到那時,中國可能在國際社會中承擔著更加重要的角色,我希望中國當今的年輕人仔細思考這個問題。

在防備危險性超級人工智能方面,中國可以考慮采取下面幾項措施:

首先,積極參與目前關于自主武器的辯論。盡管自主武器和超級人工智能大有不同,但限制自主武器需要國內外共同協作,也將使人工智能科技安全發展有例可援。最近,馬薩諸塞大學阿默斯特分校查理·卡彭特(Charli Carpenter)教授在美國《外交》雜志中,通過援引美國民意調查數據,力證自主武器與“公共良心”相悖而違反了國際法。中國也應該進行類似的民意調查。

其次,邀請國內外人工智能專家、風險安全專家和政策制定者參與公開對話。這不僅有助于政策制定做到“兼聽”,也有助于培養潛在超級人工智能締造者、人工智能專家群體的責任意識。索各種工種以及經濟將會受到的影響,進而分析不同的稅收、福利、教育、創新等政策會帶來怎樣的結果。“只有我們更清晰地了解這些狀況后,政府以及個人才會做出更加明智的決定。”

與AI影響下的失業以及經濟優化這些貼近現實的研究相比,對超級人工智能的研究更為理論。這個項目由旨在為人類對抗威脅提供解決方案的全球風險研究所承接。

完成理論項目并不比解決現實問題更容易。全球風險研究所的執行理事賽斯·鮑姆說:“項目研究最大的困難在于這是一項根本不存在的技術,甚至未來是否會出現也是問題。”

賽斯和他的團隊將根據既有的信息,利用故障樹形圖和影響圖等風險決策分析方面的方法構建模型,試圖模擬出超級人工智能的發展路徑以及不同的決策對這些路徑的影響。

正確理解人類意圖很重要

現階段,麥克斯最擔心的是以純粹的“目標導向”來發展人工智能的趨勢。

“機器沒有邪惡或者善良之分。機器只會更加智能,變得更‘自信’,它確信能夠實現目標。如果你有一個非常‘自信’而且比你更有能力的機器,它去完成它的一個目標任務時,你沒有辦法去阻止它。”他說。類似的場景在熱播美劇《硅谷》中有所呈現—一輛無人駕駛的汽車按照既定程序開到了一個孤島上,坐在車里的Jared完全無法阻止已經啟動了程序的汽車,被迫困在車里長達4天多。

所以,如何讓機器或者說人工智能不僅僅是去實現目標,而是去理解人們的真實想法,也是FLI資助很多項目的研究重點。

杜克大學的一個研究團隊就嘗試綜合運用計算機科學、哲學和心理學的方法,去建立一個能夠在現實場景中進行合理道德判斷和決策的人工智能系統,類似于權利(比如人類才有的隱私權)、角色(比如作為一個家庭成員)、過去的行為(比如承諾)、動機與目的等影響道德判斷的因素都會被AI系統加入進去。

尼克說自己無法精確回答自己的項目研究究竟能帶來什么。對于這些人類未知之事的研究,他認為,重要的是保持好的心態,“這是一個非常新的領域。帶著開放的心態不斷地去靠近、探索是很重要的。或許對外行人來說,他們很難去評估這些研究。而我們關注的點在于不斷地迎接我們所面臨的知識挑戰,取得實際意義上的進步,而非迎合某些人的好奇心。”

尼克覺得,現在很多名人被喜歡沖突的媒體塑造成了“AI反對者”,“對人工智能未來的發展而言,持極端看法是非常有害的。”事實上,對AI保持警惕的馬斯克也投資了一家發展人工智能的公司DeepMind和一家專注于讓機器人能像人一樣思考的公司Vicarious。

麥克斯認為,“我們并不想減緩一般的AI研究,只是會加速關于AI安全的研

FLI資助的項目

資助金額最高項目

項目名稱:人工智能戰略研究中心

項目負責人:Nick Bostrom

所在單位:牛津大學

資助金額:$1,500,000

資助金額最低項目

項目名稱:通過類人概念的學習教人工智能系統人類的價值觀

項目負責人:Kaj Sotala

所在單位:泰斯研究所

資助金額:$20,000

計算機科學(約占50%)

代表項目:驗證AI系統深層次的數學特性

項目負責人:Alex Aiken

所在單位:斯坦福大學

資助金額:$100,813

政策(約占20%)

代表項目:人工智能戰略研究中心

項目負責人:Nick Bostrom

所在單位:牛津大學

資助金額:$1,500,000

教育(約占15%)

代表項目:人工智能研究者的理性工具

項目負責人:Anna Salamon

所在單位:應用理性中心

資助金額:$111,757

法律、倫理和經濟(約占15%)

代表項目:理解并減少人工智能對金融系統的威脅

項目負責人:Michael Wellman

所在單位:密歇根大學

資助金額:$200,000

代表項目:人工智能經濟的優化過渡

項目負責人:Michael Webb

所在單位:斯坦福大學

資助金額:$76,318

代表項目:人工智能與工作的未來

項目負責人:Moshe Vardi

所在單位:萊斯大學

資助金額:$69,000究。我們像是在跟AI所帶來的風險競賽。目前還沒有什么事情在發生,但有可能一下子事情就發生了。我們希望開發人工智能的人也去思考下這些問題。”

在FIL官網的在線問答中,一位網友發問:“當達到甚至超越人類水平的人工智能出現的時候,人類還能控制世界嗎?”FIL回復說,如果人類不再是這個星球上最聰明的物種,很難講人類是否還能重新控制它。現在FIL正在借助“鋼鐵俠”的資本和世界上最強大的大腦來應對未來人類可能面臨的AI風險。■