移動(dòng)機(jī)器人高精度定位技術(shù)研究

楊楠

摘 要:移動(dòng)機(jī)器人在人們?nèi)粘I钪邪缪葜絹?lái)越重要的角色,高精度定位技術(shù)作為移動(dòng)機(jī)器人關(guān)鍵技術(shù)之一而得到廣泛關(guān)注與研究。研究分析了目前已有的定位技術(shù),并且提出一種改進(jìn)的基于圖像信息的移動(dòng)機(jī)器人自主定位技術(shù),從圖像中獲取特征點(diǎn),然后采用改進(jìn)的匹配算法匹配連續(xù)幀之間的特征點(diǎn),在已知相機(jī)參數(shù)的條件下計(jì)算出相機(jī)投影矩陣,解算出移動(dòng)機(jī)器人姿態(tài)矩陣。基于圖像信息的定位算法,克服了其他定位方法信號(hào)漂移、定位精度差的缺點(diǎn),并且該定位裝置具有價(jià)格低、易于安裝操作的特點(diǎn)。

關(guān)鍵詞:移動(dòng)機(jī)器人;高精度定位;視覺(jué)定位;特征匹配;相機(jī)投影矩陣

中圖分類(lèi)號(hào):TP391.4 文獻(xiàn)標(biāo)識(shí)碼:A 文章編號(hào):2095-1302(2015)04-00-02

0 引 言

目前被廣泛使用的GPS定位技術(shù),存在定位精度低、信號(hào)盲區(qū)、輸出頻率低等缺陷[1],因此新的定位技術(shù)[2]在不斷被探索。近幾年來(lái),由于圖像處理技術(shù)快速發(fā)展,運(yùn)用圖像方法輔助定位技術(shù)成為研究熱點(diǎn)[3,5-8],SHI Hang提出一種有效的景象匹配輔助GPS/SINS(GPS/SINS/SM)組合導(dǎo)航算法[3],主要目的在于修正GPS、SINS 以及GPS/ SINS 組合導(dǎo)航系統(tǒng)的估計(jì)誤差,提高系統(tǒng)的可靠性。美國(guó)NAVSYS公司開(kāi)發(fā)了一種CPS/慣性/圖像組合系統(tǒng)GI-Eye,研發(fā)出一種視頻校正技術(shù)并應(yīng)用在CPS /慣性/圖像傳感器中,使其在CPS信息連續(xù)丟失的情形下也可維持高精度的位置與姿態(tài)信息[4]。由于圖像匹配定位的精度很高,Sim利用這種精確的位置信息消除慣性導(dǎo)航系統(tǒng)長(zhǎng)時(shí)間工作的累計(jì)誤差,以便提高慣性導(dǎo)航系統(tǒng)的定位精度[5]。那么,對(duì)于無(wú)信號(hào)情況下的機(jī)器人自主定位問(wèn)題,也可以根據(jù)基于圖像匹配[6]獲取的機(jī)器人軌跡與初始位置信息來(lái)解決。Lowe提出的SIFT算法在視點(diǎn)變化、仿射變換和噪聲下具有良好的匹配性能[7];Ke提出PCA-SIFT算法將描述子從128維降到36維,提高了特征向量的匹配速度[8];Bay提出了SURF算法[9],主要根據(jù)Fast-Hessian矩陣的行列式檢測(cè)特征點(diǎn),利用Haar小波的局部響應(yīng)來(lái)描述特征。本文采用一種SURF匹配算法自適應(yīng)切換的移動(dòng)機(jī)器人運(yùn)行軌跡提取方法,可以實(shí)現(xiàn)無(wú)信號(hào)情況下的移動(dòng)機(jī)器人定位問(wèn)題,并且其精度滿足機(jī)器人行為安全分析要求。

1 算法總體設(shè)計(jì)

機(jī)器人運(yùn)行軌跡提取是利用高速率相機(jī)實(shí)時(shí)提取當(dāng)前路面圖像,根據(jù)圖像匹配算法計(jì)算當(dāng)前圖像與前一幀圖像的變化距離及變化角度,計(jì)算相機(jī)運(yùn)動(dòng)姿態(tài)反應(yīng)機(jī)器人運(yùn)動(dòng)狀態(tài)。利用路面圖像的變化反映機(jī)器人行駛變化,然后根據(jù)圖像坐標(biāo)系和機(jī)器人坐標(biāo)系之間的關(guān)系推算出其實(shí)際運(yùn)行軌跡。

此過(guò)程中,關(guān)鍵在于路面圖像的精確匹配。路面圖像紋理豐富、特征點(diǎn)多,所以本文首選采取了SURF特征匹配算法[9]。利用SURF算法檢測(cè)當(dāng)前圖像和前一幀圖像的特征點(diǎn),采用特征點(diǎn)特征向量的歐氏距離來(lái)作為兩幅圖像特征點(diǎn)的相似性判斷度量。找出當(dāng)前圖像與前一幀圖像中歐氏距離最近的前兩個(gè)特征點(diǎn),在這兩個(gè)特征點(diǎn)中,如果最近的距離除以次近的距離少于某個(gè)比例閾值,則接受這一對(duì)匹配點(diǎn)。因此選擇合適的閾值極其重要,本文選取的閾值為0.6,其在保證匹配穩(wěn)定性的前提下,提高匹配的準(zhǔn)確率,減少錯(cuò)誤匹配點(diǎn)數(shù)。

2 視覺(jué)定位技術(shù)

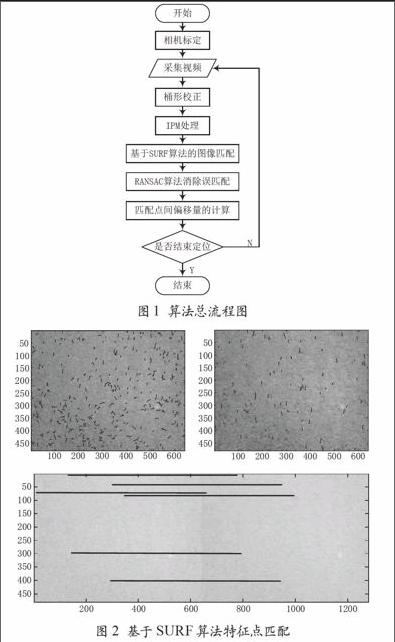

本文采用如圖1所示的算法對(duì)機(jī)器人姿態(tài)進(jìn)行解算。為了得到高精度的定位結(jié)果,需要預(yù)先知道相機(jī)參數(shù),因此首先對(duì)相機(jī)進(jìn)行標(biāo)定。本實(shí)驗(yàn)中所用相機(jī)為廣角鏡頭,故對(duì)圖像進(jìn)行桶形矯正處理,IPM變換的作用是將圖像變換成俯視圖便于圖像處理。針對(duì)雙目相機(jī)圖像的匹配,本文擬采用SURF算法。

SURF算法是一種基于快速魯棒特征的匹配算法,是目前效率較高的圖像局部特征提取及描述算法,主要應(yīng)用于圖像配準(zhǔn)與拼接方面。該算法主要包括特征點(diǎn)檢測(cè)、特征點(diǎn)描述以及特征點(diǎn)匹配3個(gè)部分。

2.1 特征點(diǎn)檢測(cè)

2.2 特征點(diǎn)描述

在以特征點(diǎn)為圓心,半徑為6σ(σ為尺度)的圓內(nèi),計(jì)算Harr小波響應(yīng)值dx,dy,對(duì)之進(jìn)行高斯加權(quán),記為Wdx,Wdy。然后對(duì)加權(quán)后的響應(yīng)值進(jìn)行直方圖統(tǒng)計(jì),將一個(gè)圓的360°分成72組(每組5°)的60°大小扇形區(qū)域,分別對(duì)每個(gè)區(qū)域內(nèi)的哈爾小波響應(yīng)值相加計(jì)算得到一個(gè)新的矢量,最后選擇最長(zhǎng)的矢量方向作為該特征點(diǎn)的主方向。

確定主方向后,以特征點(diǎn)為中心,選取中心點(diǎn)鄰域范圍內(nèi)20σ*20σ大小的區(qū)域,然后將區(qū)域的主方向旋轉(zhuǎn)到特征點(diǎn)的主方向。將此區(qū)域劃分為4*4共16個(gè)子區(qū)域。對(duì)每個(gè)子區(qū)域,計(jì)算每個(gè)像素點(diǎn)經(jīng)過(guò)加權(quán)的Harr小波在X方向和Y方向的響應(yīng)值dx,dy,然后建立一個(gè)四維的特征向量如下:

對(duì)于前一幀圖像上的特征點(diǎn),計(jì)算它到后一幀圖像上所有特征點(diǎn)的絕對(duì)值距離,得到一個(gè)距離集合。通過(guò)對(duì)距離集合進(jìn)行比較運(yùn)算得到最小絕對(duì)值距離和次最小絕對(duì)值距離。設(shè)定一個(gè)閾值T,當(dāng)最小絕對(duì)值距離和次最小絕對(duì)值距離的比值小于T時(shí),認(rèn)為具有最小絕對(duì)值距離的特征點(diǎn)是匹配的,否則沒(méi)有點(diǎn)與該特征點(diǎn)相匹配。閾值設(shè)定越小,配準(zhǔn)點(diǎn)對(duì)越少,但配準(zhǔn)更穩(wěn)定。

3 實(shí)驗(yàn)結(jié)果及總結(jié)

采用機(jī)器人上安裝的相機(jī)采集路面圖像,對(duì)圖像處理從而得到運(yùn)行軌跡。拍攝路面長(zhǎng)度為6 m,可以轉(zhuǎn)化成279幀圖像,圖像大小為640*480,采用SURF算法對(duì)圖像進(jìn)行特征點(diǎn)檢測(cè)和特征點(diǎn)匹配。圖2為該視頻中采用SURF算法匹配結(jié)果。其中,前兩幀圖像分別為前一幀和當(dāng)前幀圖像,然后是兩幀圖像的匹配結(jié)果。

計(jì)算每幅圖像所有正確匹配點(diǎn)的偏移量和角度,然后使用其均值繪制軌跡。運(yùn)行距離單位以像素點(diǎn)計(jì),圖像移動(dòng)長(zhǎng)度與機(jī)器人實(shí)際運(yùn)行長(zhǎng)度的轉(zhuǎn)換比例依賴于實(shí)際拍攝時(shí)相機(jī)的位置。在本文實(shí)驗(yàn)壞境下,可粗略獲得換算比例為1 m:580pixels,計(jì)算軌跡誤差,明顯可知誤差范圍<1 m,由于人為拍攝,存在輕微抖動(dòng),但不影響整體運(yùn)行趨勢(shì)。

本文提出了一種基于SURF點(diǎn)匹配的機(jī)器人移動(dòng)軌跡提取方法。該方法首先通過(guò)SURF算法與基于SURF獲取匹配點(diǎn)。計(jì)算匹配點(diǎn)之間的偏移量和角度,采用分類(lèi)法消除錯(cuò)誤的匹配點(diǎn),最后根據(jù)正確匹配點(diǎn)之間的偏移量和角度,繪制運(yùn)行軌跡。該方法保證了機(jī)器人軌跡提取的連續(xù)性,精確度滿足機(jī)器人行為安全分析的誤差要求。

參考文獻(xiàn)

[1] Yuan Xin, Yu Jixiang, Chen Zhe. Navigation System[M]. Beijing: Publishing House of Aeronautics Industry,1993.

[2] Gezici S. A survey on wireless position estimation[J]. Wireless Personal Communications, 2008, 44(3): 263-282.

[3] SHI H, YAN L, LIU B, et al. GPS/SINS integrated navigation algorithm aided by scene matching[J]. Journal of Tsinghua University (Science and Technology), 2008,48(7): 1182-1185,1189.

[4] Conte G, Doherty P. An integrated UAV navigation system based on aerial image matching[C]//Aerospace Conference, 2008 IEEE. IEEE, 2008: 1-10.

[5] Sim D G, Park R H, Kim R C, et al. Integrated position estimation using aerial image sequences[J]. Pattern Analysis and Machine Intelligence, IEEE Transactions on, 2002, 24(1): 1-18.

[6] 趙玲.基于視覺(jué)和超聲傳感器融合的移動(dòng)機(jī)器人導(dǎo)航系統(tǒng)研究[D].武漢:武漢理工大學(xué),2007.

[7] Lowe D G. Distinctive image features from scale-invariant keypoints[J]. International journal of computer vision, 2004, 60(2): 91-110.

[8] Ke Y, Sukthankar R. PCA-SIFT: A more distinctive representation for local image descriptors[C]//Computer Vision and Pattern Recognition, 2004. CVPR 2004. Proceedings of the 2004 IEEE Computer Society Conference on. IEEE, 2004(2):506-513.

[9] Bay H, Tuytelaars T, Van Gool L. Surf: Speeded up robust features[C]. Computer Vision–ECCV 2006, 2006: 404-417.

- 物聯(lián)網(wǎng)技術(shù)的其它文章

- 基于DIAlux的公路隧道照明設(shè)計(jì)研究

- 物聯(lián)網(wǎng)應(yīng)用技術(shù)專業(yè)課的微課程設(shè)計(jì)要點(diǎn)分析

- 基于物聯(lián)技術(shù)的運(yùn)動(dòng)規(guī)劃系統(tǒng)設(shè)計(jì)與構(gòu)建

- 城市道路交叉口仿真評(píng)價(jià)及優(yōu)化配時(shí)

- 校園網(wǎng)絡(luò)監(jiān)控系統(tǒng)的設(shè)計(jì)

- 企業(yè)全網(wǎng)日志綜合管理系統(tǒng)設(shè)計(jì)