用于3DTV的圖像繪制技術(shù)*

安 平 ,張 倩 ,鞠 芹 ,王 賀 ,張兆楊

(1.上海大學(xué) 通信與信息工程學(xué)院,上海 200072;2.上海大學(xué) 新型顯示技術(shù)及應(yīng)用集成教育部重點實驗室,上海 200072)

1 引言

多視點成像是指用攝像機陣列同時獲取動態(tài)時變場景,獲得高性能的多視點視頻數(shù)據(jù),使人眼能直接從立體顯示設(shè)備中獲得具有真實、立體、交互甚至現(xiàn)實世界無法獲取的視覺內(nèi)容,由此逐漸引起人們的高度興趣和重視,其中,三維電視(3DTV)是最重要的應(yīng)用之一[1],成為繼高清晰度電視(HDTV)之后的下一代電視技術(shù),有廣闊的應(yīng)用前景。

3DTV能夠給用戶交互式的3D深度感覺[2],可讓用戶自由選擇視點,通過3D立體顯示器顯示3D圖像,給用戶身臨其境的立體感。如何發(fā)展自由視點視頻的新的視點繪制方法是決定3DTV立體圖像質(zhì)量的關(guān)鍵技術(shù)之一。基于深度圖像的繪制(DIBR)、基于光線空間的繪制以及光場繪制是3類典型的圖像繪制技術(shù)[3]。針對3DTV應(yīng)用,筆者將這3類圖像繪制技術(shù)用于3DTV虛擬視點圖像的生成,提出了幾種改進的圖像繪制方法,生成的新視點圖像具有良好的質(zhì)量。

2 基于DIBR和圖像融合的任意視點繪制

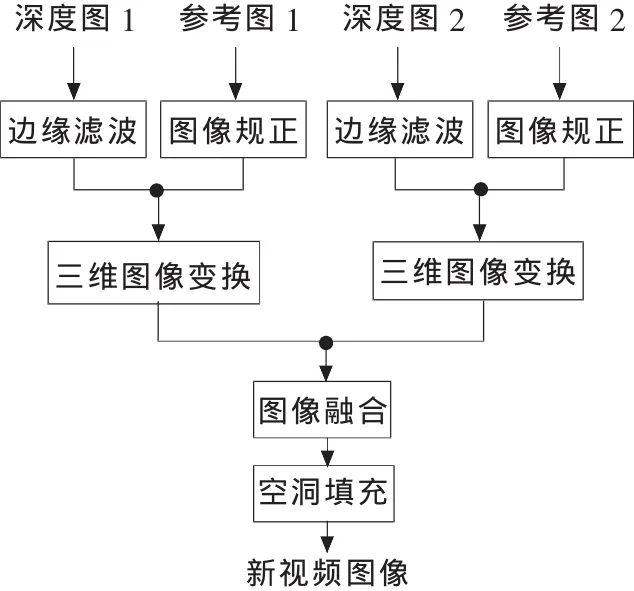

基于深度圖像的繪制(DIBR)技術(shù)[4]利用三維圖像變換方程將參考圖像中的像素映射到目標(biāo)圖像中。由于將場景的深度信息引入到圖像繪制中,因此DIBR能大大減少參考圖像的數(shù)目。為此,提出一種高效的基于DIBR和圖像融合的新視點生成方法,與一般的DIBR方法相比,本方法對目標(biāo)攝像機的位置沒有限制,適用于生成真實場景的任意新視點圖像。首先對參考圖像進行預(yù)處理,包括深度圖像邊緣濾波和彩色圖像規(guī)正,以減少在目標(biāo)圖像中產(chǎn)生的較大空洞以及虛假邊緣;然后利用三維圖像變換生成新視點圖像,并對兩幅目標(biāo)圖像進行融合得到新視點圖像,最后用插值法填充剩余的較小空洞。算法流程如圖1所示。

圖1 基于DIBR的新視點生成算法框圖

2.1 用邊緣濾波預(yù)處理深度圖

用邊緣濾波器[5]平滑深度圖像中深度值有較大變化的所有區(qū)域 (對象的邊緣部分而不僅僅是水平邊緣部分)。為了減少贗像,在平滑深度圖的時候,應(yīng)當(dāng)保持前景物體的深度值不變,因為人眼對前景對象的變化比對背景的變化要敏感。

2.2 三維圖像變換

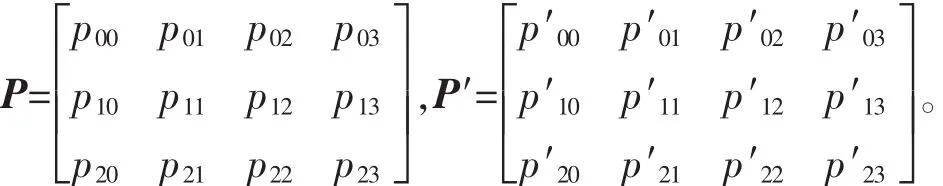

推出一種簡潔高效的三維圖像變換方程式

2.3 圖像融合

利用三維圖像變換方程,根據(jù)深度信息可將參考圖像中的像素坐標(biāo)映射到目標(biāo)圖像中的對應(yīng)位置。使用兩幅參考圖像分別生成目標(biāo)圖像,然后再將這兩幅目標(biāo)圖像融合成最終的新視點圖像,克服了僅由一幅參考圖像提供信息的不充分性。

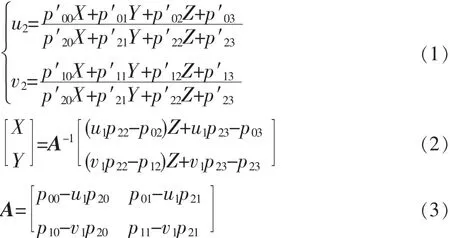

2.4 實驗結(jié)果

用上述DIBR算法,對Microsoft Research提供的“Ballet”序列的測試結(jié)果如圖2所示。攝像機4圖像(見圖2a)生成的攝像機5圖像如圖2d所示,攝像機6圖像(見圖2b)生成的攝像機5圖像如圖2e所示,圖2d和圖2e融合的結(jié)果示于圖2f。與攝像機5的原始圖像(圖2c)相比,融合后生成的攝像機5圖像的峰值信噪比(PSNR)可達(dá)32.03 dB,圖像質(zhì)量好,真實感強。

3 基于光線空間的自由視點繪制

光線空間表示法是實現(xiàn)復(fù)雜場景3DTV的關(guān)鍵技術(shù),能在沒有任何幾何信息的前提下,利用一系列參考圖像產(chǎn)生新視點圖像。為了繪制出高真實感的新視點圖像,需要對場景進行密集采樣,但是在實際應(yīng)用中,密集采樣非常復(fù)雜而且代價昂貴,因此主要利用稀疏采樣的光線空間數(shù)據(jù)進行新視點的繪制。

3.1 方法描述

首先需要求得從左到右以及從右到左的視差,可采用各種成熟且效果好的視差估計算法。然后需要根據(jù)視差找到對應(yīng)點在中間視點圖像上的坐標(biāo)位置,這一過程需要將計算得到的視差投影到中間虛擬視點圖像上。

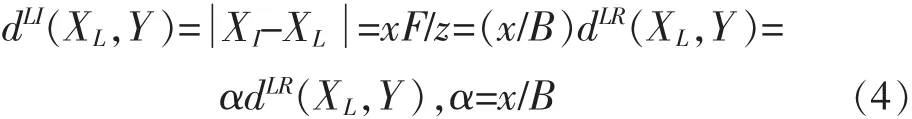

設(shè)平行攝像系統(tǒng),攝像機基線距離為B、焦距為F。假設(shè)場景中一點P與攝像機的距離為z,且P在最左端和最右端圖像平面上的投影點為 PL和 PR,設(shè) dLR(x,y)表示以左圖像為參考,從左到右的視差,則 dLR(XL,Y)=。

設(shè)中間攝像機CI到最左端攝像機的距離為x,則在無遮擋時CI的視差為

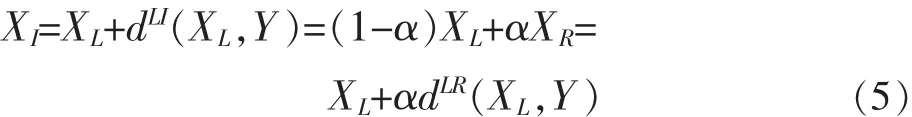

視點CI中對應(yīng)點的坐標(biāo)值XI為

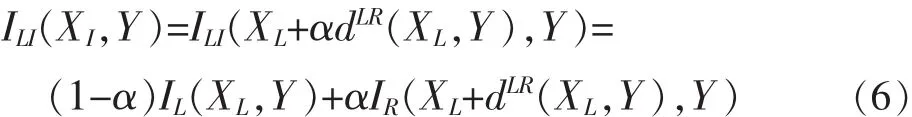

若已知中間虛擬攝像機位置α、左右圖像匹配點的相對位置XL和 XR(或者 XL和 dLR),則點 P在中間虛擬攝像機圖像上投影點的坐標(biāo)XI可以由式(5)得到,由此可以獲得XI的灰度值

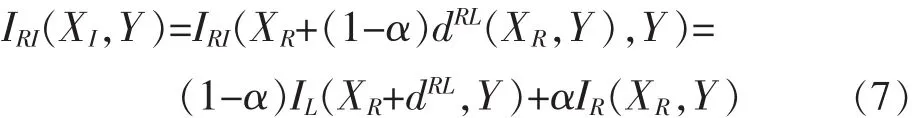

若以右圖像作為參考圖像,以dRL表示從右到左的視差,同理可以得到

當(dāng)中間虛擬圖像中某一像素點(X,Y)在左右圖像中都有對應(yīng)點時,將式(6)和式(7)進行加權(quán)平均作為它的灰度值,即

對遮擋作如下處理:對中間虛擬視點圖像中橫坐標(biāo)X<α·ImageWidth和 X>α·ImageWidth區(qū)域的內(nèi)容分別主要從左參考圖像和右參考圖像中獲取。

3.2 實驗結(jié)果

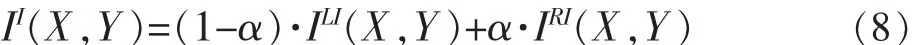

用實驗室實拍序列“小熊”測試了以上算法,實驗結(jié)果如圖3所示。其中圖3a和3b分別為最左端和最右端的參考圖像,圖3c為生成的新視點圖像,可見本文方法生成的圖像主觀質(zhì)量良好。

4 基于光場繪制的新視點生成算法

光場繪制利用參考圖像數(shù)據(jù)庫來合成新視點圖像,其過程可以看作光線查找和插值的過程。為克服一般光場繪制存在的深度固定和焦距固定的缺點,提出一種新的光線數(shù)據(jù)庫的參數(shù)化方法,該方法能在較低光場采樣的條件下利用一個可變焦平面重構(gòu)深度值未知且有較大變化的場景,同時還能交互地實現(xiàn)改變焦距和改變景深的功能。

4.1 算法流程

設(shè)一條光線r=(s,t,u,v)的顏色值 c(r)=c(s,t,u,v),光線r與目標(biāo)圖像平面交點的像素坐標(biāo)為 (x,y),并且(x,y)的顏色值為 c(x,y),用 K 表示投影中心為 o的目標(biāo)攝像機。令w(x,y)表示光圈加權(quán)函數(shù),δ為光圈寬度。對于參考攝像機DS,t,用RC表示一個由所確定的多邊形 C,用 Rk表示 RC在目標(biāo)攝像機圖像平面上的投影。對于在Rk內(nèi)的每一個像素(x,y),用 r表示穿過 o 和(x,y)的一條光線。

第一步,求出目標(biāo)光線r與平面C與F的交點(s′,t′)和(f,g)F,并且設(shè)定好虛擬光圈的大小,即確定那些參考攝像機的光線參與對目標(biāo)光線r的重構(gòu);第二步,利用映射求出光線 r與目標(biāo)圖像平面的交點(u,v);第三步,根據(jù)第一步得到的(s′,t′),計算不同參考光線對應(yīng)的加權(quán)函數(shù)weight;第四步,根據(jù)第一步確定的虛擬光圈大小及第三步確定的加權(quán)函數(shù)weight,利用方程來計算目標(biāo)圖像上坐標(biāo)為(x,y)的像素的顏色值。

4.2 實驗結(jié)果

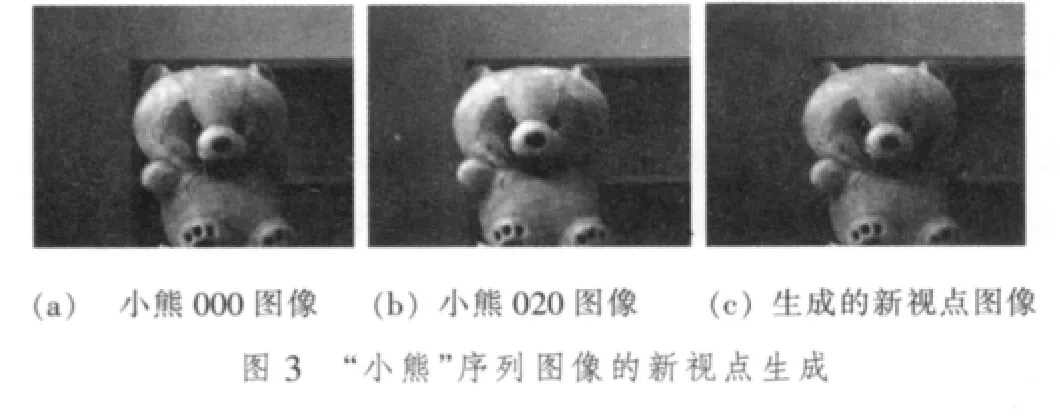

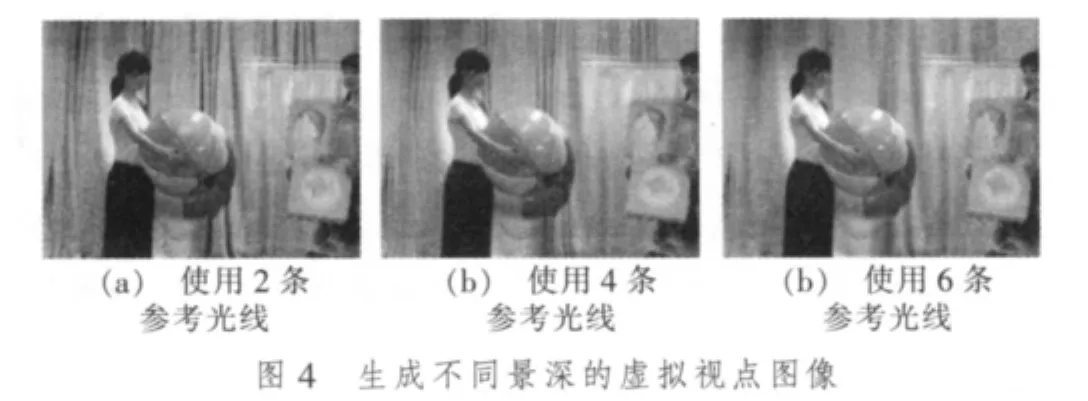

用日本名古屋大學(xué)提供的測試序列“Akko&Kayo”對提出的算法進行驗證。圖4為利用不同的虛擬光圈生成的具有不同景深效果的虛擬視點圖像,其中圖4a,4b,4c分別為使用2,4,6條參考光線來合成虛擬光圈。圖5為前后移動焦平面時生成的具有不同焦距的新視點圖像,其中圖5a,5b,5c分別為聚焦在左邊人手位置、左邊人臉位置和中間窗簾位置時的效果。

可見,所提算法不僅能夠利用2D稀疏攝像機陣列生成任意位置的虛擬視點圖像,還可以通過交互地改變焦平面的位置和虛擬光圈的大小實現(xiàn)改變焦距和改變景深的功能。

5 小結(jié)

筆者對3類圖像繪制技術(shù)的典型方法進行了改進,提出基于DIBR和圖像融合的新視點生成算法、基于視差估計的光線空間插值方法、新的光場參數(shù)化方法。所提出的新視點圖像繪制方法實驗效果良好,適用于真實場景的任意視點繪制,可用于3DTV的場景渲染,滿足觀眾交互性視點變化的要求。

[1]KUBOTA A,SMOLIC A,MAGNOR M,et al.Multiview imaging and 3DTV[J].IEEE Signal Processing Magazine,2007,24(6):10-21.

[2]MATUSIK W,PFISTER H.3DTV:a scalable system for real-time acquisition, transmission and autostereoscopic display of dynamic scenes[EB/OL].[2009-03-01.]http://people.csail.mit.edu/wojciech/3DTV/3DTV.pdf.

[3]CHEN Wan yu,CHANG Yu lin,LIN S F,et al.Efficient depth image based rendering with edge dependent depth filter and interpolation[C]//Proc.IEEE International Conference on Multimedia and Expo, 2005(ICME 2005).[S.l.]:IEEE Press,2005:1314-1317.

[4]鞠芹,安平,張倩,等.高質(zhì)量的虛擬視點圖像的繪制方法[J].電視技術(shù),2009,33(9):9-11.

[5]ZHANG C,CHEN T.A survey on image-based rendering-representation, sampling, and compression[J].Signal Processing:Image Communication,2004,19(1):1-28.